No mundo da IA, a frase "força bruta resolve tudo" parece ter se tornado uma regra de ouro. Quanto maior o modelo, mais dados e maior a capacidade de processamento, mais perto parecemos estar do Santo Graal da inteligência. No entanto, por trás desse avanço meteórico, escondem-se enormes pressões de custo e consumo de energia.

Para tornar o treinamento de IA mais eficiente, os cientistas têm procurado otimizadores mais poderosos, como um treinador que guia os parâmetros do modelo para otimização contínua, atingindo o estado ideal. O AdamW, como otimizador padrão de pré-treinamento do Transformer, tem sido um marco na indústria por anos. No entanto, diante da crescente escala de modelos, o AdamW começa a mostrar suas limitações.

Não existe um método que melhore a velocidade de treinamento e reduza o consumo de energia? Não se preocupe, uma equipe totalmente chinesa chega com sua "arma secreta": C-AdamW!

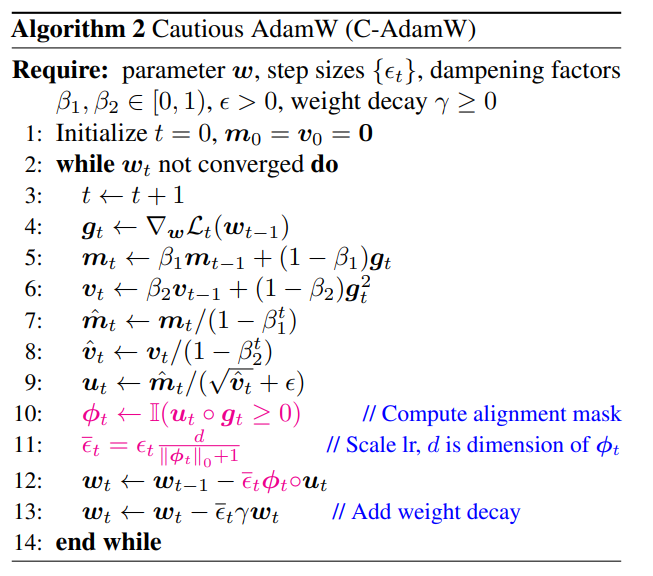

C-AdamW, abreviação de Cautious AdamW, significa "AdamW Cauteloso". Soa "zen-budismo", não é? De fato, a ideia central do C-AdamW é "pensar três vezes antes de agir".

Imagine os parâmetros do modelo como um grupo de crianças cheias de energia, sempre querendo correr por aí. O AdamW é como um professor dedicado, tentando guiá-las na direção certa. Mas às vezes, as crianças ficam muito animadas, desviam do caminho e acabam perdendo tempo e energia.

Nesse momento, o C-AdamW atua como um sábio ancião, com "olhos de águia", capaz de identificar com precisão se a direção da atualização está correta. Se estiver errado, o C-AdamW para imediatamente, evitando que o modelo se afaste cada vez mais do caminho certo.

Essa estratégia "cautelosa" garante que cada atualização reduza efetivamente a função de perda, acelerando a velocidade de convergência do modelo. Os resultados experimentais mostram que o C-AdamW aumentou a velocidade de treinamento em até 1,47 vezes no pré-treinamento Llama e MAE!

Mais importante ainda, o C-AdamW quase não apresenta custo computacional adicional; basta uma simples modificação de linha no código existente. Isso significa que os desenvolvedores podem facilmente aplicar o C-AdamW a vários treinamentos de modelos, desfrutando de "velocidade e emoção"!

O aspecto "zen" do C-AdamW reside na preservação da função hamiltoniana do Adam e na garantia de convergência sob análise de Lyapunov. Isso significa que o C-AdamW não é apenas mais rápido, mas também mais estável, evitando problemas como falhas de treinamento.

Claro, "zen" não significa "inércia". A equipe de pesquisa afirma que continuará explorando funções ϕ mais ricas e aplicando máscaras no espaço de recursos, em vez do espaço de parâmetros, para melhorar ainda mais o desempenho do C-AdamW.

É previsível que o C-AdamW se torne o queridinho do campo de aprendizado profundo, revolucionando o treinamento de grandes modelos!

Endereço do artigo: https://arxiv.org/abs/2411.16085

GitHub:

https://github.com/kyleliang919/C-Optim