Um importante benchmark no campo da inteligência artificial, o ARC-AGI (Abstract and Reasoning Corpus para Inteligência Artificial Geral), está prestes a alcançar um avanço significativo. No entanto, o criador do teste, François Chollet, alerta que, apesar da melhoria nos resultados, isso não significa que estamos próximos de alcançar a inteligência artificial geral (AGI). Ele aponta que o próprio teste apresenta falhas de design e que seus resultados não refletem necessariamente verdadeiras descobertas científicas.

Desde que Chollet lançou o ARC-AGI em 2019, os sistemas de IA têm apresentado desempenho insatisfatório no teste. Até hoje, o sistema com melhor desempenho conseguiu resolver menos de um terço das tarefas. Chollet afirma que isso se deve principalmente à dependência excessiva da pesquisa atual em inteligência artificial em grandes modelos de linguagem (LLMs). Ele observa que, embora os LLMs consigam identificar padrões ao processar grandes quantidades de dados, eles dependem da memória e não da razão, dificultando o tratamento de novas situações desconhecidas ou a realização de "raciocínio" verdadeiro.

“Os modelos LLM dependem da extração de padrões dos dados de treinamento, em vez de realizar raciocínio independente. Eles apenas 'memorizam' os padrões, em vez de gerar novos raciocínios”, explicou Chollet em uma série de postagens na plataforma X.

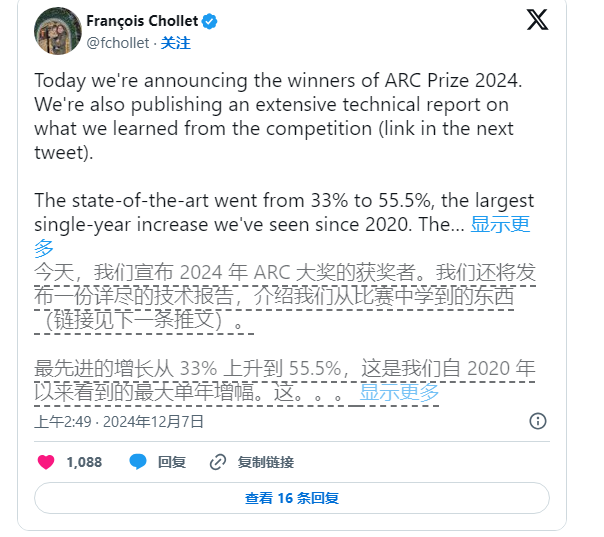

Apesar disso, Chollet não parou de impulsionar a pesquisa em IA. Em junho deste ano, ele e Mike Knoop, fundador da Zapier, lançaram uma competição de US$ 1 milhão para incentivar o desafio de IA de código aberto ao benchmark ARC-AGI. Embora o melhor sistema de IA entre as 17.789 inscrições tenha obtido apenas 55,5% da pontuação, abaixo dos 85% necessários para atingir o nível "humano", Chollet e Knoop consideram isso um passo importante.

Knoop apontou em um post de blog que esse resultado não significa que estamos mais perto de alcançar a AGI, mas sim que algumas tarefas no ARC-AGI dependem muito de soluções "brute force" (força bruta), que não fornecem necessariamente um sinal válido para a inteligência geral verdadeira. O ARC-AGI foi projetado para testar a capacidade de generalização da IA, fornecendo tarefas complexas e inéditas. No entanto, ainda há dúvidas sobre a eficácia dessas tarefas na avaliação da AGI.

Nota da imagem: Imagem gerada por IA, provedor de serviços de licenciamento de imagens Midjourney

As tarefas do benchmark ARC-AGI incluem quebra-cabeças que exigem que a IA deduza respostas desconhecidas com base em informações conhecidas. Embora essas tarefas pareçam promover a adaptação da IA a novas situações, os resultados sugerem que os modelos existentes parecem encontrar soluções por meio de cálculos extensivos, e não necessariamente demonstrando verdadeira capacidade de adaptação inteligente.

Além disso, os criadores do ARC-AGI também enfrentam críticas de colegas, especialmente quanto à ambiguidade na definição de AGI. Um funcionário da OpenAI afirmou recentemente que, se a AGI for definida como uma inteligência artificial que "desempenha melhor do que a maioria dos humanos na maioria das tarefas", então a AGI já foi alcançada. No entanto, Chollet e Knoop acreditam que o design atual do benchmark ARC-AGI ainda não atingiu esse objetivo.

Para o futuro, Chollet e Knoop planejam lançar uma segunda geração do benchmark ARC-AGI e realizarão uma nova competição em 2025 para resolver as deficiências do teste atual. Eles afirmam que o novo benchmark focará em direcionar a pesquisa de IA para áreas mais importantes e acelerar o processo de alcançar a AGI.

No entanto, corrigir o benchmark existente não é uma tarefa fácil. Os esforços de Chollet e Knoop demonstram que definir a inteligência artificial, especialmente no campo da inteligência geral, continua sendo uma tarefa árdua e complexa.