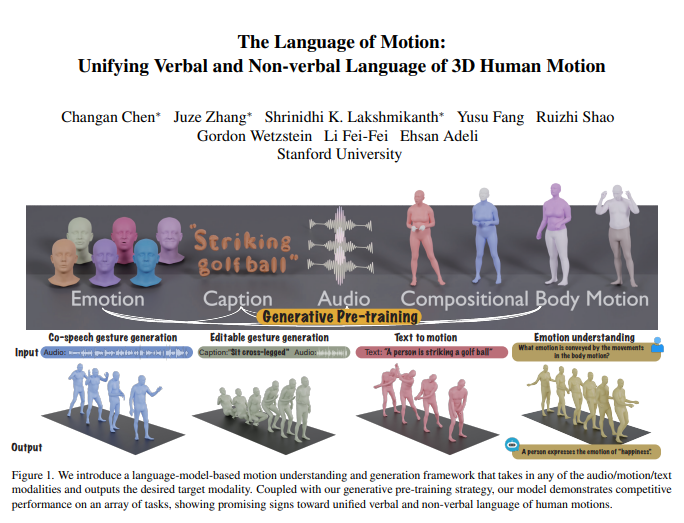

A equipe de Fei-Fei Li lançou um novo modelo multimodal que consegue compreender e gerar ações humanas, e, ao combinar com um modelo de linguagem, realiza o processamento unificado de linguagem verbal e não verbal. Esta pesquisa inovadora permite que as máquinas não apenas entendam instruções humanas, mas também interpretem as emoções contidas nas ações, resultando em uma interação humano-máquina mais natural.

O núcleo do modelo reside em sua estrutura de modelo de linguagem multimodal, capaz de receber entradas em várias formas, como áudio, ações e texto, e gerar dados modais necessários. Combinado com uma estratégia de pré-treinamento generativa, o modelo demonstra desempenho excepcional em várias tarefas. Por exemplo, na geração de gestos de voz colaborativos, o modelo não apenas supera o estado da arte, mas também reduz significativamente a quantidade de dados necessários para treinamento. Além disso, o modelo desbloqueia novos cenários de aplicação, como a geração de gestos editáveis e a previsão de emoções por meio de ações.

A comunicação humana é inerentemente multimodal, incluindo pistas verbais e não verbais, como voz, expressões faciais e postura corporal. A capacidade deste modelo de compreender esses comportamentos multimodais é crucial para a criação de personagens virtuais que se comunicam naturalmente em aplicações como jogos, filmes e realidade virtual. No entanto, os modelos de geração de movimento existentes geralmente são limitados a modalidades de entrada específicas (dados de voz, texto ou movimento), sem aproveitar totalmente a diversidade dos dados disponíveis.

O modelo utiliza um modelo de linguagem para unificar a linguagem verbal e não verbal por três razões principais:

Os modelos de linguagem conectam naturalmente diferentes modalidades.

A fala possui alta semântica, e modelar tarefas como reagir a piadas requer forte capacidade de raciocínio semântico.

Os modelos de linguagem adquirem forte capacidade de compreensão semântica por meio de amplo pré-treinamento.

Para atingir esse objetivo, a equipe de pesquisa primeiro dividiu o corpo em diferentes partes (rosto, mãos, parte superior do corpo, parte inferior do corpo) e rotulou os movimentos de cada parte separadamente. Combinando os tokenizadores de texto e voz, qualquer entrada modal pode ser representada como uma sequência de tokens para uso pelo modelo de linguagem. O modelo emprega um processo de treinamento em duas etapas: primeiro, o pré-treinamento para alinhar várias modalidades com movimentos corporais combinados, bem como áudio e texto. Em seguida, as tarefas a jusante são transformadas em instruções, e o modelo é treinado nessas instruções para que possa seguir várias instruções de tarefas.

O modelo apresentou desempenho excepcional no benchmark de geração de gestos de voz colaborativos BEATv2, superando modelos existentes. A eficácia da estratégia de pré-treinamento também foi comprovada, especialmente em cenários com escassez de dados, mostrando forte capacidade de generalização. Através do treinamento posterior em tarefas de voz-ação e texto-ação, o modelo pode não apenas seguir prompts de áudio e texto, mas também realizar novas funções, como prever emoções a partir de dados de ação.

Em termos de detalhes técnicos, o modelo emprega tokenizadores específicos de modalidade para processar várias modalidades de entrada. Especificamente, o modelo treinou um VQ-VAE de movimento corporal combinado, convertendo os movimentos do rosto, mãos, parte superior e inferior do corpo em tokens discretos. Esses vocabulários específicos de modalidade (áudio e texto) são combinados em um vocabulário multimodal unificado. Durante o treinamento, tokens mistos de diferentes modalidades são usados como entrada e um modelo de linguagem codificador-decodificador gera a saída.

O modelo também utiliza um vocabulário multimodal para converter diferentes dados modais em um formato unificado para processamento. Na fase de pré-treinamento, o modelo aprende as correspondências entre diferentes modalidades executando tarefas de conversão entre modalidades. Por exemplo, o modelo pode aprender a converter movimentos da parte superior do corpo em movimentos da parte inferior do corpo ou áudio em texto. Além disso, o modelo também aprende a evolução temporal do movimento mascarando aleatoriamente alguns quadros de movimento.

Na fase de treinamento posterior, o modelo é ajustado fino usando dados emparelhados para executar tarefas a jusante, como geração de gestos de voz colaborativos ou geração de texto para ação. Para permitir que o modelo siga instruções humanas naturais, os pesquisadores construíram um modelo de seguimento de instruções multitarefas, convertendo tarefas como áudio para ação, texto para ação e emoção para ação em instruções. O modelo também possui a capacidade de editar gestos, podendo gerar movimentos corporais completos e colaborativos com base em prompts de texto e áudio.

Finalmente, o modelo também desbloqueou a nova capacidade de prever emoções a partir de ações. Isso tem implicações significativas para áreas como saúde mental ou psiquiatria. Em comparação com outros modelos, o modelo consegue prever com mais precisão as emoções expressas em ações, mostrando uma forte capacidade de compreensão da linguagem corporal.

Esta pesquisa demonstra que a unificação da linguagem verbal e não verbal de ações humanas é crucial para aplicações práticas, e os modelos de linguagem fornecem uma estrutura robusta para isso.

Endereço do artigo: https://arxiv.org/pdf/2412.10523v1