Treinar grandes modelos de IA (como Transformers e modelos de linguagem) tornou-se um componente essencial no campo da IA, mas enfrenta altos custos computacionais, consumo de memória e demanda de energia. Por exemplo, o GPT-3 da OpenAI possui 175 bilhões de parâmetros e requer semanas de treinamento em GPU. Essa enorme demanda de recursos limita o uso dessa tecnologia a organizações com recursos computacionais em larga escala, além de aumentar as preocupações com a eficiência energética e o impacto ambiental. Resolver esses desafios é crucial para garantir a acessibilidade e a sustentabilidade mais amplas do desenvolvimento da IA.

Métodos de treinamento tradicionais são ineficientes e soluções inovadoras são urgentemente necessárias.

A principal razão para a baixa eficiência do treinamento de modelos grandes é sua dependência de matrizes densas, o que requer muita memória e capacidade computacional. A compatibilidade limitada de GPUs modernas com operações de baixa precisão ou baixa classificação otimizadas agrava ainda mais essas necessidades. Embora alguns métodos, como decomposição de matrizes e redução de classificação heurística, tenham sido propostos para mitigar esses problemas, eles ainda são limitados em aplicações práticas. Por exemplo, o GaLore pode treinar em uma configuração de lote único, mas apresenta uma sobrecarga de tempo de execução impraticável. Da mesma forma, o LTE, que usa adaptadores de baixa classificação, apresenta problemas de convergência em tarefas grandes. Atualmente, falta um método que possa reduzir simultaneamente o uso de memória, o custo computacional e o tempo de treinamento sem comprometer o desempenho, o que torna a necessidade de soluções inovadoras urgente.

Estrutura CoMERA: treinamento eficiente por meio de otimização de tensor adaptativa

Pesquisadores da Universidade de Albany (Universidade Estadual de Nova York), da Universidade da Califórnia em Santa Bárbara, da Amazon Alexa AI e do Meta lançaram uma nova estrutura chamada CoMERA (método de treinamento eficiente em termos de computação e memória por meio de otimização de tensor de classificação adaptativa). Esta estrutura combina eficiência de memória e velocidade computacional por meio de técnicas de compressão de tensor de classificação adaptativa. Ao contrário dos métodos tradicionais que se concentram apenas na compressão, o CoMERA usa um método de otimização multiobjetivo para equilibrar a taxa de compressão e a precisão do modelo. Ele utiliza embeddings tensorizados e contração avançada de redes tensoriais para otimizar o uso da GPU, reduzindo assim a sobrecarga de tempo de execução, mantendo ao mesmo tempo um desempenho robusto. A estrutura também introduz gráficos CUDA para minimizar o atraso de inicialização do kernel durante as operações da GPU, um gargalo principal nos métodos tradicionais de compressão de tensor.

O CoMERA baseia-se em uma representação de tensor adaptativa, que permite que as camadas do modelo ajustem dinamicamente sua classificação de acordo com as restrições de recursos. Ao modificar a classificação do tensor, a estrutura pode alcançar a compressão sem comprometer a integridade das operações da rede neural. Essa otimização dinâmica é alcançada por meio de um processo de treinamento em duas etapas:

Estágio inicial: foco na convergência estável.

Estágio posterior: ajuste fino da classificação para atender a objetivos de compressão específicos.

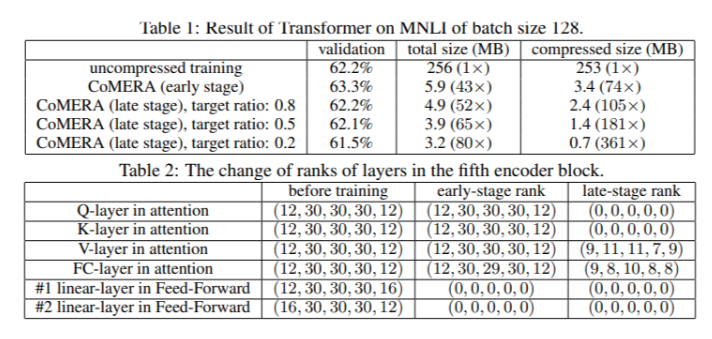

Em um modelo Transformer de seis codificadores, o CoMERA alcançou uma taxa de compressão de até 43 vezes em seu estágio inicial e até 361 vezes em seu estágio de otimização posterior. Além disso, em comparação com o GaLore, ele reduziu o consumo de memória em 9 vezes e aumentou a velocidade de treinamento por época em 2 a 3 vezes.

Múltiplos resultados de teste demonstram o desempenho superior do CoMERA

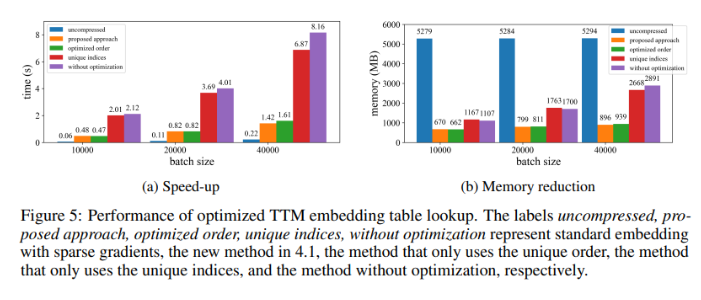

Ao ser aplicado a um modelo Transformer treinado no conjunto de dados MNLI, o CoMERA reduziu o tamanho do modelo de 256 MB para apenas 3,2 MB, mantendo a precisão. Em sistemas de recomendação em larga escala, como o DLRM, o CoMERA comprimiu o modelo em 99 vezes e reduziu o uso de memória de pico em 7 vezes. A estrutura também teve um desempenho excelente no pré-treinamento do CodeBERT (um grande modelo de linguagem de domínio específico), obtendo uma taxa de compressão geral de 4,23 vezes e alcançando uma aceleração de 2 vezes em algumas etapas de treinamento. Esses resultados destacam sua capacidade de lidar com várias tarefas e arquiteturas, expandindo sua aplicabilidade em vários campos.

Resumo das principais vantagens da estrutura CoMERA

As principais conclusões desta pesquisa são:

O CoMERA alcançou uma taxa de compressão de até 361 vezes para camadas específicas e 99 vezes para o modelo inteiro, reduzindo significativamente as necessidades de armazenamento e memória.

A estrutura reduziu o tempo de treinamento por época para Transformers e sistemas de recomendação em 2 a 3 vezes, economizando recursos computacionais e tempo.

Usando representações tensorizadas e gráficos CUDA, o CoMERA reduziu o consumo de memória de pico em 7 vezes, tornando possível o treinamento em GPUs menores.

O método CoMERA suporta várias arquiteturas, incluindo Transformers e grandes modelos de linguagem, mantendo ou melhorando a precisão.

Ao reduzir a energia e os recursos necessários para o treinamento, o CoMERA contribui para práticas de IA mais sustentáveis e permite que uma gama mais ampla de usuários acesse modelos de ponta.