No final do ano fiscal da Beijing Zhihu Hua Zhang Technology Co., Ltd., a empresa lançou a versão inicial do GLM-Zero-Preview, seu primeiro modelo de raciocínio treinado com base em aprendizado por reforço expandido. Este modelo se concentra em melhorar a capacidade de raciocínio da inteligência artificial, especialmente em lógica matemática, programação e resolução de problemas complexos que exigem raciocínio profundo. Em comparação com o modelo base, o GLM-Zero-Preview mantém sua capacidade em tarefas gerais, mas apresenta uma melhoria significativa em tarefas especializadas, com desempenho comparável ao OpenAI o1-preview nos benchmarks AIME2024, MATH500 e LiveCodeBench.

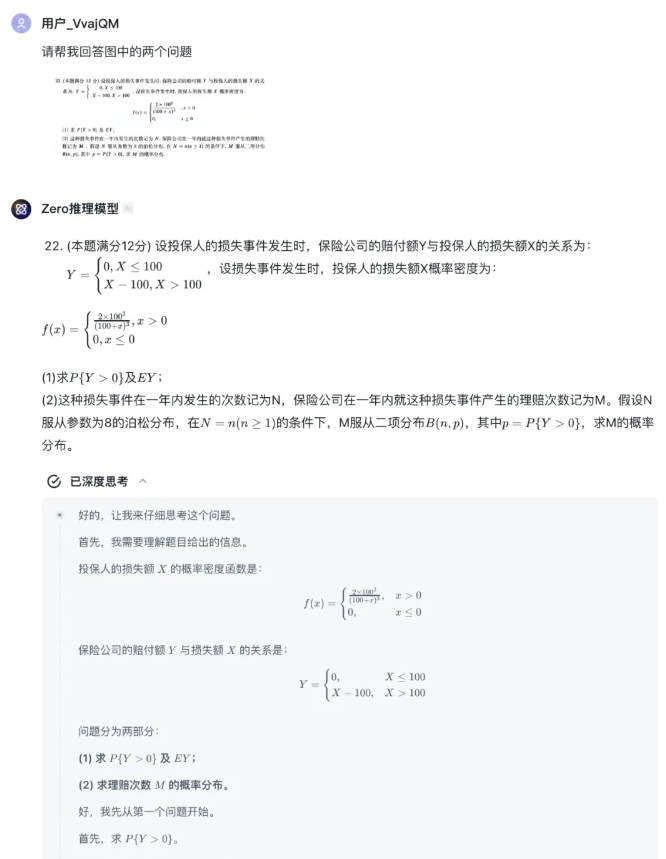

Os usuários agora podem experimentar gratuitamente o GLM-Zero-Preview no agente "Modelo de Raciocínio Zero" da plataforma Zhihu Qingyan, que suporta upload de texto e imagens, com o modelo fornecendo o processo de raciocínio completo. Os desenvolvedores também podem acessar este modelo por meio da API da plataforma aberta Zhihu.

Embora ainda haja uma diferença entre o GLM-Zero-Preview e o modelo o3 da OpenAI, a Beijing Zhihu Hua Zhang Technology Co., Ltd. planeja continuar otimizando e iterando a tecnologia de aprendizado por reforço, e em breve lançará a versão oficial do GLM-Zero, expandindo a capacidade de pensamento profundo de lógica matemática para mais áreas de tecnologia geral.

Em termos de desempenho do modelo, o GLM-Zero-Preview demonstra a importância do aprendizado por reforço no aprimoramento da capacidade de raciocínio profundo do modelo. Com o aumento da quantidade de treinamento, o desempenho do modelo em raciocínio profundo melhora constantemente. A lei de dimensionamento na fase de raciocínio também foi verificada, ou seja, com o aumento do número de tokens que o modelo pode processar e com maior poder computacional, a qualidade dos resultados fornecidos pelo modelo também melhora constantemente. O GLM-Zero-Preview pode tomar decisões autônomas, decompor problemas e tentar várias maneiras de resolvê-los durante o processo de raciocínio, semelhante ao processo de tomada de decisão humana.

Em casos de teste, o GLM-Zero-Preview demonstrou a capacidade de identificar falhas lógicas e simular várias hipóteses em raciocínio lógico. Em matemática, o modelo possui forte capacidade de indução e dedução, podendo processar rapidamente cálculos matemáticos complexos e atingir o nível de um excelente pós-graduando no exame de matemática de 2025 para o primeiro ano de pós-graduação. Em programação, o GLM-Zero-Preview pode usar várias linguagens de programação e ajudar os desenvolvedores a escrever código rapidamente.

Zhihu Qingyan:

https://chatglm.cn/main/gdetail/676411c38945bbc58a905d31?lang=zh

Plataforma Aberta Zhihu:

https://bigmodel.cn/dev/api/normal-model/glm-zero-preview