A empresa Mistral anunciou recentemente o lançamento de seu mais recente modelo de codificação de código aberto: Codestral25.01, uma atualização de seu popular modelo de codificação Codestral. Esta versão apresenta otimizações de arquitetura que resultam em um aumento significativo de desempenho, tornando-se o "líder claro em codificação pesada", com velocidade duas vezes maior que a versão anterior.

Similar ao Codestral original, o Codestral25.01 continua focado em baixa latência e operações de alta frequência, suportando tarefas de correção de código, geração de testes e preenchimento intermediário. A Mistral afirma que esta versão é especialmente adequada para empresas que precisam de mais dados e residência de modelos. Testes de benchmark mostram que o Codestral25.01 superou as expectativas nos testes de codificação Python, alcançando uma pontuação de 86,6% no teste HumanEval, superando a versão anterior, o Codellama70B Instruct e o DeepSeek Coder33B Instruct.

Os desenvolvedores podem acessar o modelo através do plug-in Mistral IDE e da ferramenta de implantação local Continue. Além disso, a Mistral oferece acesso à API através do Google Vertex AI e da Mistral la Plateforme. O modelo está atualmente disponível em prévia no Azure AI Foundry e será lançado em breve na plataforma Amazon Bedrock.

Desde seu lançamento no ano passado, o Codestral da Mistral se tornou um dos principais modelos de código aberto focados em código. A versão inicial do Codestral era um modelo de 22 bilhões de parâmetros, suportando até 80 idiomas e superando muitos concorrentes em desempenho de codificação. Em seguida, a Mistral lançou o Codestral-Mamba, um modelo de geração de código baseado na arquitetura Mamba, capaz de lidar com strings de código mais longas e atender a mais requisitos de entrada.

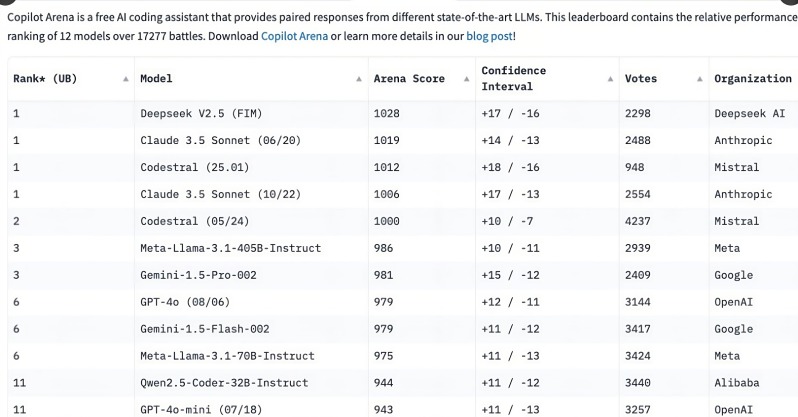

O lançamento do Codestral25.01 gerou grande interesse entre os desenvolvedores, alcançando as primeiras posições no ranking do C o pilot Arena em poucas horas após seu lançamento. Essa tendência indica que modelos de codificação especializados estão se tornando rapidamente a escolha preferencial dos desenvolvedores, especialmente em tarefas de codificação, onde a demanda por modelos de codificação focados é cada vez mais evidente em comparação com modelos multifuncionais genéricos.

Embora modelos genéricos como o o3 da OpenAI e o Claude da Anthropic também possam codificar, os modelos de codificação especializados tendem a apresentar desempenho superior. No último ano, várias empresas lançaram modelos especializados em codificação, como o Qwen2.5-Coder da Alibaba e o DeepSeek Coder chinês, este último sendo o primeiro a superar o GPT-4 Turbo. Além disso, a Microsoft lançou o GRIN-MoE, um modelo baseado em Mixture of Experts (MOE), que não apenas codifica, mas também resolve problemas matemáticos.

Embora os desenvolvedores ainda debatam a escolha entre modelos genéricos e especializados, o rápido crescimento dos modelos de codificação demonstra a enorme necessidade de ferramentas de codificação eficientes e precisas. Com sua vantagem de ser treinado especificamente para tarefas de codificação, o Codestral25.01 certamente terá um lugar de destaque no futuro da codificação.