20 de janeiro de 2025, a DeepSeek anunciou o lançamento de seu primeiro modelo de raciocínio treinado por meio de aprendizado por reforço (RL), o DeepSeek-R1, que alcançou desempenho comparável ao do OpenAI-o1-1217 em vários benchmarks de raciocínio. O DeepSeek-R1 é baseado no modelo DeepSeek-V3-Base e emprega treinamento em várias etapas e dados de inicialização a frio para melhorar sua capacidade de raciocínio.

Os pesquisadores da DeepSeek primeiro desenvolveram o DeepSeek-R1-Zero, um modelo treinado inteiramente por meio de aprendizado por reforço em larga escala, sem etapas preparatórias de ajuste fino supervisionado. O DeepSeek-R1-Zero demonstrou desempenho excepcional em benchmarks de raciocínio, como no exame AIME2024, onde sua pontuação pass@1 aumentou de 15,6% para 71,0%.No entanto, o DeepSeek-R1-Zero também apresentava alguns problemas, como baixa legibilidade e mistura de idiomas.

Para resolver esses problemas e melhorar ainda mais o desempenho do raciocínio, a equipe DeepSeek desenvolveu o DeepSeek-R1. O DeepSeek-R1 introduz treinamento em várias etapas e dados de inicialização a frio antes do aprendizado por reforço. Especificamente, os pesquisadores primeiro coletaram milhares de pares de dados de inicialização a frio para ajustar o modelo DeepSeek-V3-Base. Em seguida, eles realizaram o aprendizado por reforço orientado ao raciocínio, da mesma forma que treinaram o DeepSeek-R1-Zero. Quando o processo de aprendizado por reforço estava próximo da convergência, eles criaram novos dados de ajuste fino supervisionado por meio de amostragem de rejeição dos checkpoints de aprendizado por reforço e combinaram-nos com dados supervisionados do DeepSeek-V3 em áreas como escrita, perguntas e respostas factuais e autoconhecimento, e então treinaram novamente o modelo DeepSeek-V3-Base. Finalmente, eles usaram prompts de todos os cenários para realizar um aprendizado por reforço adicional no checkpoint ajustado.

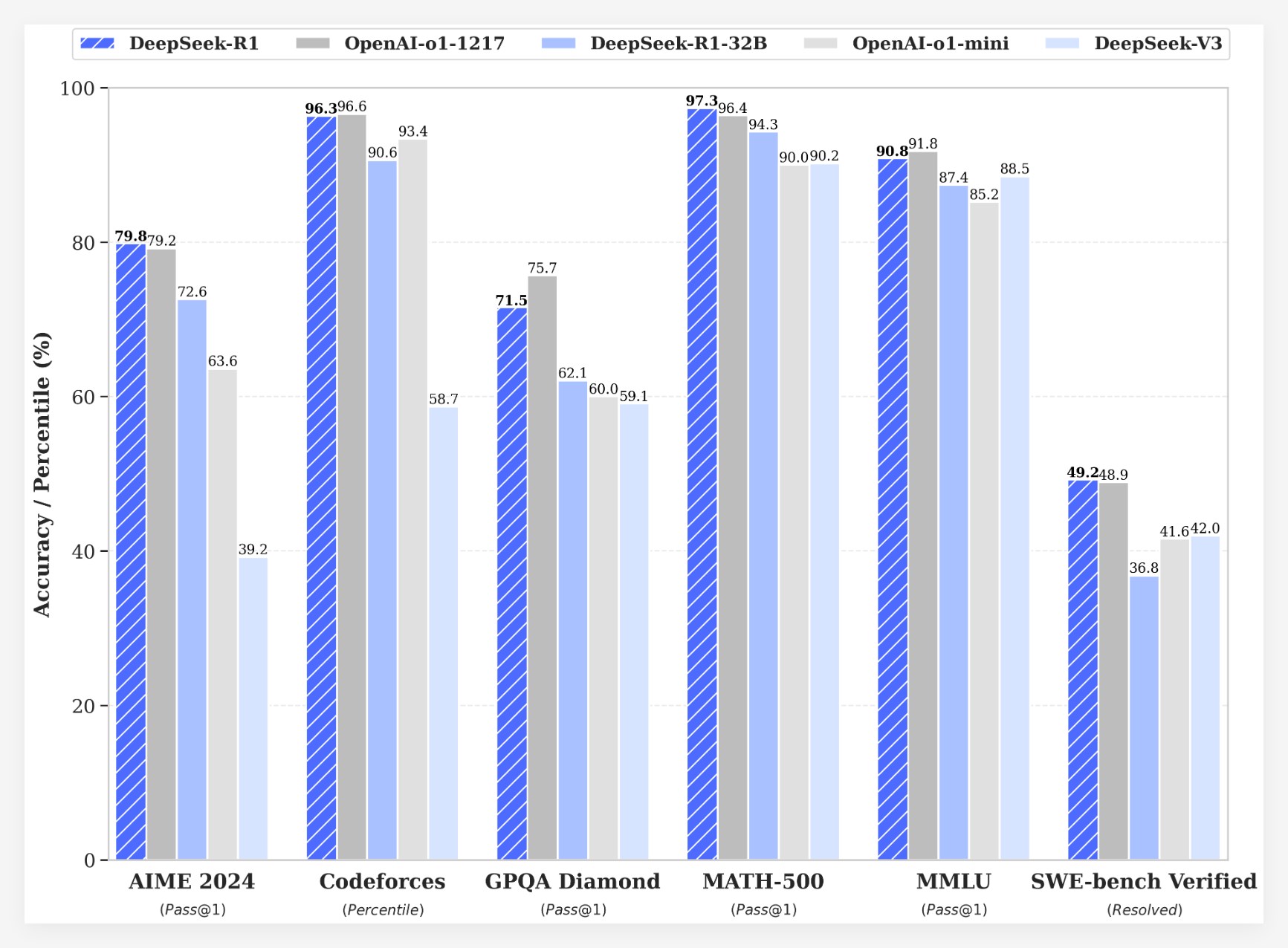

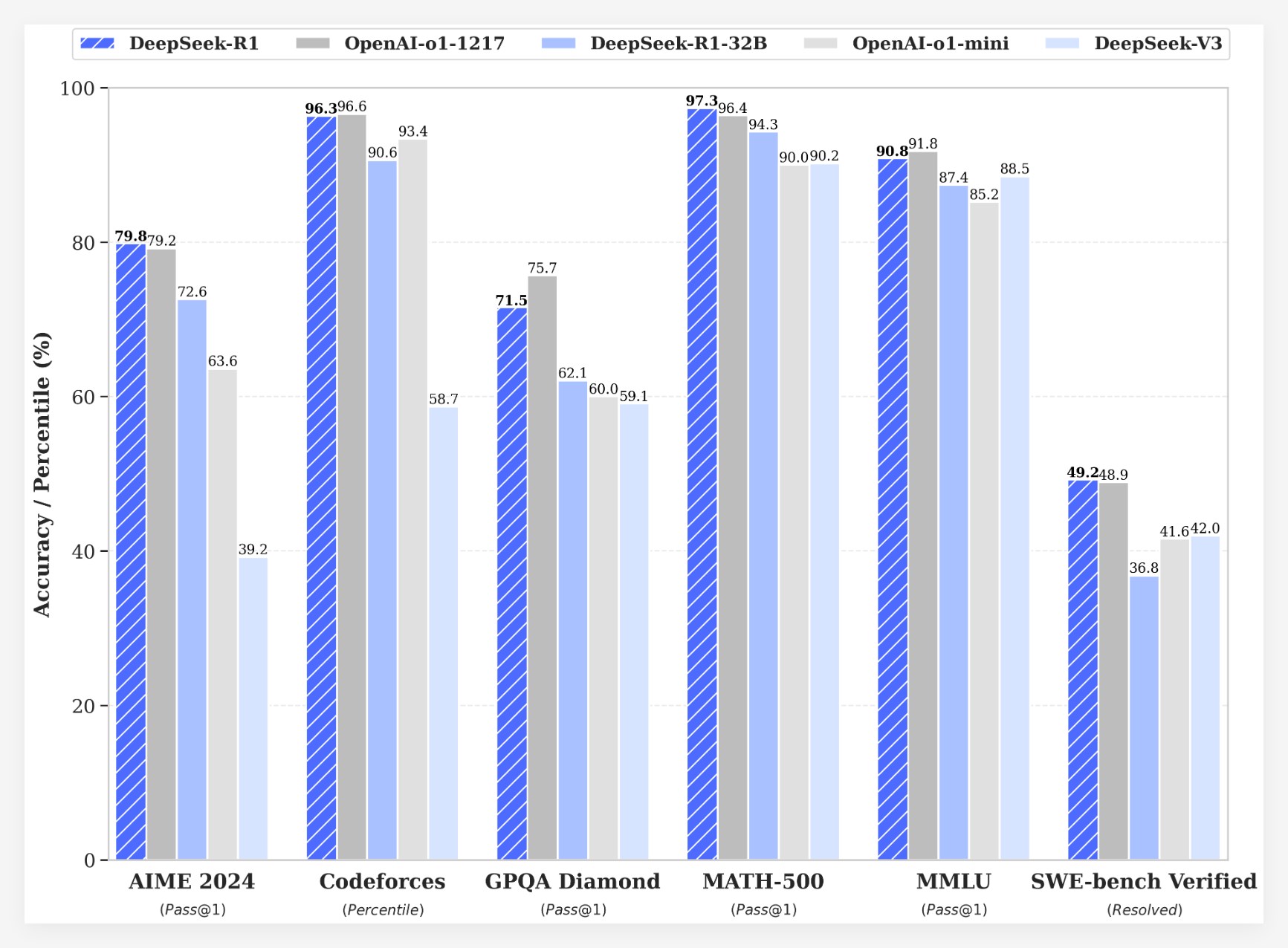

O DeepSeek-R1 obteve resultados notáveis em vários benchmarks:

• No exame AIME2024, a pontuação pass@1 do DeepSeek-R1 atingiu 79,8%, ligeiramente superior à do OpenAI-o1-1217.

• No exame MATH-500, a pontuação pass@1 do DeepSeek-R1 atingiu 97,3%, empatando com o OpenAI-o1-1217.

• Em tarefas de competição de código, o DeepSeek-R1 obteve uma classificação Elo de 2029 no Codeforces, superando 96,3% dos participantes humanos.

• Em benchmarks de conhecimento (como MMLU, MMLU-Pro e GPQA Diamond), o DeepSeek-R1 obteve pontuações de 90,8%, 84,0% e 71,5%, respectivamente, superando significativamente o DeepSeek-V3.

• Em outras tarefas (como escrita criativa, perguntas e respostas gerais, edição, resumo, etc.), o DeepSeek-R1 também se destacou.

Além disso, a DeepSeek também explorou a destilação da capacidade de raciocínio do DeepSeek-R1 em modelos menores. A pesquisa descobriu que a destilação direta do DeepSeek-R1 é mais eficaz do que aplicar aprendizado por reforço em modelos menores. Isso indica que os padrões de raciocínio descobertos por grandes modelos básicos são cruciais para melhorar a capacidade de raciocínio.A DeepSeek lançou em código aberto o DeepSeek-R1-Zero, o DeepSeek-R1 e seis modelos densos (1,5B, 7B, 8B, 14B, 32B, 70B) destilados do DeepSeek-R1 com base em Qwen e Llama. O lançamento do DeepSeek-R1 marca um avanço significativo no uso do aprendizado por reforço para melhorar a capacidade de raciocínio de grandes modelos de linguagem.

Vantagem de Custo

Em termos de custo, o DeepSeek-R1 oferece uma estratégia de preços extremamente competitiva. O preço de acesso à API é de US$ 0,14 por milhão de tokens de entrada (acerto de cache) e US$ 0,55 (falha de cache), e US$ 2,19 por milhão de tokens de saída. Essa estratégia de preços é mais atraente do que outros produtos semelhantes e foi descrita pelos usuários como um "mudador de jogo". O site oficial e a API já estão disponíveis! Acesse https://chat.deepseek.com para experimentar o DeepThink!

Feedback da Comunidade e Visão Futura

O lançamento do DeepSeek-R1 gerou discussões animadas na comunidade. Muitos usuários elogiaram a natureza de código aberto do modelo e suas vantagens de custo, considerando que ele oferece mais opções e liberdade aos desenvolvedores. No entanto, alguns usuários também questionaram o tamanho da janela de contexto do modelo, esperando que versões futuras possam otimizá-lo ainda mais.

A equipe DeepSeek afirma que continuará se dedicando a melhorar o desempenho e a experiência do usuário do modelo, e planeja lançar mais recursos no futuro, incluindo análise de dados avançados, para atender às expectativas dos usuários em relação à IAG (Inteligência Artificial Geral).