Com o avanço contínuo da tecnologia de inteligência artificial, a fusão de dados visuais e de texto tornou-se um desafio complexo. Modelos tradicionais frequentemente têm dificuldades em analisar com precisão documentos visuais estruturados, como tabelas, gráficos, infográficos e diagramas. Essa limitação afeta a extração e compreensão automáticas de conteúdo, impactando, por sua vez, aplicações como análise de dados, recuperação de informações e tomada de decisões. Para atender a essa necessidade, a IBM lançou recentemente o Granite-Vision-3.1-2B, um pequeno modelo de linguagem visual projetado especificamente para compreensão de documentos.

O Granite-Vision-3.1-2B consegue extrair conteúdo de diversos formatos visuais, incluindo tabelas, gráficos e diagramas. Treinado em um conjunto de dados cuidadosamente selecionado, com fontes públicas e sintéticas, o modelo consegue lidar com diversas tarefas relacionadas a documentos. Como uma versão aprimorada do modelo de linguagem grande Granite, ele integra modalidades de imagem e texto, melhorando a capacidade de interpretação do modelo e se tornando adequado para diversas aplicações práticas.

O modelo é composto por três componentes principais: primeiro, um codificador visual, que utiliza o SigLIP para processar e codificar dados visuais de forma eficiente; segundo, um conector visual-linguagem, um perceptron multicamadas (MLP) de duas camadas com função de ativação GELU, projetado para conectar informações visuais e de texto; e, por fim, um modelo de linguagem grande baseado no Granite-3.1-2B-Instruct, com comprimento de contexto de 128k, capaz de lidar com entradas complexas e volumosas.

Durante o treinamento, o Granite-Vision-3.1-2B utilizou como referência o LlaVA, combinando características de codificadores multicamadas e uma resolução de grade mais densa no AnyRes. Essas melhorias aprimoraram a capacidade do modelo de compreender conteúdo visual detalhado, permitindo-lhe executar tarefas de documentos visuais com maior precisão, como analisar tabelas e gráficos, realizar reconhecimento óptico de caracteres (OCR) e responder a consultas baseadas em documentos.

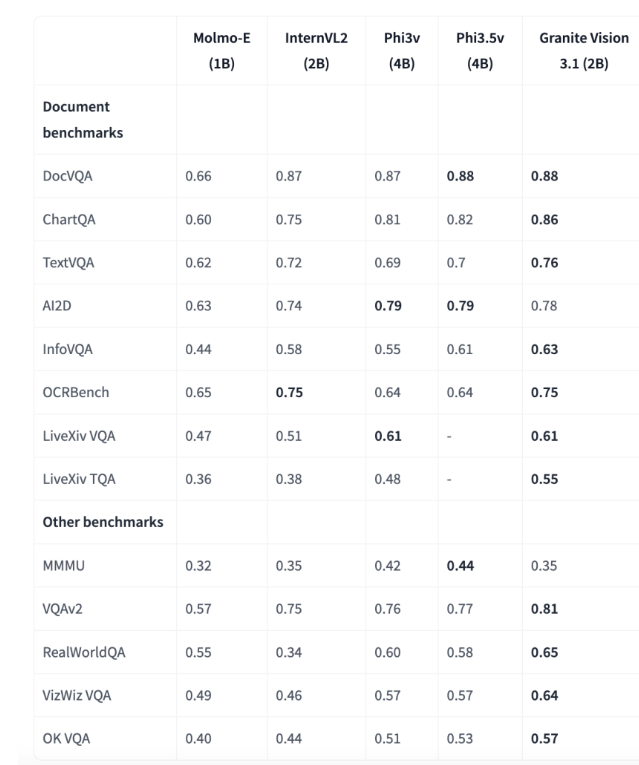

Os resultados da avaliação mostram que o Granite-Vision-3.1-2B apresentou desempenho excelente em vários testes de referência, especialmente na compreensão de documentos. No teste de referência ChartQA, o modelo alcançou uma pontuação de 0,86, superando outros modelos com parâmetros na faixa de 1B-4B. No teste de referência TextVQA, obteve uma pontuação de 0,76, demonstrando sua forte capacidade de analisar e responder a informações de texto incorporadas em imagens. Esses resultados destacam o potencial do modelo para o processamento preciso de dados visuais e de texto em aplicações empresariais.

O Granite-Vision-3.1-2B da IBM representa um avanço significativo em modelos de linguagem visual, oferecendo uma solução equilibrada para compreensão de documentos visuais. Sua arquitetura e método de treinamento permitem que ele analise e processe dados visuais e de texto complexos de forma eficiente. Devido ao seu suporte nativo a transformadores e vLLM, o modelo pode se adaptar a diversos casos de uso e pode ser implantado em ambientes de nuvem como o Colab T4, fornecendo aos pesquisadores e profissionais uma ferramenta prática para aprimorar a capacidade de processamento de documentos impulsionada por IA.

Modelo: https://huggingface.co/ibm-granite/granite-vision-3.1-2b-preview

Destaques:

🌟 O Granite-Vision-3.1-2B é um pequeno modelo de linguagem visual da IBM, projetado para compreensão de documentos, capaz de processar a extração de conteúdo de diversos formatos visuais.

📊 O modelo é composto por três partes: codificador visual, conector visual-linguagem e modelo de linguagem grande, melhorando a compreensão de entradas complexas.

🏆 Apresentou desempenho excelente em vários testes de referência, especialmente na área de compreensão de documentos, demonstrando um forte potencial para aplicações empresariais.