Na área de inteligência artificial, a equipe DeepSeek recentemente publicou seus mais recentes resultados de pesquisa, lançando um mecanismo de atenção esparsa inovador chamado NSA (Native Sparse Attention). O objetivo principal dessa tecnologia é melhorar a velocidade de treinamento e inferência de contextos longos, especialmente otimizado para hardware moderno, resultando em um aumento significativo na eficiência de treinamento e inferência.

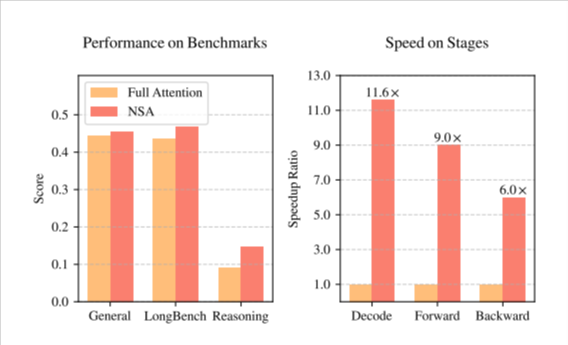

O lançamento da tecnologia NSA trouxe mudanças significativas para o treinamento de modelos de inteligência artificial. Primeiro, por meio de uma série de otimizações de design direcionadas às características do hardware de computação moderno, ele melhorou significativamente a velocidade de inferência e reduziu efetivamente o custo de pré-treinamento. Mais importante ainda, ao melhorar a velocidade e reduzir os custos, a NSA ainda mantém um alto nível de desempenho do modelo, garantindo que o desempenho do modelo em várias tarefas não seja afetado.

Em sua pesquisa, a equipe DeepSeek adotou uma estratégia esparsa hierárquica, dividindo o mecanismo de atenção em três ramos: compressão, seleção e janela deslizante. Esse design permite que o modelo capture simultaneamente o contexto global e os detalhes locais, melhorando assim a capacidade do modelo de lidar com textos longos. Além disso, as otimizações de acesso à memória e agendamento de cálculos da NSA reduziram significativamente o atraso de cálculo e o consumo de recursos do treinamento de contextos longos.

Em uma série de testes de benchmark comuns, a NSA demonstrou seu desempenho superior. Particularmente em tarefas de contexto longo e inferência baseada em instruções, o desempenho da NSA é comparável ao dos modelos de atenção completa, e em alguns casos, até superior. O lançamento dessa tecnologia marca mais um salto na tecnologia de treinamento e inferência de IA, impulsionando o futuro desenvolvimento da inteligência artificial.

Artigo da NSA (https://arxiv.org/pdf/2502.11089v1).

Destaques:

🌟 O lançamento da tecnologia NSA melhorou significativamente a velocidade de treinamento e inferência de contextos longos e reduziu o custo de pré-treinamento.

🛠️ Usando uma estratégia esparsa hierárquica, o mecanismo de atenção é dividido em compressão, seleção e janela deslizante, melhorando a capacidade do modelo de lidar com textos longos.

📈 Em vários testes de benchmark, a NSA apresentou desempenho superior, superando em alguns casos os modelos de atenção completa tradicionais.