Recentemente, uma equipe de pesquisa da Microsoft, em colaboração com pesquisadores de várias universidades, lançou um modelo de IA multimodal chamado "Magma". Este modelo foi projetado para processar e integrar vários tipos de dados, como imagens, texto e vídeo, para executar tarefas complexas em ambientes digitais e físicos. Com o avanço da tecnologia, os agentes de IA multimodal estão sendo amplamente aplicados em robótica, assistentes virtuais e automação de interfaces de usuário.

Sistemas de IA anteriores geralmente se concentravam na compreensão visual-linguística ou na manipulação robótica, tendo dificuldade em combinar essas duas habilidades em um único modelo. Muitos modelos existentes, embora apresentem bom desempenho em áreas específicas, têm capacidade de generalização limitada em diferentes cenários de aplicação. Por exemplo, os modelos Pix2Act e WebGUM se destacam na navegação da IU, enquanto o OpenVLA e o RT-2 são mais adequados para manipulação robótica, mas eles geralmente precisam ser treinados separadamente, dificultando a transposição dos limites entre ambientes digitais e físicos.

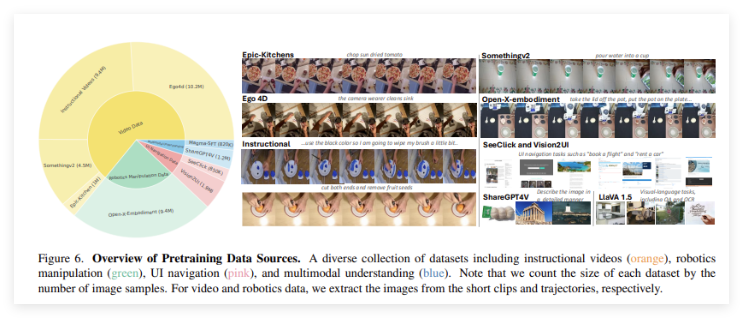

O lançamento do modelo "Magma" visa superar essas limitações. Ao introduzir um poderoso método de treinamento, ele integra a compreensão multimodal, a localização de ações e a capacidade de planejamento, com o objetivo de permitir que os agentes de IA operem perfeitamente em vários ambientes. O conjunto de dados de treinamento do Magma contém 39 milhões de amostras, incluindo imagens, vídeos e trajetórias de movimentos de robôs. Além disso, o modelo emprega duas tecnologias inovadoras: "Conjunto de Marcas" (Set-of-Mark, SoM) e "Traço de Marcas" (Trace-of-Mark, ToM). O primeiro permite que o modelo marque objetos visuais operacionais no ambiente da IU, enquanto o segundo permite que ele rastreie o movimento dos objetos ao longo do tempo, melhorando a capacidade de planejamento de ações futuras.

O "Magma" utiliza uma arquitetura avançada de aprendizado profundo e técnicas de pré-treinamento em larga escala para otimizar seu desempenho em várias áreas. O modelo usa a espinha dorsal visual ConvNeXt-XXL para processar imagens e vídeos, e o modelo de linguagem LLaMA-3-8B para processar entradas de texto. Essa arquitetura permite que o "Magma" integre de forma eficiente a visão, a linguagem e a execução de ações. Após um treinamento completo, o modelo obteve excelentes resultados em várias tarefas, demonstrando uma forte capacidade de compreensão multimodal e raciocínio espacial.

Entrada do projeto: https://microsoft.github.io/Magma/

Destaques:

🌟 O modelo Magma foi treinado com mais de 39 milhões de amostras, possuindo uma poderosa capacidade de aprendizado multimodal.

🤖 O modelo integra com sucesso visão, linguagem e ação, superando as limitações dos modelos de IA existentes.

📈 O Magma apresentou excelente desempenho em vários testes de referência, demonstrando forte capacidade de generalização e excelente capacidade de execução de decisões.