No campo da inteligência artificial, uma tecnologia revolucionária está surgindo silenciosamente. Recentemente, a Inception Labs anunciou o lançamento da série Mercury de modelos de linguagem grandes de difusão (dLLMs), uma nova geração de modelos de linguagem projetados para gerar texto de alta qualidade de forma rápida e eficiente. Em comparação com os modelos de linguagem grandes autoregressivos tradicionais, o Mercury aumentou a velocidade de geração em até 10 vezes, atingindo mais de 1000 tokens por segundo em uma placa gráfica NVIDIA H100, uma velocidade que antes só era possível com chips personalizados.

O primeiro produto da série Mercury, o Mercury Coder, já está em teste público. Este modelo é focado na geração de código e demonstra desempenho excepcional, superando muitos modelos de otimização de velocidade existentes em vários benchmarks de programação, como GPT-4o Mini e Claude3.5Haiku, além de ser quase 10 vezes mais rápido. De acordo com o feedback dos desenvolvedores, o resultado da conclusão de código do Mercury é mais popular. No teste do C o p i l o t Arena, o Mercury Coder Mini ficou entre os melhores em desempenho e foi um dos modelos mais rápidos.

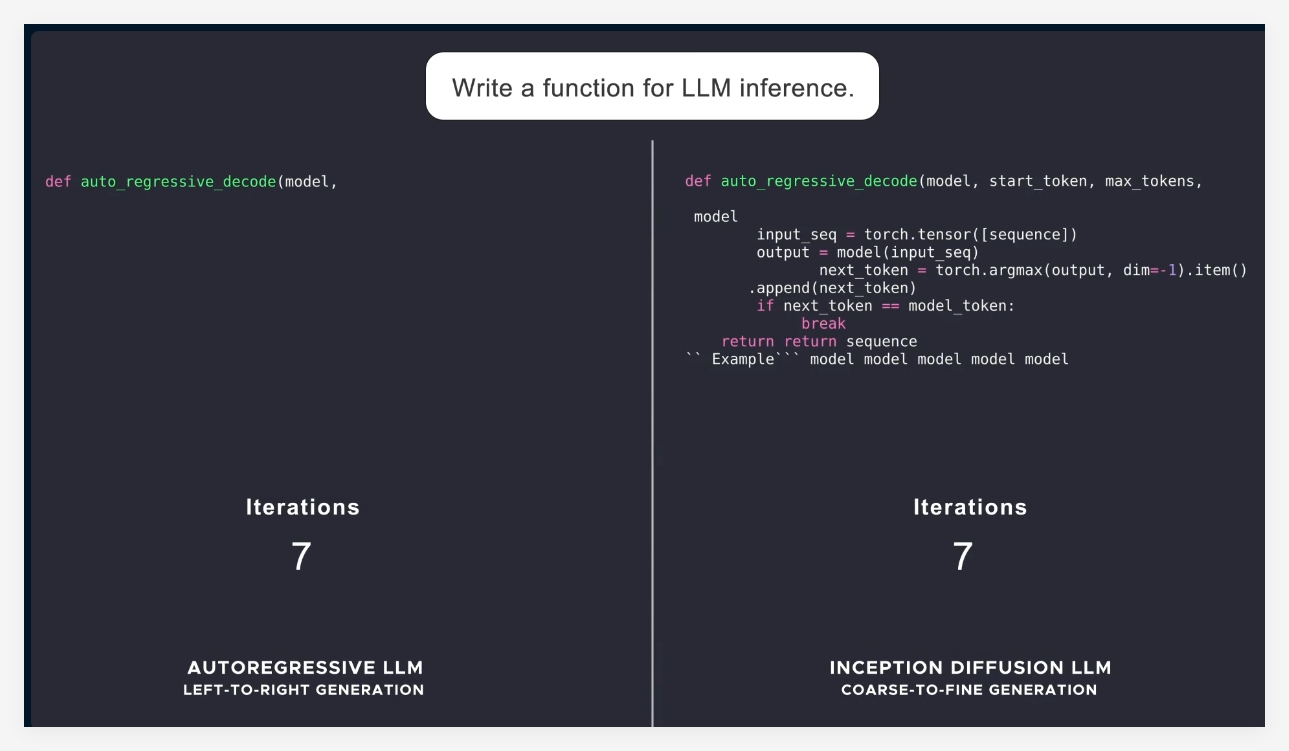

A maioria dos modelos de linguagem atuais usa um método autoregressivo, ou seja, gera tokens um a um da esquerda para a direita, o que torna o processo de geração inerentemente sequencial, resultando em alta latência e alto custo computacional. O Mercury, por outro lado, usa um método de geração "de grosso para fino", começando com ruído puro e passando por várias etapas de "desruído" para refinar gradualmente a saída. Isso permite que o modelo Mercury processe vários tokens em paralelo durante a geração, resultando em melhor raciocínio e capacidade de resposta estruturada.

Com o lançamento da série Mercury, a Inception Labs demonstrou o enorme potencial dos modelos de difusão na geração de texto e código. A empresa planeja lançar modelos de linguagem para aplicativos de bate-papo, expandindo ainda mais os cenários de aplicação dos modelos de linguagem de difusão. Esses novos modelos terão capacidades de agente inteligente mais fortes, capazes de planejamento complexo e geração de longo prazo. Além disso, sua alta eficiência permite que eles funcionem bem em dispositivos com recursos limitados, como smartphones e laptops.

Em resumo, o lançamento do Mercury marca um avanço significativo na tecnologia de inteligência artificial, não apenas melhorando significativamente a velocidade e a eficiência, mas também fornecendo soluções de maior qualidade para a indústria.

Apresentação oficial: https://www.inceptionlabs.ai/news

Experiência online: https://chat.inceptionlabs.ai/

Destaques:

🌟 Lançamento da série Mercury de modelos de linguagem grandes de difusão (dLLMs), com velocidade de geração aumentada para 1000 tokens por segundo.

🚀 O Mercury Coder, focado na geração de código, apresenta desempenho excepcional em benchmarks, superando muitos modelos existentes.

💡 A abordagem inovadora dos modelos de difusão torna a geração de texto mais eficiente e precisa, abrindo novas possibilidades para aplicativos de agentes inteligentes.