A equipe Qwen, da Alibaba, lançou recentemente o QwQ-32B, o mais novo membro da sua família de modelos de linguagem grandes (LLM) de código aberto. Este modelo de raciocínio, com 32 bilhões de parâmetros, visa melhorar o desempenho em tarefas de resolução de problemas complexos por meio do aprendizado por reforço (RL).

De acordo com a descrição, o QwQ-32B foi disponibilizado em código aberto no Hugging Face e no ModelScope sob a licença Apache2.0. Isso significa que o modelo pode ser usado para fins comerciais e de pesquisa, permitindo que empresas o integrem diretamente em seus produtos e aplicativos, incluindo serviços pagos. Usuários individuais também podem acessar o modelo por meio do Qwen Chat.

QwQ, abreviação de Qwen-with-Questions, é um modelo de raciocínio de código aberto lançado pela Alibaba em novembro de 2024, com o objetivo de competir com o o1-preview da OpenAI. O QwQ original aprimora o raciocínio lógico e a capacidade de planejamento por meio da revisão e melhoria de suas próprias respostas durante o processo de raciocínio, mostrando-se particularmente eficaz em tarefas matemáticas e de codificação.

O QwQ anterior possuía 32 bilhões de parâmetros e um comprimento de contexto de 32.000 tokens, superando o o1-preview em benchmarks matemáticos como AIME e MATH, e em tarefas de raciocínio científico como GPQA. No entanto, versões anteriores do QwQ apresentaram desempenho relativamente fraco em benchmarks de programação como o LiveCodeBench, e enfrentaram desafios como mistura de idiomas e raciocínios circulares ocasionais.

Apesar disso, a Alibaba optou por lançar o modelo sob a licença Apache2.0, diferenciando-o de alternativas proprietárias como o o1 da OpenAI, permitindo que desenvolvedores e empresas o adaptem e comercializem livremente. Com o desenvolvimento do campo da IA, as limitações dos LLMs tradicionais se tornam cada vez mais evidentes, e o aumento de desempenho proporcionado pela expansão em larga escala está diminuindo, impulsionando o interesse em modelos de raciocínio de grande escala (LRM). Os LRMs melhoram a precisão por meio do raciocínio e autorreflexão durante o processo de inferência, como o o3 da OpenAI e o DeepSeek-R1.

O mais recente QwQ-32B, por meio da integração do aprendizado por reforço e autoquestionamento estruturado, apresenta desempenho ainda melhor, visando se tornar um forte competidor na área de IA de raciocínio. Pesquisas da equipe QwQ demonstram que o aprendizado por reforço pode melhorar significativamente a capacidade do modelo de resolver problemas complexos. O QwQ-32B utiliza um método de treinamento de aprendizado por reforço em múltiplas etapas para aprimorar o raciocínio matemático, a capacidade de codificação e a resolução de problemas gerais.

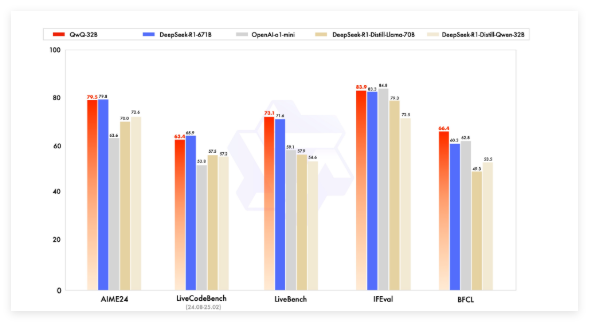

Em testes de benchmark, o QwQ-32B competiu com modelos líderes como DeepSeek-R1, o1-mini e DeepSeek-R1-Distilled-Qwen-32B, obtendo resultados competitivos mesmo com um número menor de parâmetros que alguns concorrentes. Por exemplo, o DeepSeek-R1 possui 671 bilhões de parâmetros (37 bilhões ativados), enquanto o QwQ-32B, com desempenho semelhante, apresenta menor necessidade de memória, geralmente requerendo 24 GB de VRAM em GPU, enquanto a execução completa do DeepSeek R1 necessita de mais de 1500 GB de VRAM.

O QwQ-32B utiliza uma arquitetura de modelo de linguagem causal e passou por várias otimizações, incluindo 64 camadas Transformer, RoPE, SwiGLU, RMSNorm e viés de atenção QKV. Ele também emprega atenção de consulta generalizada (GQA), possui um comprimento de contexto expandido de 131.072 tokens e passou por um treinamento em várias etapas, incluindo pré-treinamento, ajuste fino supervisionado e aprendizado por reforço.

O processo de aprendizado por reforço do QwQ-32B é dividido em duas etapas: a primeira concentra-se na capacidade matemática e de codificação, utilizando um validador de precisão e um servidor de execução de código para treinamento. A segunda etapa realiza o treinamento de recompensa por meio de um modelo de recompensa geral e um validador baseado em regras, para melhorar o seguimento de instruções, o alinhamento humano e a capacidade de raciocínio do agente, sem afetar suas habilidades matemáticas e de codificação.

O QwQ-32B também possui capacidades agentivas, podendo ajustar dinamicamente o processo de raciocínio com base no feedback do ambiente. A equipe QwQ recomenda o uso de configurações específicas de raciocínio para obter o melhor desempenho e suporta o uso do vLLM para implantação.

A equipe QwQ considera o QwQ-32B como um primeiro passo para aprimorar a capacidade de raciocínio por meio da expansão do aprendizado por reforço. Planos futuros incluem explorar ainda mais o aprendizado por reforço expandido, integrar agentes com aprendizado por reforço para raciocínio de longo prazo e continuar desenvolvendo modelos básicos otimizados para aprendizado por reforço, visando, finalmente, a inteligência artificial geral (AGI).

Modelo:https://qwenlm.github.io/blog/qwq-32b/

Destaques:

🚀 A Alibaba lança o modelo de raciocínio de grande escala de código aberto QwQ-32B, utilizando a técnica de aprendizado por reforço para melhorar a capacidade de resolução de problemas complexos.

💡 O QwQ-32B apresenta desempenho comparável a modelos com mais parâmetros em testes de benchmark matemáticos e de programação, com menor necessidade de memória, e é lançado sob a licença Apache2.0, permitindo uso comercial gratuito.

🧠 O modelo possui comprimento de contexto expandido (130.000 tokens) e capacidades agentivas, e futuras pesquisas explorarão o potencial do aprendizado por reforço para melhorar a inteligência do modelo.