Em 11 de março, a equipe do laboratório Tongyi anunciou o lançamento do código aberto do modelo R1-Omni, representando um novo avanço no desenvolvimento de modelos multimodais. Este modelo combina aprendizado por reforço com recompensas verificáveis (RLVR), focando na melhoria da capacidade de raciocínio e desempenho de generalização em tarefas de reconhecimento de emoções multimodais.

O treinamento do R1-Omni é dividido em duas fases. Na fase de inicialização a frio, a equipe utilizou um conjunto de dados combinado contendo 580 vídeos para ajuste fino, provenientes dos conjuntos de dados Explainable Multimodal Emotion Reasoning (EMER) e HumanOmni. Esta fase visa estabelecer a capacidade de raciocínio básica do modelo, garantindo que ele possua alguma capacidade de reconhecimento de emoções multimodais antes de entrar na fase RLVR, assegurando assim a suavidade, eficiência e estabilidade do treinamento subsequente.

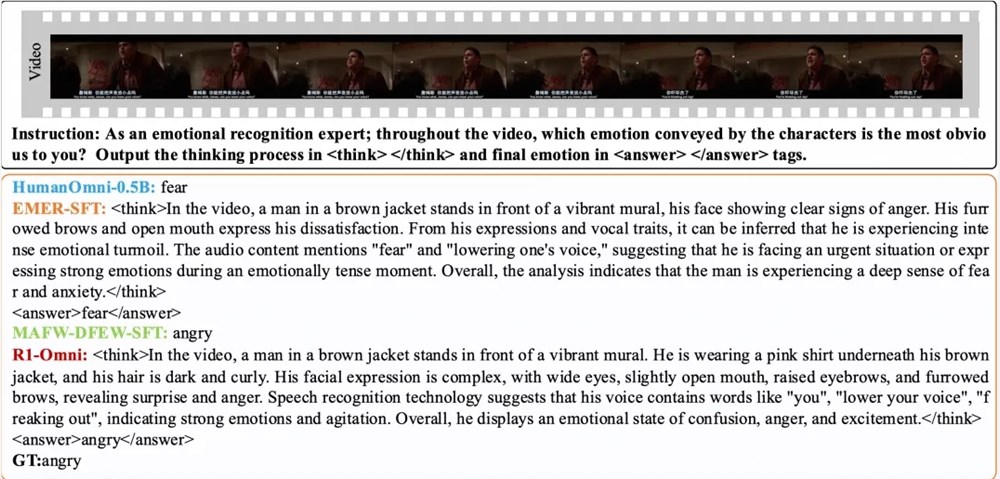

Em seguida, na fase RLVR, o modelo é otimizado ainda mais por meio do aprendizado por reforço e do mecanismo de recompensa verificável. O foco desta fase está no modelo de política e na função de recompensa. O modelo de política processa dados de entrada multimodais, consistindo em quadros de vídeo e fluxos de áudio, gerando respostas candidatas com um processo de raciocínio detalhado, mostrando como o modelo integra informações visuais e auditivas para chegar a uma previsão. A função de recompensa, inspirada no DeepSeek R1, é dividida em recompensa de precisão e recompensa de formato, formando juntas a recompensa final, incentivando o modelo a gerar previsões corretas e garantir que a saída seja estruturada e corresponda ao formato predefinido.

Os resultados experimentais mostram que o R1-Omni, em conjuntos de teste de mesma distribuição DFEW e MAFW, apresentou uma melhoria média superior a 35% em comparação com o modelo de linha de base original e uma melhoria superior a 10% na taxa de recall média não ponderada (UAR) em comparação com o modelo de ajuste fino supervisionado (SFT). No conjunto de teste de distribuição diferente RAVDESS, sua taxa de recall média ponderada (WAR) e UAR melhoraram em mais de 13%, demonstrando uma capacidade de generalização excepcional. Além disso, o R1-Omni apresenta uma vantagem significativa em termos de transparência; através do método RLVR, o papel das informações de áudio e vídeo no modelo torna-se mais claro e visível, podendo demonstrar claramente o papel de cada informação modal na tomada de decisão sobre emoções específicas, fornecendo uma referência importante para a compreensão do processo de tomada de decisão do modelo e para pesquisas futuras.

Artigo:

https://arxiv.org/abs/2503.05379

Github:

https://github.com/HumanMLLM/R1-Omni

Modelo:

https://www.modelscope.cn/models/iic/R1-Omni-0.5B