O CEO do Google, Sundar Pichai, anunciou em um evento de lançamento que o Google lançou código aberto para o seu mais recente modelo multimodal de grande escala, Gemma-3. Este modelo é conhecido por seu baixo custo e alto desempenho, atraindo muita atenção.

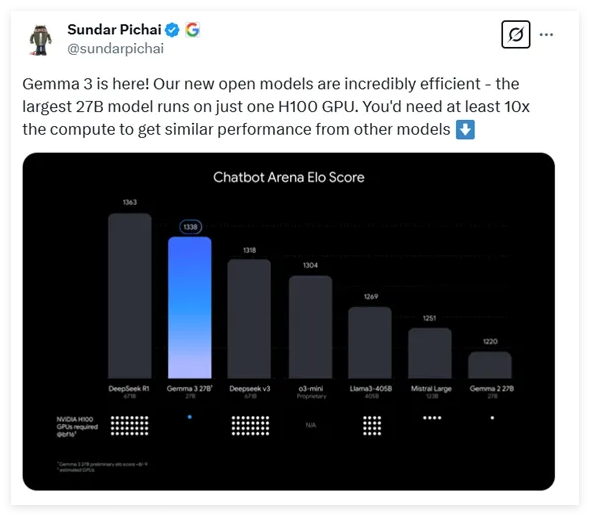

O Gemma-3 oferece quatro opções de escala de parâmetros diferentes: 1 bilhão, 4 bilhões, 12 bilhões e 27 bilhões de parâmetros. Surpreendentemente, o modelo de 27 bilhões de parâmetros, o maior, requer apenas uma única GPU H100 para inferência eficiente, enquanto modelos semelhantes geralmente exigem dez vezes mais poder computacional. Isso torna o Gemma-3 um dos modelos de alto desempenho com os menores requisitos de computação atualmente disponíveis.

De acordo com os dados de teste mais recentes, o Gemma-3 apresentou um desempenho notável em comparações de vários modelos de diálogo, ficando apenas atrás do conhecido modelo DeepSeek e superando modelos populares como o o3-mini da OpenAI e o Llama3.

A arquitetura do Gemma-3 lançado desta vez mantém o design de Transformador de decodificador universal das duas gerações anteriores, mas inclui muitas inovações e otimizações. Para resolver os problemas de memória causados por contextos longos, o Gemma-3 adotou uma arquitetura que intercala camadas de atenção automática local e global, reduzindo significativamente o uso de memória.

Em termos de capacidade de processamento de contexto, o Gemma-3 suporta um comprimento de contexto estendido para 128K tokens, fornecendo melhor suporte para o processamento de textos longos. Além disso, o Gemma-3 possui capacidade multimodal, podendo processar simultaneamente texto e imagens, e integra um codificador visual baseado em VisionTransformer, reduzindo efetivamente o custo computacional do processamento de imagens.

Durante o treinamento, o Gemma-3 utilizou um orçamento maior de tokens, especialmente no modelo de 27 bilhões de parâmetros, usando 14T de tokens, e introduziu dados multilínguas para melhorar a capacidade de processamento de linguagem do modelo, suportando 140 idiomas, dos quais 35 podem ser usados diretamente.

O Gemma-3 empregou uma técnica avançada de destilação de conhecimento, otimizando o desempenho do modelo por meio de aprendizado por reforço na fase final do treinamento, obtendo melhorias significativas, especialmente em termos de ajuda, raciocínio e capacidades multilínguas.

Após a avaliação, o Gemma-3 apresentou um desempenho excelente em tarefas multimodais, e sua capacidade de processamento de textos longos também foi impressionante, atingindo uma precisão de 66%. Além disso, o desempenho do Gemma-3 na avaliação de capacidade de diálogo também ficou entre os melhores, demonstrando sua força abrangente em várias tarefas.

Endereço: https://huggingface.co/collections/google/gemma-3-release-67c6c6f89c4f76621268bb6d

Destaques:

🔍 Gemma-3 é o mais recente modelo multimodal de grande escala de código aberto do Google, com uma faixa de parâmetros de 1 bilhão a 27 bilhões, e com uma redução de 10 vezes na demanda de poder computacional.

💡 O modelo utiliza um design de arquitetura inovador, processando efetivamente contextos longos e dados multimodais, suportando o processamento simultâneo de texto e imagem.

🌐 O Gemma-3 suporta o processamento de 140 idiomas e, após treinamento e otimização, apresenta desempenho excelente em várias tarefas, demonstrando uma forte capacidade abrangente.