Um aluno do 12º ano criou uma plataforma inovadora que permite às pessoas avaliar o desempenho de diferentes modelos de IA na criação de conteúdo em Minecraft, oferecendo uma nova perspectiva para o campo de avaliação de inteligência artificial.

Novos métodos de benchmark para lidar com as limitações da avaliação tradicional

À medida que as limitações dos métodos tradicionais de benchmark de IA se tornam cada vez mais evidentes, os desenvolvedores estão buscando maneiras mais criativas de avaliação. Para um grupo de desenvolvedores, o jogo de construção em sandbox da Microsoft, Minecraft, tornou-se a escolha ideal.

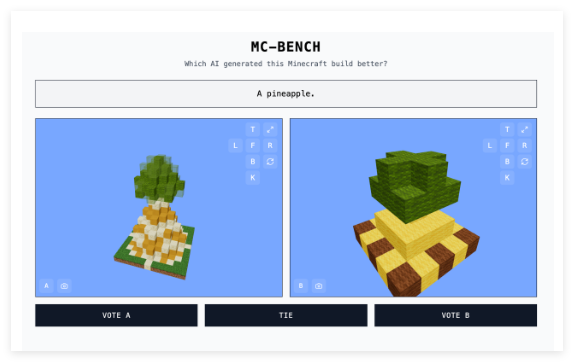

O estudante do ensino médio Adi Singh, em colaboração com sua equipe, desenvolveu o site Minecraft Benchmark (MC-Bench), que permite que modelos de IA compitam em desafios cara a cara, respondendo a vários prompts por meio de criações no Minecraft. Os usuários podem votar no modelo que apresentar melhor desempenho; a identidade do criador de IA por trás de cada obra só é revelada após a votação.

Singh afirma que o Minecraft foi escolhido como plataforma de teste devido à sua ampla popularidade – como um dos jogos eletrônicos mais vendidos de todos os tempos, mesmo aqueles que nunca jogaram podem julgar intuitivamente qual abacaxi em blocos é melhor.

"O Minecraft torna mais fácil para as pessoas verem o progresso no desenvolvimento da IA", disse Singh à TechCrunch. "As pessoas estão acostumadas com o Minecraft, acostumadas com sua aparência e atmosfera."

Projeto recebe apoio de principais empresas de IA

O MC-Bench atualmente conta com 8 voluntários. De acordo com informações do site, Anthropic, Google, OpenAI e Alibaba subsidiaram o projeto, permitindo o uso de seus produtos para executar os benchmarks, mas essas empresas não têm outras relações com o projeto.

Singh compartilhou a visão futura do projeto: "Atualmente, estamos apenas fazendo construções simples, refletindo sobre o progresso que fizemos em comparação com a era do GPT-3, mas planejamos expandir para tarefas de planejamento de longo prazo e orientadas a objetivos. O jogo pode ser apenas um meio de testar o raciocínio do agente, sendo mais seguro e mais fácil de controlar em termos de testes do que a vida real, o que, na minha opinião, é ideal."

Além do Minecraft, jogos como Pokémon Red, Street Fighter e Pictionary também são usados como benchmarks para experimentos de IA, em parte porque os próprios benchmarks de IA são extremamente desafiadores.

Avaliação intuitiva substitui indicadores complexos

Os pesquisadores geralmente testam modelos de IA em avaliações padronizadas, mas esses testes tendem a dar aos modelos de IA uma vantagem injusta. Devido à natureza de seu treinamento, os modelos são inerentemente bons em certos tipos de problemas, especialmente aqueles que envolvem memória ou raciocínio básico.

Essa contradição é demonstrada em vários casos: o GPT-4 da OpenAI consegue obter 88% na prova do LSAT, mas não consegue contar com precisão quantos "R"s existem na palavra "strawberry"; o Claude 3.7 Sonnet da Anthropic tem uma precisão de 62,3% em benchmarks padronizados de engenharia de software, mas não consegue jogar Pokémon tão bem quanto a maioria das crianças de cinco anos.

Do ponto de vista técnico, o MC-Bench é um benchmark de programação que exige que os modelos escrevam código para criar construções especificadas, como "Frosty, o boneco de neve" ou "uma cabana de praia tropical encantadora em uma praia intocada". Mas para a maioria dos usuários, avaliar a aparência do boneco de neve é mais intuitivo do que analisar profundamente o código, o que torna o projeto mais amplo e promete coletar mais dados sobre o desempenho dos modelos.

Embora o impacto dessas pontuações na utilidade da IA ainda seja discutível, Singh acredita que é um sinal forte: "O ranking atual é muito próximo da minha própria experiência ao usar esses modelos, ao contrário de muitos benchmarks de texto puro. Talvez o MC-Bench possa ajudar as empresas a entender se estão seguindo na direção certa."