Estudos recentes descobriram que os grandes modelos de linguagem (LLMs) são afetados pela ordem de apresentação das informações de premissa em tarefas de raciocínio lógico. A alteração da ordem pode levar a uma diminuição do desempenho. Pesquisadores do Google DeepMind e da Universidade de Stanford apontam que a apresentação das premissas em ordem lógica natural pode melhorar o desempenho do modelo. Para modelos como LLMs, alterar a ordem das premissas resulta em queda de desempenho, exigindo mais pesquisas para solucionar esse problema. A ordem das premissas tem um impacto significativo no desempenho de raciocínio dos grandes modelos de linguagem e continua sendo um desafio. Modelos como Gemini e GPT-4 apresentam falhas significativas, com uma queda acentuada no desempenho do LLM.

Notícias de IA Relacionadas Recomendadas

OpenAI Lança o GPT-4O-Audio-Preview: Áudio que 'Entende' Emoções!

A OpenAI lidera novamente a inovação em inteligência artificial com o lançamento do novo modelo gpt-4o-audio-preview. Este modelo demonstra capacidades surpreendentes na geração e análise de áudio, abrindo novas possibilidades para a interação humano-computador. Vamos explorar os recursos deste modelo inovador e suas potenciais aplicações. As principais funcionalidades do gpt-4o-audio-preview incluem três aspectos: primeiro, ele pode gerar respostas de voz naturais e fluidas com base em texto, fornecendo suporte para aplicativos como assistentes de voz e atendimento virtual.

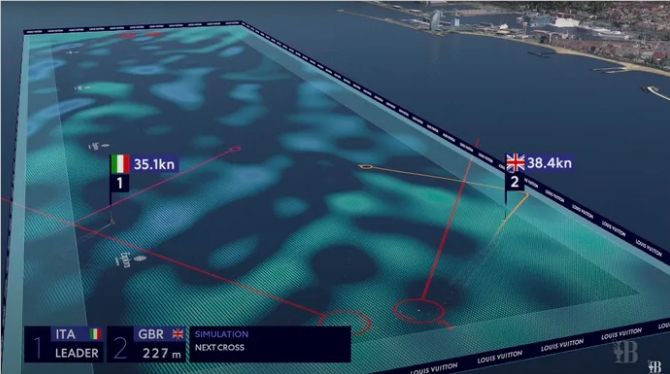

AI torna o vento 'visível' na America's Cup

Na 37ª America's Cup, o programa WindSightIQ estreou na transmissão televisiva, utilizando LiDAR, fusão de sensores e computação científica para visualizar o campo de vento como gráficos de realidade aumentada e virtual. Isso ajuda os espectadores a entenderem os fatores de vento cruciais na navegação. Embora os velejadores ainda confiem na intuição e no treinamento para planejar suas rotas, comentaristas e espectadores agora podem ver em tempo real os padrões de vento, comparar o desempenho real com a rota ideal, participando da regata em um nível sem precedentes. Esta inovação oferece uma experiência de visualização totalmente nova, tornando o vento — normalmente invisível — compreensível e envolvente.

Novo modelo OpenAI gpt-4o-2024-08-06 e gpt-4o-mini com suporte a saída estruturada

A OpenAI adicionou a funcionalidade de saída estruturada à sua API, garantindo que a saída gerada esteja totalmente em conformidade com o esquema JSON predefinido, melhorando significativamente a confiabilidade da API e a precisão dos aplicativos. Este recurso não apenas define a estrutura do JSON, mas também garante a precisão da saída. Simultaneamente, houve uma redução de preços, com o custo de entrada reduzido pela metade e o custo de saída reduzido em 1/3. A introdução da saída estruturada resolveu as limitações do esquema JSON em garantir que a saída esteja em conformidade com uma estrutura específica, melhorando significativamente o desempenho do modelo em relação à saída estruturada. Através de inovações tecnológicas, como restrições...

OpenAI lança novo modelo gpt-4o-64k-output-alpha: GPT-4o API agora suporta até 64K de saída

O principal destaque do novo modelo gpt-4o-64k-output-alpha da OpenAI é a capacidade de gerar uma saída de até 64K tokens de uma só vez, ideal para produzir conteúdo rico e detalhado, atendendo às necessidades de redação, programação e análise de dados complexos. No entanto, este recurso aumenta o preço da API, custando US$ 18 por milhão de tokens de saída, em comparação com US$ 6 por milhão de tokens de entrada. Essa medida visa equilibrar os altos custos computacionais e incentivar o uso responsável desta poderosa ferramenta. O modelo é uma ferramenta valiosa para os campos da criação e da pesquisa.