Recentemente, o Meta lançou discretamente seis resultados de pesquisa, trazendo novas aplicações e avanços tecnológicos para o campo da IA. Esses incluem modelos multimodais, modelos de geração de música a partir de texto, tecnologia de marca d'água de áudio, conjuntos de dados e vários outros projetos. Vamos dar uma olhada no que esses resultados de pesquisa são.

Meta Chameleon (modelo “camaleão”)

Primeiro, o modelo multimodal “Chameleon” lançado pode processar simultaneamente texto e imagens, suportando entrada e saída de texto mistas, fornecendo uma solução totalmente nova para o processamento de dados multimodais.

Embora a maioria dos modelos de fusão posterior atuais use aprendizado baseado em difusão, o Meta Chameleon usa tokenização para texto e imagens. Isso permite um método mais unificado e torna o modelo mais fácil de projetar, manter e expandir.

Exemplo de vídeo a seguir: geração de legendas criativas para imagens ou uso de uma mistura de prompts de texto e imagens para criar uma cena totalmente nova

Atualmente, o Meta lançará publicamente os componentes principais dos modelos Chameleon 7B e 34B sob licença de pesquisa. Os modelos atualmente lançados foram ajustados para segurança, suportam entrada em modo misto e saída de texto puro, e podem ser usados para fins de pesquisa. A empresa enfatiza que não lançará o modelo de geração de imagens Chameleon.

Acesso ao produto:https://top.aibase.com/tool/meta-chameleon

Previsão de múltiplos tokens (Multi-Token Prediction)

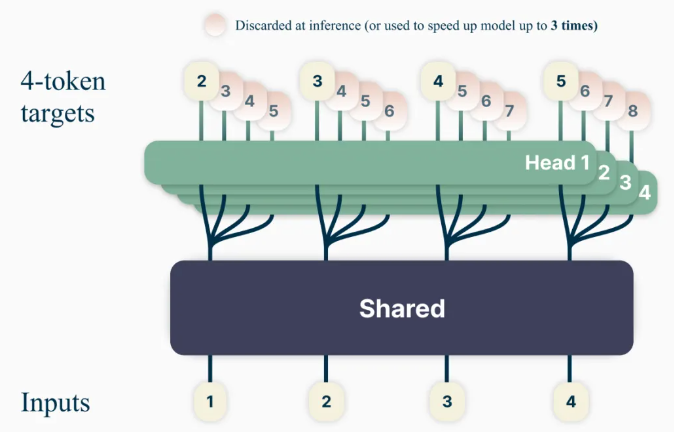

O novo método de treinamento de modelos de linguagem “Previsão de múltiplos tokens” visa melhorar a capacidade e a eficiência do treinamento do modelo, treinando o modelo para prever várias palavras de uma só vez, melhorando a precisão da previsão do modelo.

Usando este método, os modelos de linguagem podem ser treinados para prever várias palavras futuras simultaneamente, em vez do método anterior de prever uma palavra por vez. Isso melhora a capacidade e a eficiência do treinamento do modelo, além de aumentar a velocidade. No espírito de ciência aberta responsável, o modelo pré-treinado será lançado sob uma licença de uso não comercial/pesquisa para conclusão de código.

Acesso ao produto: https://top.aibase.com/tool/multi-token-prediction

Modelo de geração de música a partir de texto “JASCO”

Embora os modelos existentes de texto para música (como MusicGen) dependam principalmente da entrada de texto para gerar música, o novo modelo do Meta, “JASCO - Meta Joint Audio and Symbolic Conditioning for Time-Controllable Text-to-Music Generation”, pode aceitar várias entradas condicionais, como acordes ou batidas específicas, para melhorar o controle sobre a saída de música gerada. Especificamente, um layer de gargalo de informação pode ser combinado com um blur temporal para extrair informações relevantes para controles específicos. Isso permite a combinação simultânea de condições simbólicas e baseadas em áudio no mesmo modelo de geração de texto para música.

O JASCO apresenta uma qualidade de geração comparável à linha de base de avaliação, ao mesmo tempo em que permite um controle melhor e mais flexível da música gerada. O artigo de pesquisa e exemplos serão publicados, e o código de inferência será lançado mais tarde este mês sob a licença MIT como parte do repositório AudioCraft, e o modelo pré-treinado será lançado sob a licença CC-BY-NC.

Acesso ao código: https://top.aibase.com/tool/audiocraft

Tecnologia de marca d'água de áudio “AudioSeal”

Esta é a primeira tecnologia de marca d'água de áudio projetada especificamente para detecção local de fala gerada por IA, capaz de localizar precisamente segmentos gerados por IA em longos clipes de áudio. O AudioSeal melhora as marcas d'água de áudio tradicionais focando na detecção de conteúdo gerado por IA, em vez de esteganografia.

Ao contrário dos métodos tradicionais que dependem de algoritmos de decodificação complexos, o método de detecção local do AudioSeal permite uma detecção mais rápida e eficiente. Este design aumenta a velocidade de detecção em 485 vezes em comparação com métodos anteriores, tornando-o ideal para aplicações em larga escala e em tempo real. Nosso método alcança o desempenho de ponta em robustez e imperceptibilidade da marca d'água de áudio.

O AudioSeal é lançado sob licença comercial.

Acesso ao produto: https://top.aibase.com/tool/audioseal

Conjunto de dados PRISM

Simultaneamente, o Meta também lançou o conjunto de dados PRISM em colaboração com parceiros externos, contendo dados de conversação e preferências de 1.500 participantes globais, usados para melhorar os modelos de linguagem de grande porte, melhorando a diversidade de conversação, a diversidade de preferências e os benefícios sociais do modelo.

Este conjunto de dados mapeia as preferências e o feedback granular de cada pessoa para 8.011 conversas em tempo real com 21 LLMs diferentes.

Acesso ao conjunto de dados: https://huggingface.co/datasets/HannahRoseKirk/prism-alignment

Indicador “DIG In”

Usado para avaliar as diferenças geográficas existentes em modelos de geração de imagens a partir de texto, fornecendo mais dados de referência para a melhoria do modelo. Para entender como as percepções das pessoas em diferentes regiões sobre a representação geográfica diferem, o Meta conduziu um estudo de anotação em larga escala. Coletamos mais de 65.000 anotações e mais de 20 respostas de pesquisa para cada exemplo, cobrindo atratividade, similaridade, consistência e sugestões compartilhadas para melhorar as avaliações automáticas e manuais de modelos de texto para imagem.

Acesso ao código: https://top.aibase.com/tool/dig-in

O lançamento desses projetos traz novos avanços tecnológicos e perspectivas de aplicação para o campo da IA, sendo de grande importância para impulsionar o desenvolvimento e a aplicação da tecnologia de IA.