Recentemente, uma equipe da Kunlun Wanwei, liderada por Yan Shuicheng, na China, em colaboração com pesquisadores da Universidade Tecnológica de Nanyang, em Singapura, lançou um projeto chamado Q*, com o objetivo de melhorar a capacidade de raciocínio de modelos de linguagem menores. Este projeto difere da abordagem da OpenAI, permitindo que modelos menores alcancem a capacidade de raciocínio de modelos com parâmetros dezenas ou até centenas de vezes maiores.

Os resultados experimentais do algoritmo Q* mostraram-se notáveis: no conjunto de dados GSM8K, o Q* levou o Llama-2-7b a atingir uma precisão de 80,8%, superando o ChatGPT.

No conjunto de dados MATH, o Q* levou o DeepSeek-Math-7b a atingir uma precisão de 55,4%, superando o Gemini Ultra.

No conjunto de dados MBPP, o Q* levou o CodeQwen1.5-7b-Chat a atingir uma precisão de 77,0%, reduzindo a diferença em relação ao nível de programação do GPT-4. Esses resultados demonstram o potencial do algoritmo Q* em melhorar a capacidade de raciocínio de modelos menores.

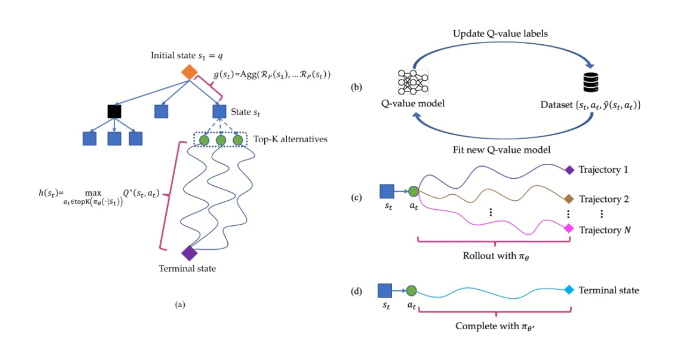

O algoritmo Q* funciona decompondo a trajetória de raciocínio de um modelo de linguagem grande em vários estados, planejando cada estado de forma abrangente e utilizando o algoritmo de busca A* para realizar a busca prioritária de tarefas de raciocínio complexas. Simultaneamente, eles treinaram um modelo de valor Q proxy por meio de aprendizado supervisionado para obter o valor Q ótimo para pares estado-ação, melhorando assim o desempenho do modelo.

Destaques:

🔍 O projeto Q* não foi lançado pela OpenAI; através do algoritmo da equipe de pesquisa, a capacidade de raciocínio de modelos menores foi significativamente aprimorada.

🔍 O projeto obteve resultados experimentais notáveis em vários conjuntos de dados, demonstrando o potencial e a eficácia do algoritmo Q*.

🔍 Link do artigo: https://arxiv.org/abs/2406.14283