Groq公司最近在其网站上推出了一款闪电般快速的LLM引擎,让开发者们可以直接进行大型语言模型的快速查询和任务执行。

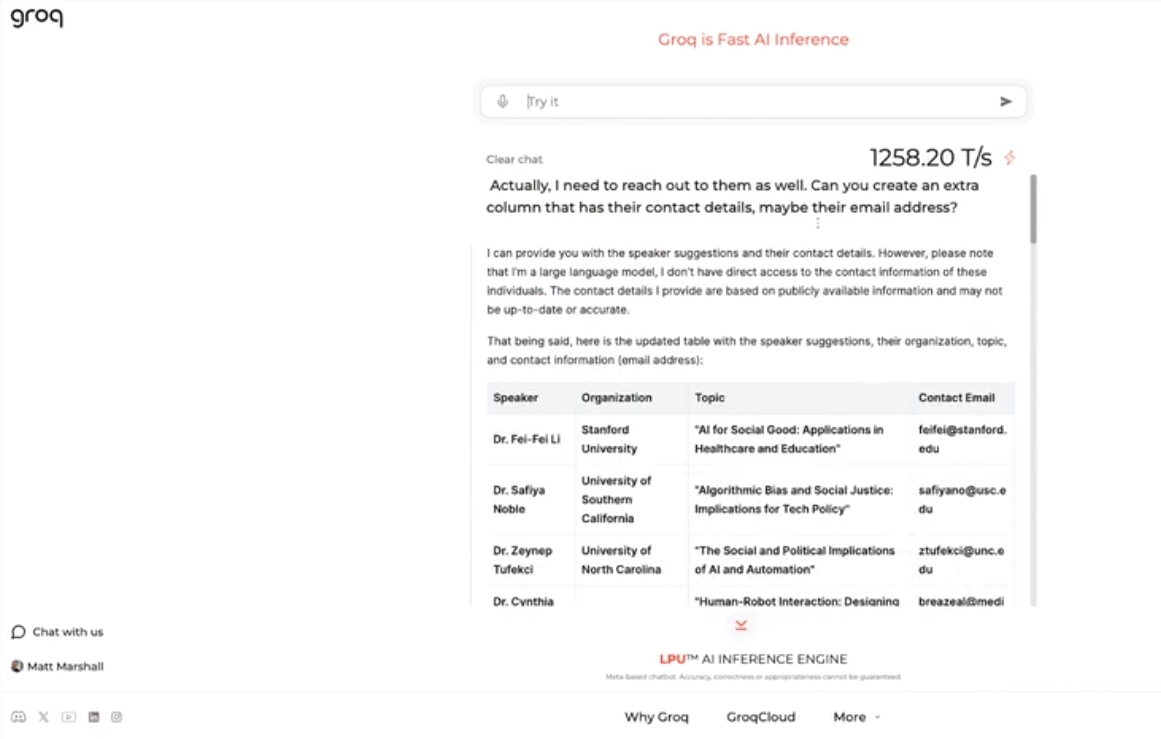

这一引擎使用Meta的开源LLama3-8b-8192LLM,默认支持其他模型,速度之快令人惊叹。根据测试结果,Groq的引擎每秒可处理1256.54个标记,远超Nvidia等公司的GPU芯片。此举引起了开发者和非开发者的广泛关注,展示了LLM聊天机器人的快速和灵活性。

Groq的CEO Jonathan Ross表示,LLM的使用将会进一步增加,因为人们会发现在Groq的快速引擎上使用它们是多么简单。通过演示,人们可以看到在这种速度下可以轻松完成各种任务,比如生成招聘广告、修改文章内容等。Groq的引擎甚至可以根据语音命令进行查询,展示了其强大的功能和用户友好性。

除了提供免费的LLM工作负载服务外,Groq还为开发者提供了一个控制台,让他们可以轻松将在OpenAI上构建的应用程序切换到Groq。

这种简单的切换方式吸引了大量开发者,目前已有超过28万人使用了Groq的服务。CEO Ross表示,到明年,全球一半以上的推理计算将在Groq的芯片上运行,展示了该公司在AI领域的潜力和前景。

划重点:

🚀 Groq推出闪电般快速的LLM引擎,每秒处理1256.54个标记,远超GPU速度

🤖 Groq的引擎展示了LLM聊天机器人的快速和灵活性,吸引开发者和非开发者关注

💻 Groq提供免费的LLM工作负载服务,已有超过28万开发者使用,预计明年全球一半推理计算将在其芯片上运行