最近,多个机构学者发现了一种新技术——物理神经网络(PNNs)。这可不是我们熟知的,那些在电脑里运行的数字算法,而是一种全新的,基于物理系统的智能计算方式。

PNNs,顾名思义,就是利用物理系统的特性来执行计算的神经网络。虽然目前它还属于研究领域的小众领域,但它们可能是现代AI中被严重低估的重要机会之一。

PNNs的潜力:大模型、低能耗、边缘计算

想象一下,如果我们能够训练比现在大1000倍的AI模型,而且还能实现在边缘设备上进行本地、私密的推理,比如在智能手机或传感器上,那会怎样?这听起来像是科幻小说里的情节,但研究表明,这并非不可能。

要实现PNNs的大规模训练,研究者们正在探索包括基于反向传播和无反向传播的方法。这些方法各有利弊,目前还没有一种方法能够像深度学习中广泛使用的反向传播算法那样,实现同等规模和性能。但情况正在迅速改变,多样化的训练技术生态系统为PNNs的利用提供了线索。

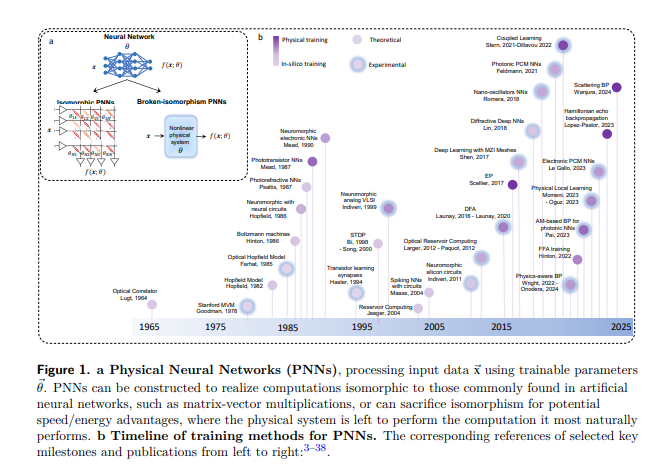

PNNs的实现涉及到多个领域,包括光学、电子学和类脑计算。它们可以采用与数字神经网络结构相似的方式来执行矩阵-向量乘法等计算,也可以为了潜在的速度/能量优势而牺牲这种结构相似性,让物理系统执行它最自然的计算。

PNNs的未来:超越数字硬件的性能

PNNs的未来应用可能会非常广泛,从大型生成模型到智能传感器中的分类任务。它们将需要被训练,但根据不同的应用,训练的约束可能会有所不同。理想的训练方法应该是模型无关的、快速且能量效率高,并且对硬件的变异、漂移和噪声具有鲁棒性。

尽管PNNs的发展充满了潜力,但它也面临着不少挑战。如何确保PNNs在训练和推理阶段的稳定性?如何将这些物理系统与现有的数字硬件和软件基础设施集成?这些都是需要解决的问题。

论文地址:https://arxiv.org/pdf/2406.03372