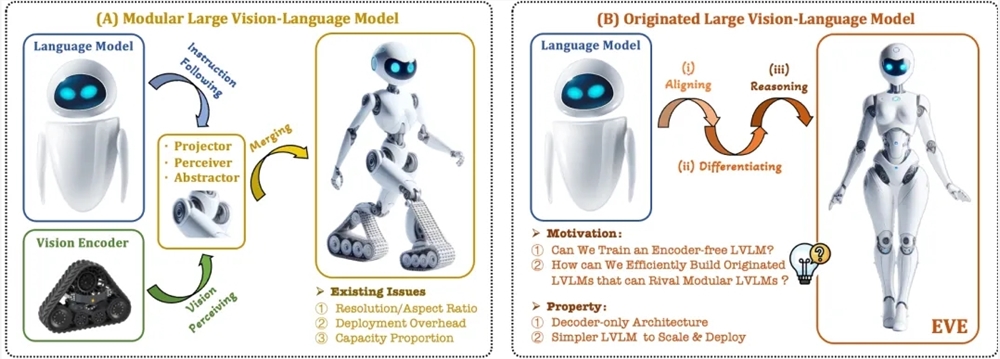

近期,多模态大模型的研究和应用取得了显著进展。国外公司如OpenAI、Google、Microsoft等推出了一系列先进的模型,国内也有智谱AI、阶跃星辰等机构在该领域取得了突破。这些模型通常依赖视觉编码器来提取视觉特征并与大语言模型结合,但存在训练分离导致的视觉归纳偏置问题,限制了多模态大模型的部署效率和性能。

为解决这些问题,智源研究院联合大连理工大学、北京大学等高校推出了新一代无编码器的视觉语言模型EVE。EVE通过精细化训练策略和额外的视觉监督,将视觉-语言表征、对齐和推理整合到统一的纯解码器架构中。使用公开数据,EVE在多个视觉-语言基准测试中表现优异,接近甚至优于基于编码器的主流多模态方法。

EVE的主要特点包括:

原生视觉语言模型:去除视觉编码器,处理任意图像长宽比,显著优于同类型Fuyu-8B模型。

数据和训练代价少:预训练使用OpenImages、SAM和LAION等公开数据,训练时间较短。

透明和高效的探索:为纯解码器的原生多模态架构提供了高效、透明的发展路径。

模型结构:

Patch Embedding Layer:通过单层卷积层和平均池化层获取图像2D特征图,增强局部特征和全局信息。

Patch Aligning Layer:整合多层网络视觉特征,实现与视觉编码器输出的细粒度对齐。

训练策略:

大语言模型引导的预训练阶段:建立视觉和语言之间的初步联系。

生成式预训练阶段:提高模型对视觉-语言内容的理解能力。

监督式的微调阶段:规范模型遵循语言指令和学习对话模式的能力。

定量分析:EVE在多个视觉语言基准测试中表现优异,与多种主流的基于编码器的视觉语言模型相当。尽管在准确响应特定指令方面存在挑战,但通过高效的训练策略,EVE实现了与带编码器基础的视觉语言模型相当的性能。

EVE展示了无编码器原生视觉语言模型的潜力,未来可能通过进一步的性能提升、无编码器架构的优化和原生多模态的构建,继续推动多模态模型的发展。

论文地址: https://arxiv.org/abs/2406.11832

项目代码: https://github.com/baaivision/EVE

模型地址: https://huggingface.co/BAAI/EVE-7B-HD-v1.0