在人工智能领域,大型语言模型(LLMs)如GPT-3和Llama-2已经取得了显著进展,能够准确理解和生成人类语言。然而,这些模型庞大的参数量使得它们在训练和部署过程中需要大量的计算资源,这对资源有限的环境构成了挑战。

论文入口:https://arxiv.org/html/2406.10260v1

传统上,为了在不同的计算资源限制下实现效率和准确性的平衡,研究人员需要训练多个不同版本的模型。例如,Llama-2模型系列包括70亿、13亿和7亿参数的不同变体。然而,这种方法需要大量的数据和计算资源,效率并不高。

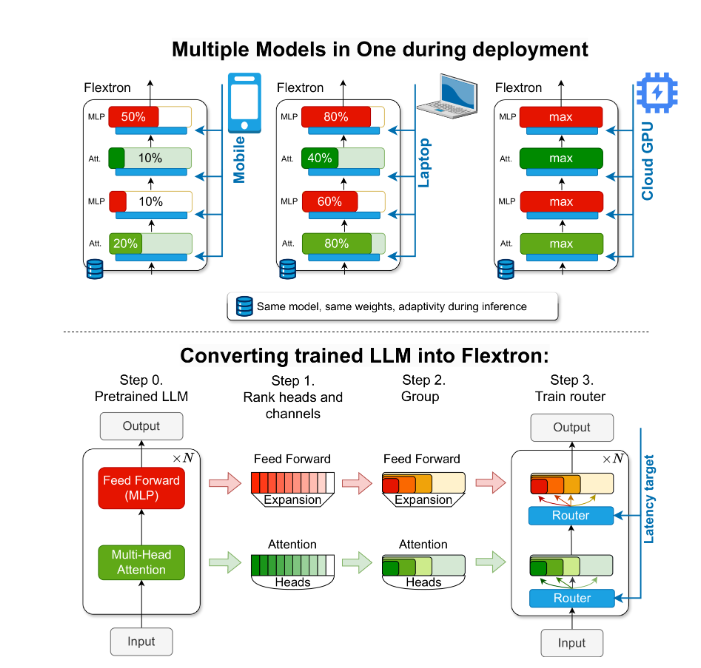

为了解决这一问题,NVIDIA和德克萨斯大学奥斯汀分校的研究人员推出了Flextron框架。Flextron是一种新颖的灵活模型架构和后训练优化框架,支持在不需要额外微调的情况下适应性地部署模型,从而解决了传统方法的低效问题。

Flextron通过样本高效训练方法和先进的路由算法将预训练的LLM转化为弹性模型。这种结构采用嵌套弹性设计,允许在推理过程中动态调整以满足特定的延迟和准确性目标。这种适应性使得在各种部署场景中使用单一预训练模型成为可能,显著减少了对多个模型变体的需求。

Flextron的性能评估显示,与多个端到端训练模型和其他最先进的弹性网络相比,它在效率和准确性上表现出色。例如,Flextron在ARC-easy、LAMBADA、PIQA、WinoGrande、MMLU和HellaSwag等多个基准测试中均表现出色,仅使用了原始预训练中7.63%的训练标记,从而节省了大量的计算资源和时间。

Flextron框架还包括弹性多层感知器(MLP)和弹性多头注意力(MHA)层,进一步增强了其适应性。弹性MHA层通过根据输入数据选择注意力头的子集,有效利用可用内存和处理能力,特别适合计算资源有限的场景。

划重点:

🌐 Flextron框架支持灵活AI模型部署,无需额外微调。

🚀 通过样本高效训练和先进路由算法,提高了模型效率和准确性。

💡 弹性多头注意力层优化了资源利用,特别适合计算资源有限的环境。

这篇报道希望能为高中生读者通俗易懂地介绍Flextron框架的重要性和创新性。