继昨天Meta宣布发布最强开源模型Llama3.1之后,Mistral AI在今天凌晨 隆重推出了其旗舰模型 Mistral Large2,这一新产品有 1230亿个参数,拥有超大的128k 上下文窗口,与从这方面来看可以媲美Llama3.1。

Mistral Large2模型详情

Mistral Large2具有128k 上下文窗口,支持法语、德语、西班牙语、意大利语、葡萄牙语、阿拉伯语、印地语、俄语、中文、日语和韩语等数十种语言,以及 Python、Java、C、C++、JavaScript 和 Bash 等80多种编码语言。

Mistral Large2专为单节点推理而设计,主要针对长上下文应用 - 其1230亿个参数的大小使其能够在单个节点上以大吞吐量运行。Mistral Large2根据 Mistral 研究许可证发布,旨在用于研究和非商业用途;若有商业需求,用户需要联系以获取商业许可证。

整体表现:

在性能方面,Mistral Large2在评估指标上建立了新的标杆,尤其是在 MMLU 基准测试中实现了84.0% 的准确率,展现出强大的性能与服务成本的平衡。

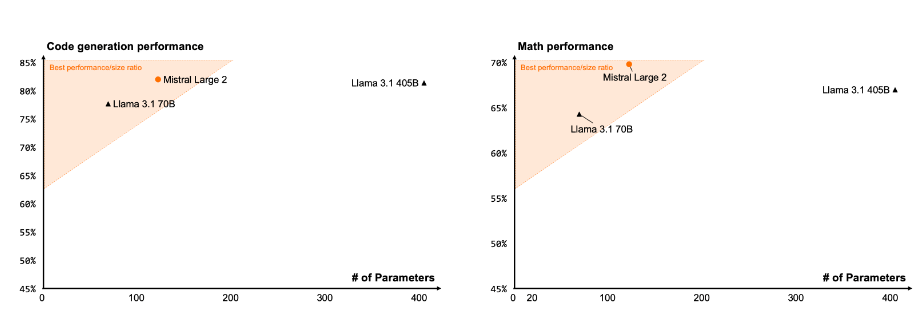

代码与推理

通过对 Codestral22B 和 Codestral Mamba 的训练经验,Mistral Large2在代码处理上表现优异,甚至与 GPT-4o、Claude3Opus 和 Llama3405B 等顶尖模型相媲美。

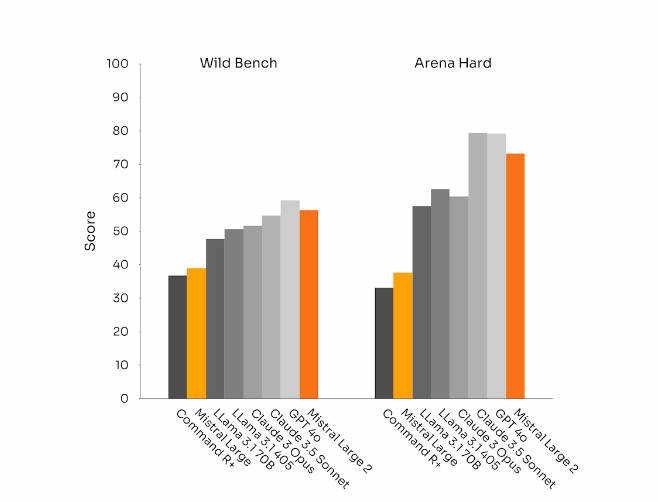

指令遵循与对齐

Mistral Large2在指令遵循和对话能力上也取得了显著进展,尤其是在处理复杂、多轮的对话时更加灵活。在某些基准测试中,生成较长的响应往往会提高分数。然而,在许多商业应用中,简洁性至关重要——较短的模型生成有助于加快交互速度,并且推理更具成本效益。

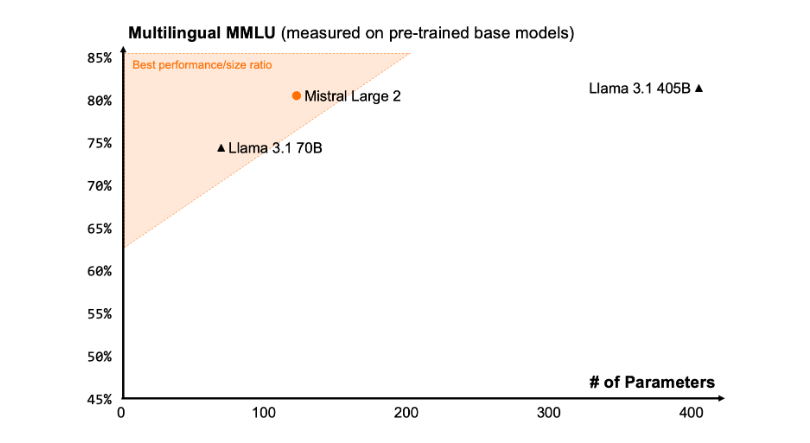

语言多样性

新的 Mistral Large2是在大量多语言数据上进行训练的,特别是在英语、法语、德语、西班牙语、意大利语、葡萄牙语、荷兰语、俄语、中文、日语、韩语、阿拉伯语和印地语方面表现出色。以下是 Mistral Large2在多语言 MMLU 基准上的性能结果,与之前的 Mistral Large、Llama3.1模型以及 Cohere 的 Command R+ 进行了比较。

工具使用和函数调用

Mistral Large2配备了增强的函数调用和检索技能,并经过训练,可以熟练地执行并行和顺序函数调用,使其能够作为复杂业务应用程序的动力引擎。

使用方法:

目前,用户可以在la Plateforme(https://console.mistral.ai/)使用 Mistral Large2,名称为mistral-large-2407,并在 le Chat 上进行测试。它可在版本24.07(我们应用于所有模型的 YY.MM 版本控制系统)和 API 名称下使用mistral-large-2407。instruct 模型的权重可用,并且也托管在HuggingFace上(https://huggingface.co/mistralai/Mistral-Large-Instruct-2407)。

La Plateforme 上的产品,包括两个通用模型 Mistral Nemo 和 Mistral Large,以及两个专业模型 Codestral 和 Embed。随着我们逐步弃用 La Plateforme 上的旧模型,所有 Apache 模型(Mistral7B、Mixtral8x7B 和8x22B、Codestral Mamba、Mathstral)仍可使用 SDK mistral-inference 和 mistral-finetune 进行部署和微调。

从今天开始,产品将扩展 la Plateforme 上的微调功能:这些功能现在可用于 Mistral Large、Mistral Nemo 和 Codestral。

Mistral AI 还与多家领先的云服务提供商合作,让 Mistral Large2在全球范围内可用,尤其是在 Google Cloud Platform 的 Vertex AI 中也能找到它的身影。

** 划重点:**

🌟 Mistral Large2具备128k 上下文窗口,支持多达十种语言及80多种编程语言。

📈 在 MMLU 基准测试中实现84.0% 的准确率,性能与成本表现卓越。

💻 用户可通过 La Plateforme 访问新模型,并在云服务平台上广泛应用。