根据云安全公司Checkmarx发布的一项全球研究显示,尽管15%的公司明确禁止使用AI编程工具,但几乎所有的开发团队(99%)仍在使用这些工具。这种现象反映了在实际开发过程中,控制生成式AI使用的难度。

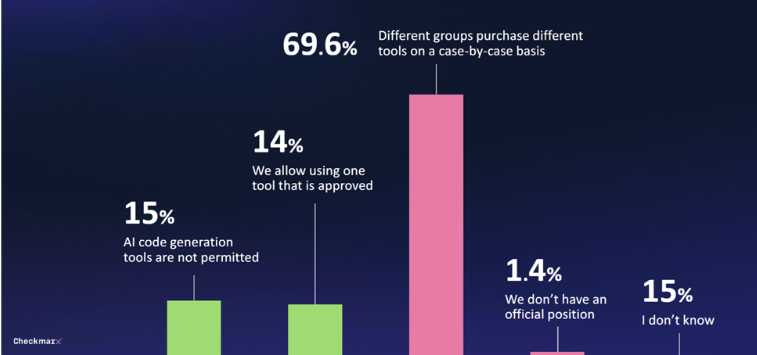

研究发现,仅有29%的公司对生成式AI工具建立了任何形式的治理体系。70%的公司没有制定中央策略,各个部门的采购决策往往是临时性的,缺乏统一的管理。

随着越来越多的开发者使用AI编程工具,安全问题也日益引起关注。80%的受访者担心开发者使用AI可能带来的潜在威胁,其中60%特别担忧AI可能出现的“幻觉”问题。

尽管存在这些担忧,许多人仍对AI的潜力抱有兴趣。47%的受访者愿意让AI在无人监督的情况下进行代码更改,而只有6%的人表示完全不信任AI在软件环境中的安全措施。

Checkmarx的首席产品官Kobi Tzruya指出:“全球CISO的回应揭示了开发者正在使用AI进行应用开发,尽管这些AI工具无法可靠地创建安全代码,这意味着安全团队要应对大量新产生的、可能存在漏洞的代码。”

微软的工作趋势指数报告也显示,许多员工在没有提供AI工具的情况下,会使用自己的AI工具,往往不会公开讨论这一点,这阻碍了生成式AI在业务流程中的系统性实施。

划重点:

1. 🚫 **15%的公司禁止AI编程工具,但99%的开发团队仍在使用**

2. 📊 **只有29%的公司对生成式AI工具建立了治理体系**

3. 🔐 **47%的受访者愿意让AI进行无人监督的代码更改**