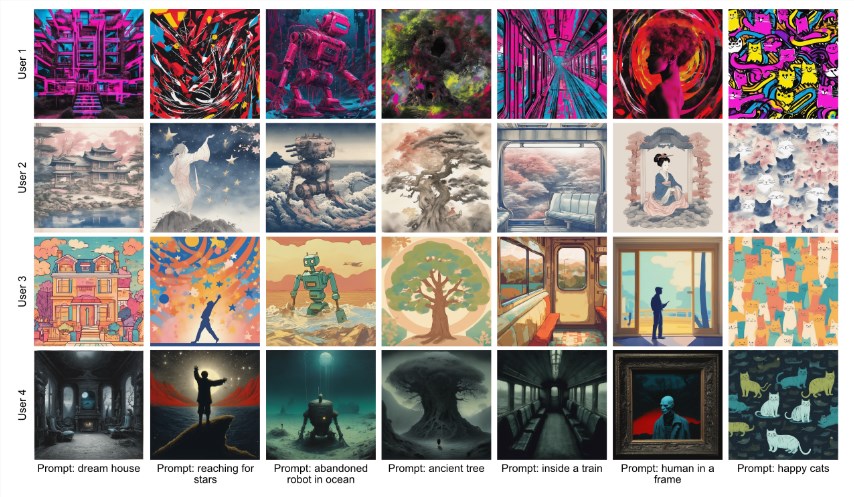

最近,瑞士洛桑联邦理工学院的研究团队推出了一种新方法,名为 ViPer(Visual Personalization of Generative Models via Individual Preference Learning),旨在根据用户的视觉偏好个性化生成模型的输出。

这一创新在即将到来的2024年 ECCV 会议上进行了展示,团队希望能够让每个用户在相同的提示下,获得更符合自己喜好的生成结果。

产品入口:https://top.aibase.com/tool/viper

ViPer 的工作原理非常简单。用户只需一次性提供自己对一组图片的评论,这些评论将用来提取他们的视觉偏好。这样,生成模型就能在没有复杂提示的情况下进行个性化调整,利用这些属性来生成符合用户喜好的图片。

简单的说,这有点类似Midjourney 此前推出的个性化偏好功能(--personalize),要使用Midjourney个性化模型,用户需要在过去对配对排名中的图片进行过至少200次的点赞或评分。这些评分和点赞行为帮助Midjourney学习用户的偏好,使个性化模型能够更准确地反映用户的品味。

该项目的模型已经在 Huggingface 平台上发布,用户可以轻松下载并使用。ViPer 中的 VPE 模型经过精细调整,可以从用户提供的一系列图像和评论中提取个体偏好。

同时,项目还提供了一种代理指标模型,能够根据用户喜欢和不喜欢的图像预测某个查询图像的偏好分数。这意味着,用户可以更好地了解自己对新图像的潜在喜好。

另外,ViPer 还提供了代理评分机制,用户可以通过提供喜欢和不喜欢的图像,计算出查询图像的评分。这一评分从0到1不等,分数越高,表明用户越喜欢这幅图像。团队建议每个用户提供大约8张喜欢的和8张不喜欢的图像,以确保结果的准确性。

划重点:

🌟 ViPer 通过用户的一次性评论提取个体视觉偏好,从而个性化生成模型的输出。

🖼️ 该项目的模型已在 Huggingface 发布,用户可以方便地下载和使用。

📊 ViPer 提供代理评分机制,帮助用户预测对新图像的喜好程度。