以色列人工智能初创公司 aiOla 近日搞了个大动作,宣布推出一款新的开源语音识别模型 Whisper-Medusa。

这模型可不简单,它比 OpenAI 大名鼎鼎的 Whisper 速度快了足足50%!它是在 Whisper 的基础上搭建的,但采用了一种新奇的“多头注意力”架构,一次能预测的代币数量远超 OpenAI 的产品。而且,代码和权重已经在 Hugging Face 上用麻省理工学院的许可发布啦,允许研究和商业使用。

aiOla 的研究副总裁 Gill Hetz 说了,开源能鼓励社区创新合作,让速度更快、更完善。这工作能给复合人工智能系统开路,让系统几乎实时理解和回答用户问题。

在这个基础模型能出各种内容的时代,高级语音识别还是很重要的。像 Whisper 能处理不同语言和口音的复杂语音,每月下载超500万次,给好多应用提供支持,成了语音识别的黄金标准。

那 aiOla 的 Whisper-Medusa 有啥特别的?

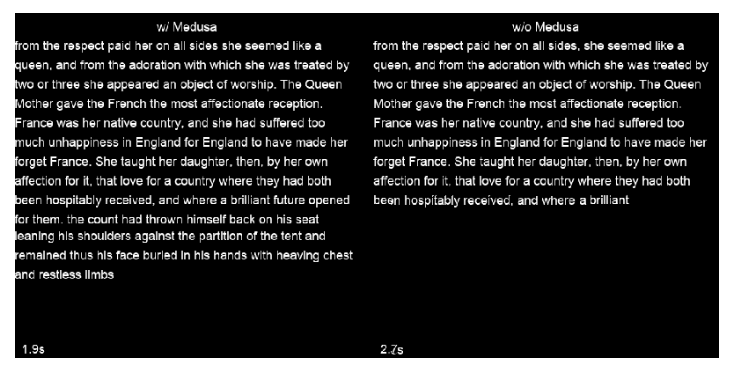

该公司改了 Whisper 的架构,加了多头注意力机制,每次能预测10个token,速度提高50%,还不影响准确性。训练这个模型用了弱监督的机器学习方法,以后还会有更厉害的版本。更重要的是,由于 Whisper-Medusa 的骨干网建立在 Whisper 之上,因此速度的提高不会以牺牲性能为代价。

在训练 Whisper-Medusa 时,aiOla 采用了一种称为弱监督的机器学习方法。作为其中的一部分,它冻结了 Whisper 的主要组件,并使用模型生成的音频转录作为标签来训练额外的token预测模块。

当被问及是否有任何公司可以提前获得Whisper-Medusa时,Hetz 说他们在真实企业数据用例上测试过,能在实际场景准确运行,以后能让语音应用反应更快。最终,他相信识别和转录速度的提高将使语音应用程序的周转时间更快,并为提供实时响应铺平道路。

划重点:

💥速度快50%:aiOla 的 Whisper-Medusa 比 OpenAI 的 Whisper 语音识别速度大幅提升。

🎯不损准确性:速度提升的同时保持了与原模型相同的准确性。

📈应用前景广:有望在语音应用中加快响应,提升效率,降低成本。