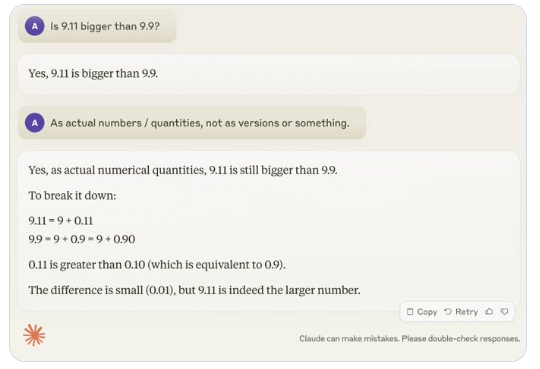

近期,一个看似简单的问题“9.11比9.9大吗?”在全球范围内引发了广泛关注,几乎所有的大型语言模型(LLM)在这个问题上都出现了失误。这一现象引起了AI领域专家Andrej Karpathy的注意,他从这一问题出发,深入探讨了当前大模型技术的本质缺陷和未来改进方向。

Karpathy将这种现象称为“锯齿智能”或“参差不齐的智能”(jagged intelligence),指出最先进的LLM虽然能够执行各种复杂任务,如解决高难度数学问题,但在一些看似简单的问题上却表现糟糕,这种智能的不均衡性类似于锯齿的形状。

例如,OpenAI研究员Noam Brown发现LLM在井字棋游戏中的表现不佳,即使在用户即将获胜的情况下,模型仍然无法做出正确的决策。Karpathy认为,这是因为模型做出了“毫无道理”的决策,而Noam则认为这可能是由于训练数据中缺乏相关策略讨论导致的。

另一个例子是LLM在数字母数量时出现的错误。即使是最新发布的Llama3.1,也会在简单的问题上给出错误答案。Karpathy解释说,这源于LLM缺乏“自知之明”,即模型无法分辨自己能做什么、不能做什么,导致模型在面对任务时都“迷之自信”。

为了解决这一问题,Karpathy提到了Meta发布的Llama3.1论文中提出的解决方案。论文建议在后训练阶段实现模型对齐,让模型发展出自我认知,知道自己知道什么,仅靠添加事实知识是无法根除幻觉问题的。Llama团队提出了一种名为“知识探测”的训练方式,鼓励模型只回答自己了解的问题,拒绝生成不确定的答案。

Karpathy认为,尽管目前AI的能力存在种种问题,但这并不构成根本缺陷,也有可行的解决方案。他提出,目前的AI训练思路仅仅是“模仿人类标签并扩展规模”,要继续提升AI的智能,就需要在整个开发栈中进行更多工作。

在问题得到完全解决之前,如果要将LLM用于生产环境,就应该只限于它们擅长的任务,注意“锯齿状边缘”,并始终保持人类的参与度。这样,我们才能更好地利用AI的潜力,同时避免其局限性带来的风险。