在3d数字人领域,尽管已有显著进展,但此前的方法仍存在多视角一致性及情感表现力不足的问题。为解决这些难题,来自南京大学、复旦大学和华为诺亚方舟实验室的研究团队有了新突破。

产品入口:https://nju-3dv.github.io/projects/EmoTalk3D/

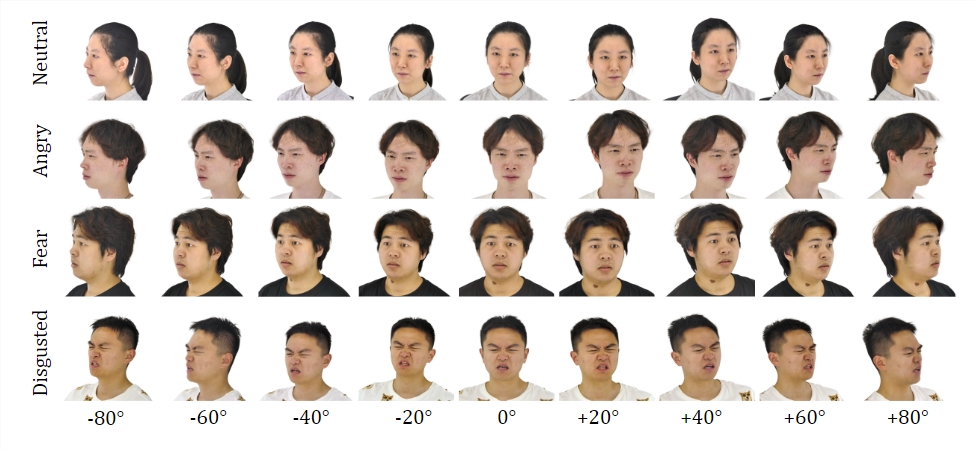

他们收集了带有校准多视角视频、情感标注和逐帧3D 几何的 EmoTalk3D 数据集。并提出了一种用于合成具有可控情感的3D 说话头像的新方法,在唇同步和渲染质量方面都有显著提升。

数据集:

通过在 EmoTalk3D 数据集上进行训练,研究团队构建了一个“从语音到几何再到外观”的映射框架。首先从音频特征预测出逼真的3D 几何序列,然后基于预测的几何合成由4D 高斯表示的3D 说话头像的外观。外观进一步分解为标准和动态高斯,从多视角视频中学习,并融合以呈现自由视角的说话头像动画。

该模型能够在生成的说话头像中实现可控情感,并可在大范围视角中进行渲染。在捕捉皱纹和细微表情等动态面部细节的同时,展现出了在唇动生成方面改进的渲染质量和稳定性。在生成结果的示例中,精准的展示了3D数字人的开心、生气、沮丧的表情。

其整体流程包含五个模块:

一是情感内容分解编码器,从输入语音中解析内容和情感特征;二是语音到几何网络,从特征预测动态3D 点云;三是高斯优化和完成模块,建立标准外观;四是几何到外观网络,基于动态3D 点云合成面部外观;五是渲染模块,将动态高斯渲染为自由视角动画。

此外,他们还建立了 EmoTalk3D 数据集,这是一个带有逐帧3D 面部形状的情感标注多视角说话头像数据集,并将为非商业研究目的向公众开放。

划重点:

💥 提出合成可控情感数字人的新方法。

🎯 构建“从语音到几何再到外观”的映射框架。

👀 建立 EmoTalk3D 数据集并准备开放。