在人工智能的世界里,有一群特殊的"画家"——Transformer模型中的层级结构。它们像一支支神奇的画笔,在语言的画布上描绘出丰富多彩的世界。最近,一篇名为"Transformer Layers as Painters"的论文,为我们理解Transformer中间层的工作机制提供了新的视角。

Transformer模型,作为当下最流行的大型语言模型,拥有数十亿的参数量。它的每一层,就像一位位画家,共同完成一幅宏大的语言画卷。但这些"画家"是如何协同工作的?它们使用的"画笔"和"颜料"又有何不同?这篇论文试图回答这些问题。

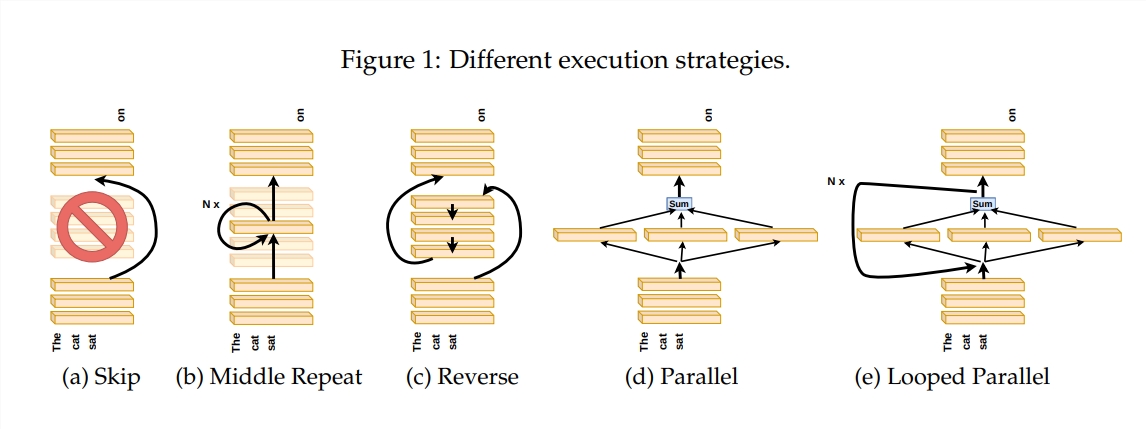

为了探究Transformer层的工作原理,作者设计了一系列实验,包括跳过某些层、改变层的顺序或并行运行层等。这些实验就好比给"画家"们设置不同的作画规则,看看他们能否适应。

在「画家流水线」的比喻中,输入被看作是一张画布,通过中间层的过程就像是画布在流水线上的传递。每个「画家」,即Transformer的每个层,都会根据自己的专长对画作进行修改。这种类比帮助我们理解了Transformer层的并行性和可调整性。

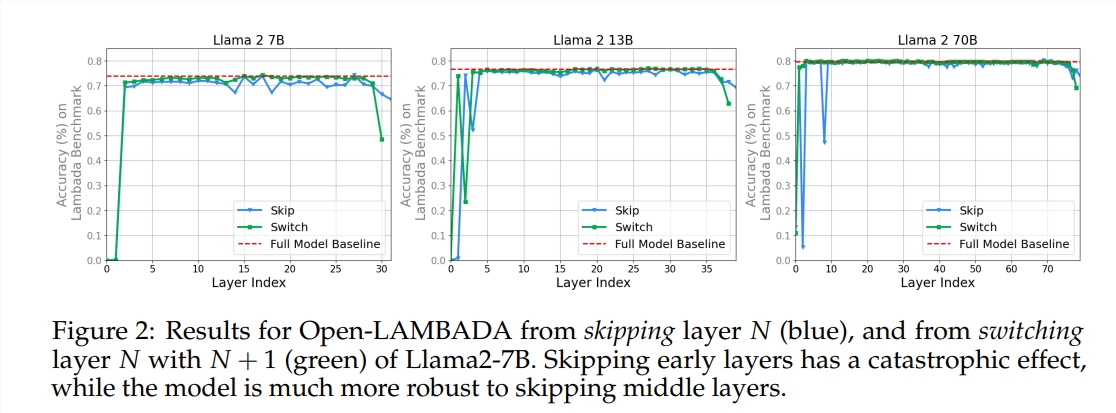

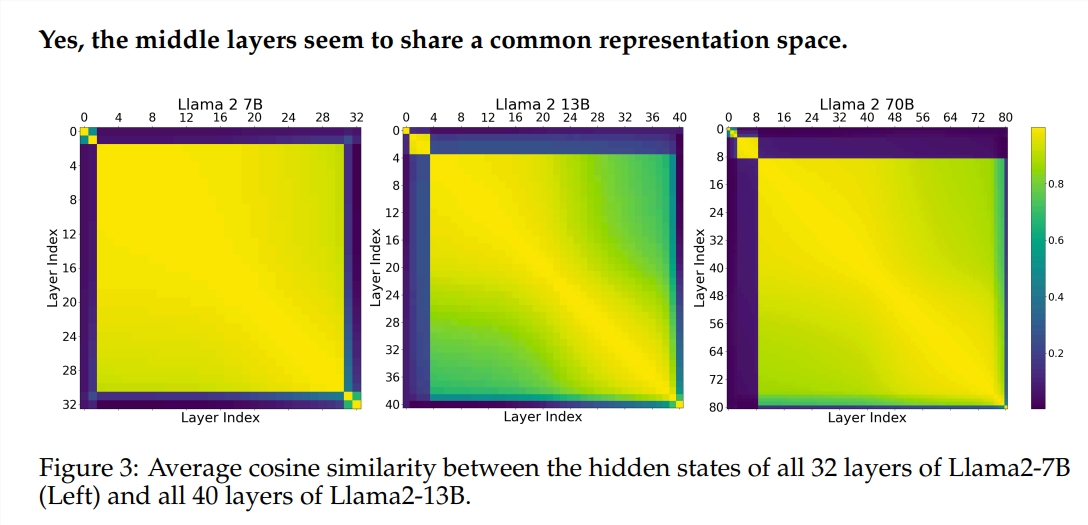

实验使用了两种预训练的大型语言模型(LLM):Llama2-7B和BERT。研究发现,中间层的"画家"们似乎共享着一个共同的"颜料盒"——表示空间,而与首尾层有所不同。跳过某些中间层的"画家",对整幅画作的影响并不大,说明并非所有"画家"都是必须的。

尽管中间层的"画家"们使用相同的"颜料盒",但它们却用各自的技艺,在画布上描绘出不同的图案。如果简单地重复使用某位"画家"的技艺,画作就会失去原有的魅力。

对于需要严密逻辑的数学和推理任务,"作画"的顺序尤为重要。而对于依赖语义理解的任务,顺序的影响则相对较小。

研究结果表明,Transformer的中间层具有一定程度的一致性,但并不冗余。对于数学和推理任务,层的顺序比语义任务更为重要。

研究还发现,并非所有层都是必要的,中间层可以跳过而不会灾难性地影响模型性能。此外,中间层虽然共享相同的表征空间,但它们执行着不同的功能。改变层的执行顺序会导致性能下降,表明顺序对于模型性能有重要影响。

在探索Transformer模型的道路上,许多研究者都在尝试对其进行优化,包括剪枝、减少参数等。这些工作为理解Transformer模型提供了宝贵的经验和启示。

论文地址:https://arxiv.org/pdf/2407.09298v1