在一个由数据和算法主导的数字世界里,人工智能的每一步成长都离不开一个关键元素——检查点(Checkpoint)。想象一下,当你正在训练一个能读懂人心、对答如流的大型语言模型时,这个模型聪明绝顶,但也是个"大胃王",需要海量计算资源来"喂饱"它。在训练过程中,如果突然断电或硬件故障,损失将是巨大的。这时,检查点就像一台"时光机",能让一切回到上一个安全状态,继续未完成的任务。

然而,这台"时光机"本身也需要精心设计。来自字节跳动和香港大学的科学家们,在论文《ByteCheckpoint: A Unified Checkpointing System for LLM Development》中,为我们带来了一种全新的检查点系统——ByteCheckpoint。它不仅是一个简单的备份工具,更是一个能大幅提升大型语言模型训练效率的神器。

首先,我们需要了解大型语言模型(LLM)面临的挑战。这些模型之所以"大",是因为它们需要处理和记忆海量信息,这带来了高训练成本、资源消耗大、容错能力弱等问题。一旦发生故障,可能会导致长时间的训练功亏一篑。

检查点系统就像模型的"快照",在训练过程中定期保存状态,这样即使出现问题,也能快速恢复到最近的状态,减少损失。然而,现有的检查点系统在处理大型模型时,常因I/O(输入/输出)瓶颈导致效率低下。

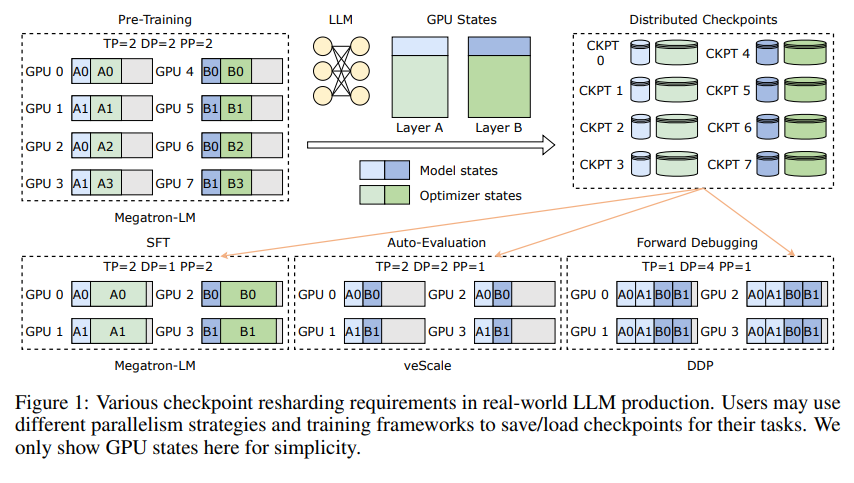

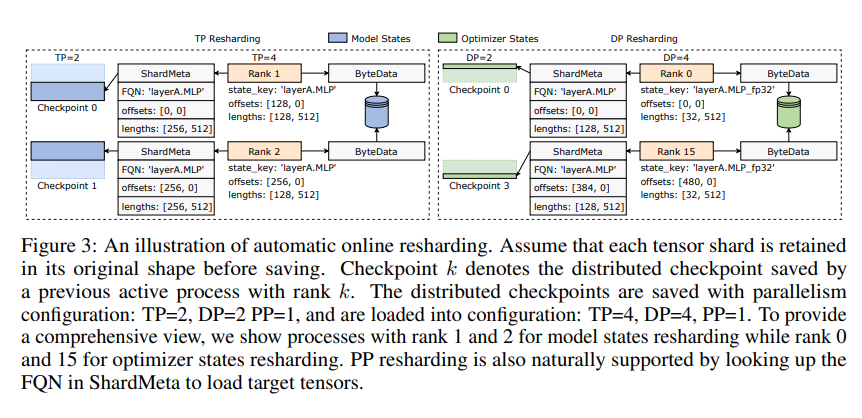

ByteCheckpoint的创新之处在于采用了一种新颖的存储架构,将数据和元数据分离,更灵活地处理不同并行配置和训练框架下的检查点。更妙的是,它支持自动在线检查点重分片,可在不中断训练的情况下,动态调整检查点以适应不同硬件环境。

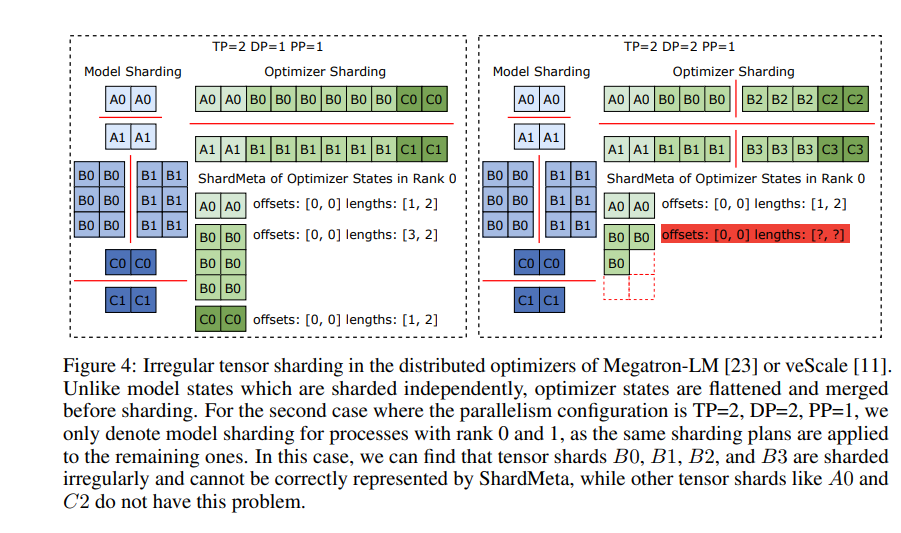

ByteCheckpoint还引入了一项关键技术——异步张量合并。这能高效处理那些在不同GPU上分布不均的张量,确保在检查点重分片时,模型的完整性和一致性不会受影响。

为了提升检查点保存和加载的速度,ByteCheckpoint还集成了一系列I/O性能优化措施,如精细的保存/加载流水线、Ping-Pong内存池、工作负载平衡保存和零冗余加载等,大大减少了训练过程中的等待时间。

通过实验验证,与传统方法相比,ByteCheckpoint在检查点保存和加载上的速度分别提高了数十倍甚至数百倍,显著提升了大型语言模型的训练效率。

ByteCheckpoint不仅是一个检查点系统,更是大型语言模型训练过程中的得力助手,是通往更高效、更稳定AI训练之路的关键所在。

论文地址:https://arxiv.org/pdf/2407.20143