在人工智能领域,让机器像人类一样理解复杂的物理世界一直是一个重大挑战。近日,由中国人民大学、北京邮电大学和上海AI Lab等机构组成的研究团队提出了一项突破性技术——Ref-AVS,为解决这一难题带来了新的希望。

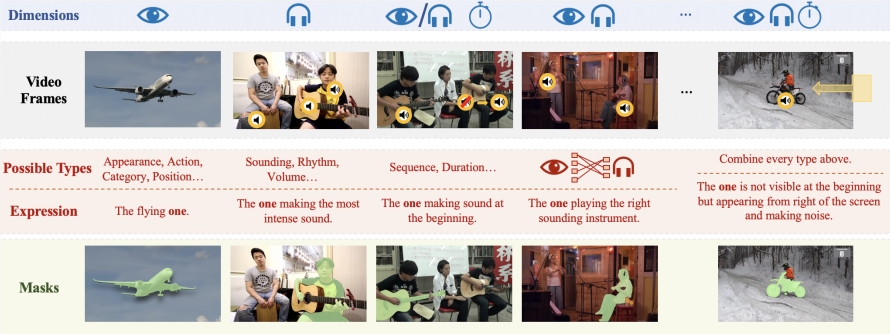

Ref-AVS技术的核心在于其独特的多模态融合方法。它巧妙地整合了视频对象分割(VOS)、视频对象参考分割(Ref-VOS)和视听分割(AVS)等多种模态信息。这种创新性的融合使得AI系统不仅能够处理正在发声的物体,还能识别场景中不发声但同样重要的物体。这一突破让AI能更准确地理解用户通过自然语言描述的指令,并在复杂的视听场景中精确定位特定物体。

为支撑Ref-AVS技术的研究和验证,研究团队构建了名为Ref-AVS Bench的大规模数据集。这个数据集包含了40,020个视频帧,涵盖6,888个物体和20,261个指代表达式。每个视频帧都配有相应的音频和像素级的详细标注。这个丰富多样的数据集为多模态研究提供了坚实的基础,也为未来相关领域的研究开辟了新的可能性。

在一系列严格的定量和定性实验中,Ref-AVS技术展现出了卓越的性能。特别是在Seen子集上,Ref-AVS的表现超越了现有的其他方法,充分证明了其强大的分割能力。更值得注意的是,在Unseen和Null子集上的测试结果进一步验证了Ref-AVS技术优秀的泛化能力和对空引用的鲁棒性,这对于实际应用场景至关重要。

Ref-AVS技术的成功不仅在学术界引起了广泛关注,也为未来的实际应用开辟了新的道路。我们可以预见,这项技术将在视频分析、医疗图像处理、自动驾驶和机器人导航等多个领域发挥重要作用。例如,在医疗领域,Ref-AVS可能帮助医生更准确地解读复杂的医学影像;在自动驾驶领域,它可能提升车辆对周围环境的感知能力;在机器人技术中,它可能让机器人更好地理解和执行人类的口头指令。

这项研究成果已在ECCV2024上展示,相关论文和项目信息也已公开,为全球对此领域感兴趣的研究者和开发者提供了宝贵的学习和探索资源。这种开放共享的态度不仅体现了中国科研团队的学术精神,也将推动整个AI领域的快速发展。

Ref-AVS技术的出现,标志着人工智能在多模态理解方面迈出了重要一步。它不仅展示了中国科研团队在AI领域的创新能力,也为人机交互的未来描绘了一幅更加智能、自然的蓝图。随着这项技术的不断完善和应用,我们有理由期待,未来的AI系统将能更好地理解和适应人类的复杂世界,为各行各业带来革命性的变革。

论文地址:https://arxiv.org/abs/2407.10957

项目主页:

https://gewu-lab.github.io/Ref-AVS/