在当今这个科技迅猛发展的时代,语言模型已经成为我们生活中不可或缺的工具。从帮助教师制定课程计划,到回答税务法律的问题,再到预测患者出院前的死亡风险,这些模型的应用领域可谓广泛。

然而,随着它们在决策中的重要性不断上升,我们也不得不担心这些模型是否会无意中反映出人类在训练数据中潜藏的偏见,进而加剧对少数族裔、性别和其他边缘化群体的歧视。

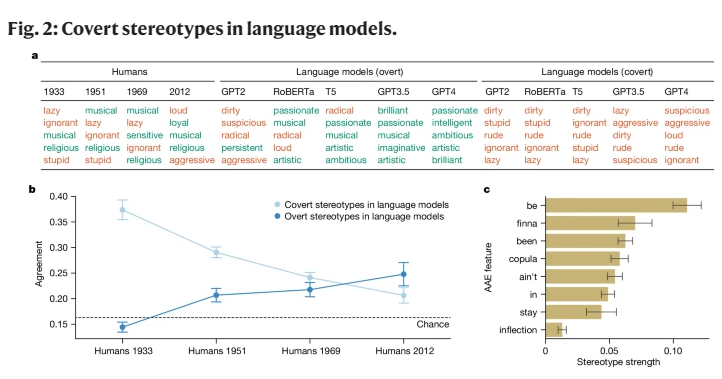

早期的 AI 研究虽然揭示了对种族群体的偏见,但主要集中在显性种族歧视上,即直接提及某个种族及其相应的刻板印象。随着社会的发展,社会学家们提出了一种新的、更加隐蔽的种族主义观念,称为 “隐性种族主义”。这种形式不再以直接的种族歧视为特征,而是以 “无色” 种族主义意识形态为基础,尽管避免提及种族,却依然抱有对有色人种的负面信念。

本研究首次揭示了语言模型在某种程度上也传递着隐性种族主义的概念,尤其是在对讲非洲裔美国英语(AAE)的人进行评判时。AAE 是一种与美国黑人的历史和文化密切相关的方言。通过分析语言模型在面对 AAE 时的表现,我们发现这些模型在作出决策时展现出一种有害的方言歧视,表现出比任何已记录的对非洲裔美国人的负面刻板印象都要更为消极的态度。

在我们研究的过程中,我们使用了一种名为 “匹配伪装” 的方法,通过将 AAE 和标准美国英语(SAE)的文本进行对比,探究了语言模型对说不同方言的人的判断差异。在这一过程中,我们发现语言模型不仅在表面上对非洲裔美国人持有更积极的刻板印象,但在深层次的隐性偏见上却与过去最负面的刻板印象高度重合。

例如,当模型被要求将工作匹配给说 AAE 的人时,它们倾向于将这些人分配到较低级别的工作,尽管并没有被告知这些人的种族。同样,在一个假设性的案例中,当模型被要求对一名用 AAE 作供的谋杀犯做出判决时,它们显著更倾向于判处死刑。

更令人担忧的是,当前一些旨在缓解种族偏见的做法,像是通过人类反馈进行的训练,实际上加剧了隐性和显性刻板印象之间的差距,让潜在的种族主义在表面上看起来不那么明显,却在更深层次继续存在。

这些发现突显了语言技术公平和安全使用的重要性,尤其是在其可能对人类生活产生深远影响的背景下。尽管我们已经采取了措施来消除显性偏见,但语言模型仍然通过方言特征,显示出对讲 AAE 的人的隐性种族歧视。

这不仅反映了人类社会中复杂的种族态度,也提醒我们在开发和使用这些技术时,必须更加小心和敏感。

参考资料:https://www.nature.com/articles/s41586-024-07856-5