最近,NVIDIA 联合 Georgia Tech、UMD 和 HKPU 的研究团队推出了全新的视觉语言模型 ——NVEagle。它能看懂图片还能跟你聊天,这相当于一个会看会说的超级助手。

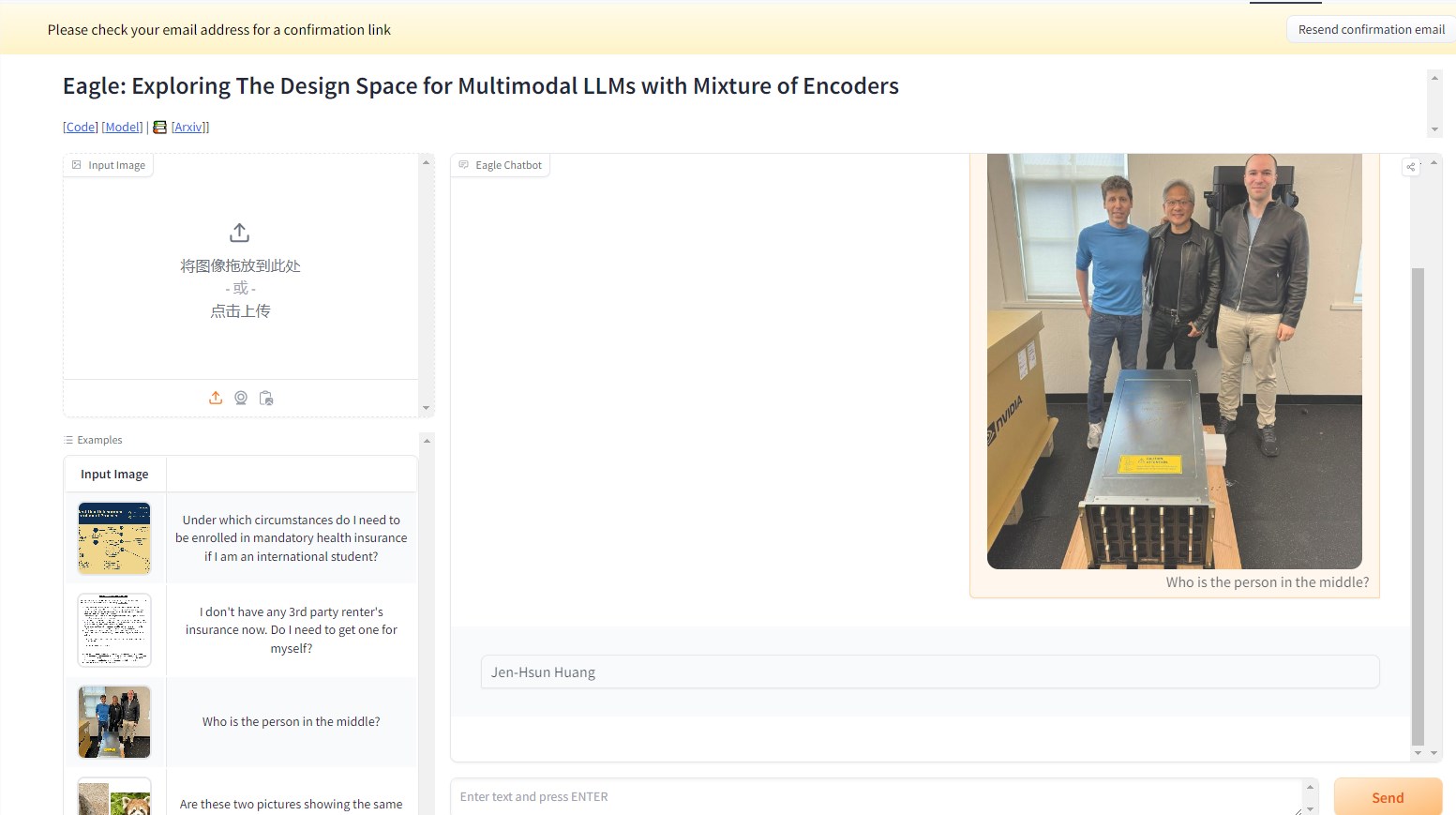

比如在下面的实例中,向NVEagle模型询问图片中的人物是谁?模型就能对图片进行解读,给出回复的答案是:黄仁勋。相当精准。

这个多模态的大型语言模型(MLLM)在视觉和语言信息的结合上,迈出了重要一步。NVEagle 能够理解复杂的现实场景,通过视觉输入进行更好的解读和回应。它的设计核心在于将图像转化为视觉标记,再与文本嵌入相结合,进而提升了对视觉信息的理解。

然而,构建这样一个强大的模型也面临着不少挑战,尤其是在视觉感知能力的提升方面。研究表明,许多现有模型在处理高分辨率图像时,会出现 “幻觉” 现象,也就是生成不准确或无意义的输出。这在需要细致分析的任务中尤为明显,比如光学字符识别(OCR)和文档理解。为了克服这些困难,研究团队进行了多种方法的探索,包括测试不同的视觉编码器和融合策略。

NVEagle 的推出是这一研究的成果,具体包括了三个版本:Eagle-X5-7B、Eagle-X5-13B 以及 Eagle-X5-13B-Chat。其中,7B 和13B 版本主要用于一般的视觉语言任务,而13B-Chat 版本则专门针对对话式 AI 进行了微调,能够更好地进行基于视觉输入的互动。

NVEagle 的一个亮点在于采用了混合专家(MoE)机制,能够根据不同任务动态选择最合适的视觉编码器,这极大提升了对复杂视觉信息的处理能力。该模型已在 Hugging Face 上发布,方便研究人员和开发者使用。

在各种基准测试中,Eagle 模型的表现相当出色。例如,在 OCR 任务中,Eagle 模型在 OCRBench 上获得了85.9的平均分,超过了 InternVL 和 LLaVA-HR 等其他领先模型。而在 TextVQA 测试中,它的得分达到了88.8,在复杂的视觉问答任务中也表现不俗,GQA 测试得分为65.7。此外,模型在增加额外视觉专家的情况下,表现也持续提升。

NVEagle 系列模型通过系统化的设计探索和优化,成功解决了视觉感知中的多项关键挑战,为视觉语言模型的发展开辟了新天地。

项目入口:https://top.aibase.com/tool/eagle

demo:https://huggingface.co/spaces/NVEagle/Eagle-X5-13B-Chat

划重点:

🌟 NVEagle 是 NVIDIA 推出的新一代视觉语言模型,旨在提高对复杂视觉信息的理解。

📈 模型包含三个版本,分别适用于不同的任务,其中13B-Chat 版本专注于对话式 AI。

🏆 在多个基准测试中,Eagle 模型的表现优于现有许多领先模型,展现出卓越的性能。