相关AI新闻推荐

阿里国际开源Ovis2系列多模态大语言模型 共有六个版本

Ovis2 是阿里巴巴国际化团队提出的Ovis系列模型的最新版本。与前序1. 6 版本相比,Ovis2 在数据构造和训练方法上都有显著改进。它不仅强化了小规模模型的能力密度,还通过指令微调和偏好学习大幅提升了思维链(CoT)推理能力。此外,Ovis2 引入了视频和多图像处理能力,并增强了多语言能力和复杂场景下的OCR能力,显著提升了模型的实用性。

深推理模型崛起!Together AI融资3.05亿美元助推GPU需求

在 AI 行业,Together AI 最近宣布完成了一轮3.05亿美元的 B 轮融资,这一消息引起了广泛关注。该公司的崛起与其新推出的深度理模型 DeepSeek-R1密切相关。与最初的担忧相反,许行业专家认为,深度推理的进步并没有降低对基础设施的需求,反而在不断提升这一需求。图源备注:图片由AI生成,图片授权服务商Midjourney自2023年成立以来,Together AI 旨在简化企业对开源大型语言模型(LLM)的使用。随着时间的推移,该公司逐步扩展其平台,提供了一个名为 “Together 平台” 的解决方案,支持在虚

VLM-R1引领视觉语言模型新纪元 多模态AI迎来新突破

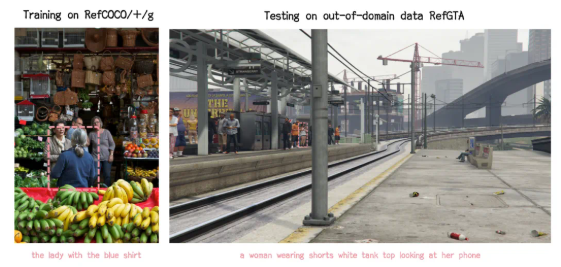

近日,VLM-R1项目的成功推出为这一领域带来了新的曙光。该项目是 DeepSeek 团队的 R1方法在视觉语言模型中的成功迁移,意味着 AI 对视觉内容的理解将进入一个全新的阶段。VLM-R1的灵感源自于去年 DeepSeek 开源的 R1方法,该方法利用了 GRPO(Generative Reward Processing Optimization)强化学习技术,在纯文本处理上取得了优异的表现。如今,VLM-R1团队将这一方法成功地应用于视觉语言模型,为多模态 AI 的研究开辟了新天地。在项目的验证结果中,VLM-R1的表现令人惊艳。首先,R1方法在复杂场景下展现出

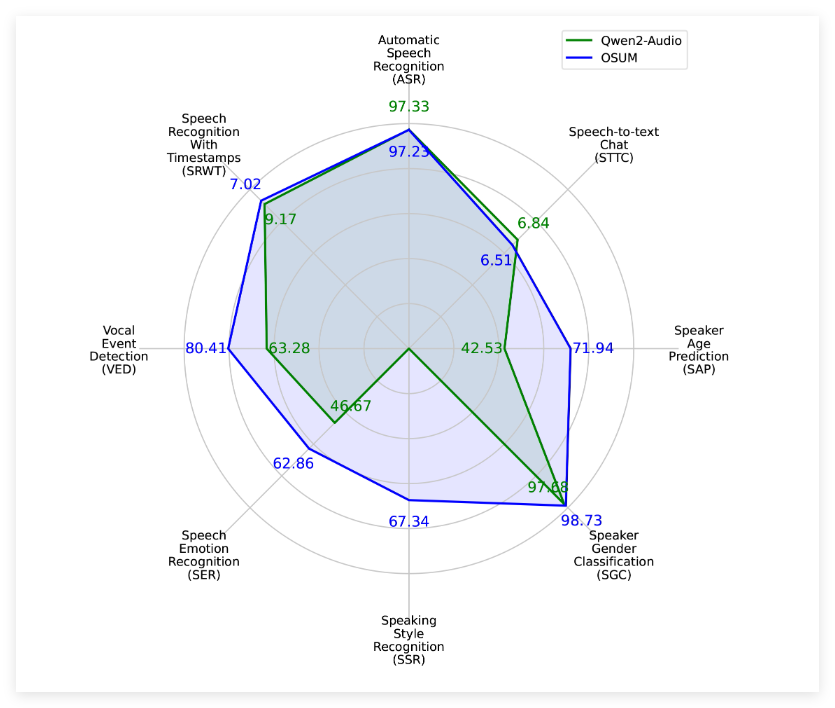

西北工业大学开源语音理解模型OSUM,结合Whisper和Qwen2,支持8种语音理解任务

在人工智能领域,语言模型的快速发展引发了语音理解语言模型(SULMs)的广泛关注。近日,西北工业大学 ASLP 实验室发布了开放语音理解模型 OSUM,旨在探索在学术资源有限的情况下,如何有效训练和利用语音理解模型,以推动学术界的研究与创新。OSUM 模型融合了 Whisper 编码器与 Qwen2语言模型,支持8种语音任务,包括语音识别(ASR)、带时间戳的语音识别(SRWT)、语音事件检测(VED)、语音情感识别(SER)、说话风格识别(SSR)、说话人性别分类(SGC)、说话人年龄预测(SAP)及语音转文本聊天(STTC)。