近日,谷歌宣布推出一款名为 “gemma-2-2b-jpn-it” 的新模型,这是其 Gemma 系列语言模型的最新成员。这个模型专门针对日本语言进行优化,展示了谷歌在大型语言模型(LLM)领域持续投入的决心。

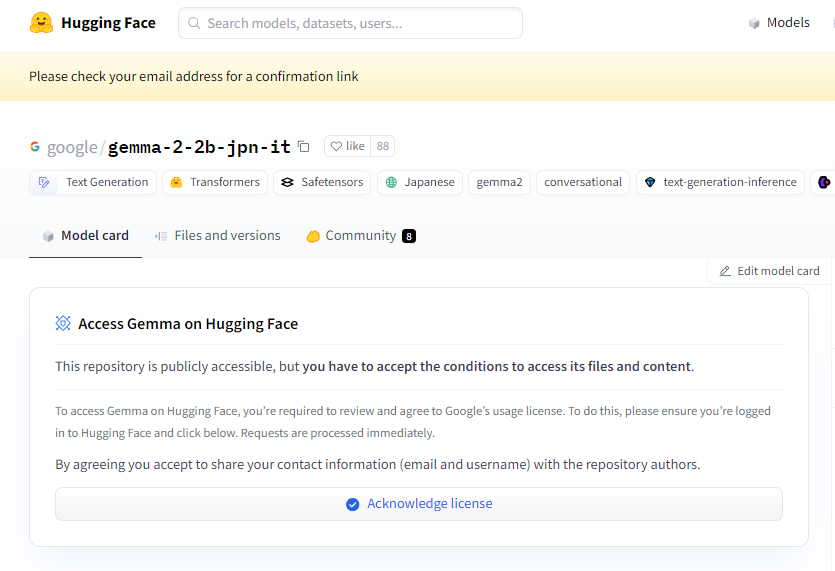

项目入口:https://huggingface.co/google/gemma-2-2b-jpn-it

gemma-2-2b-jpn-it 是一款文本到文本的解码器型大语言模型,具有开放权重,意味着它可以被公众访问,并能够根据不同的文本生成任务进行细致调优,比如问答、总结和推理等。

这款新模型拥有26.1亿个参数,并采用 BF16张量类型。它基于谷歌的 Gemini 系列模型架构而设计,具备了非常先进的技术文档和资源,开发者可以轻松使用推理将其集成到各种应用中。值得提的是,这款模型兼容谷歌最新的 TPU 硬件,特别是 TPUv5p。这种硬件提供了强大的计算能力,使得模型的训练速度更快、性能更好,远超传统的 CPU 基础设施。

在软件方面,gemma-2-2b-jpn-it 使用 JAX 和 ML Pathways 框架进行训练。JAX 经过特别优化,适合高性能机器学习应用,而 ML Pathways 则提供了灵活的平台来组织整个训练流程。这样的结合使得谷歌能够实现高效的训练工作流程。

随着 gemma-2-2b-jpn-it 的发布,它在多个领域的应用潜力得到了广泛关注。这款模型能够在内容创作和沟通方面大显身手,比如生成诗歌、剧本、代码、营销文案,甚至是聊天机器人回复。它的文本生成能力同样适用于摘要任务,可以将大量文本浓缩成简明的摘要,非常适合用于研究、教育和知识探索。

然而,gemma-2-2b-jpn-it 也有一些局限性,用户需要了解。模型的表现依赖于其训练数据的多样性和质量,如果数据中存在偏差或缺失,可能会影响模型的回应。此外,由于大型语言模型并不内置知识库,在处理复杂查询时,可能会生成不准确或过时的事实陈述。

在开发过程中,谷歌也十分重视伦理考量,对 gemma-2-2b-jpn-it 进行了严格的评估,以应对与内容安全、代表性损害以及训练数据记忆相关的问题。谷歌还实施了过滤技术,以排除有害内容,并建立了透明和问责框架,鼓励开发者持续监控并采用隐私保护技术确保遵守数据隐私法规。

划重点:

🌟 谷歌推出的 gemma-2-2b-jpn-it 模型专为日本语言优化,具备26.1亿参数和先进的技术架构。

💡 该模型在内容创作、自然语言处理等领域具有广泛应用潜力,支持多种文本生成任务。

🔒 谷歌在模型开发中重视伦理考量,实施内容安全过滤和隐私保护措施,以减少风险。