人工智能正以惊人的速度颠覆各个行业,视频制作领域也不例外。近期,AI视频生成模型的出现引发了广泛关注,甚至有人声称它将彻底改变好莱坞的未来。

然而,这项技术的实际能力究竟如何?香港中文大学和腾讯的研究人员通过"VideoGen-Eval"项目,对当前主流AI视频生成模型进行了全面评估,揭示了这一新兴技术的真实水平。

研究团队从多个维度对AI视频生成模型进行了测试,包括文本与视频的一致性、画面组合、场景过渡、创造性、风格化、稳定性以及动作多样性等。结果显示,虽然AI在某些方面取得了显著进展,但距离完美还有相当长的路要走。

各大视频模型综合对比如下:

在文本生成视频(T2V)方面,Gen-3、Kling v1.5和 Minimax 表现出色,其中 Minimax 在文本控制方面表现突出,尤其在人物表情、运镜、多镜头生成和主体动态方面表现优异。

Gen-3在控制光照、纹理和电影化技巧方面表现出色,而 Kling v1.5则在视觉效果、可控性和动作能力之间取得了良好的平衡。

Pika1.5在特定视频特效生成方面表现突出, 例如膨胀、融化、爆炸等特效。

对比视频如下:

提示词:Static camera, a glass ball rolls on a smooth tabletop

提示词:FPV aerial shot, the sunshine shines on the snow capped mountains, a quiet atmosphere

提示词:Zooming in hyper-fast to a red rose and showcase the details of its petals

目前市面上的 AI 视频生成模型主要有两类:闭源和开源。闭源模型就相当于那些高科技公司的独门秘籍,比如 Runway 公司的 Gen-3和 LumaLabs 公司的 Dream Machine,这些模型通常生成视频质量更高,功能更强大,但你不花点钱就别想体验。

而开源模型就相当于江湖上的武功秘籍,人人都可以学习,比如 Open-Sora 和 EasyAnimate,虽然效果可能不如闭源模型,但胜在免费开源,人人都能参与进来。

"VideoGen-Eval" 这个项目测试了各种 AI 视频生成模型,包括文本生成视频 (T2V)、图像生成视频 (I2V) 和视频生成视频 (V2V) 三个方面。结果发现,这些模型虽然在某些方面取得了很大进步,比如画面质量、动作自然度和与文本描述的匹配度,但离我们想象中的完美,还差得远呢!

先说优点,现在的 AI 已经可以生成一些简单的视频了, 比如你输入“一只泰迪熊在超市里走动,镜头逆时针旋转”,AI 就能生成一段镜头旋转的泰迪熊视频。听起来是不是挺神奇的?但是,如果你想让 AI 生成一些复杂的场景,比如“一个人在游泳池里游泳,水花四溅”,或者“三只猴子在森林里跳跃,两只鹦鹉在树丛中飞翔”,那 AI 就开始抓瞎了。

究其原因,主要是因为 AI 对物理规律、空间关系、物体属性等方面的理解还不到位。 比如你让 AI 生成一段“玻璃球在桌子上滚动”的视频,AI 可能就不知道玻璃球应该怎么滚才符合物理规律,最后生成的视频就会很奇怪。

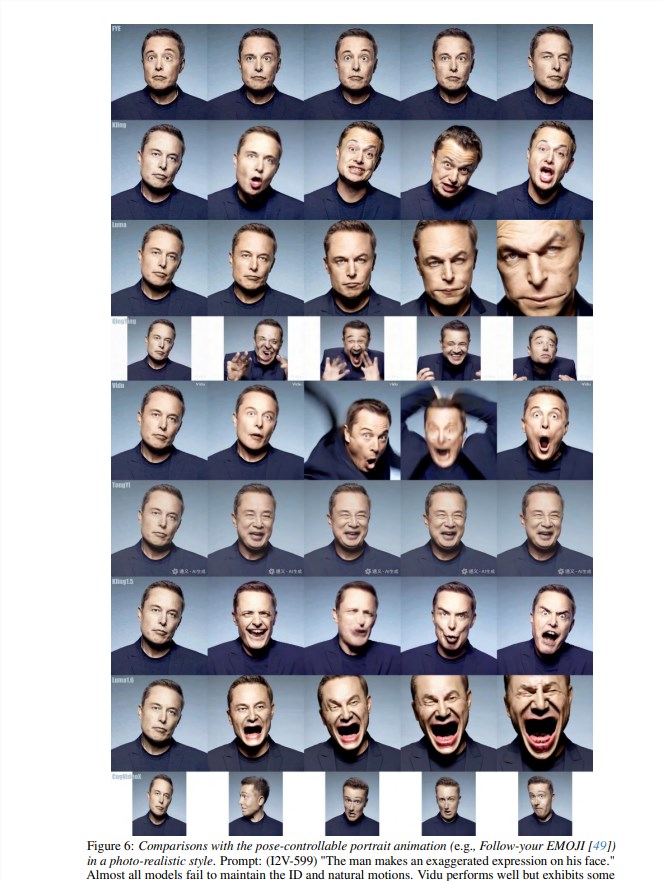

除此之外,AI 在处理快速运动、人物表情、多人物交互等方面也存在很大问题。 比如你想让 AI 生成一段打棒球的视频,结果 AI 生成的画面可能就会非常鬼畜,人物动作完全不协调,甚至连棒球都飞到九霄云外去了。

更别提那些需要 AI 发挥想象力和创造力的场景了, 比如你想让 AI 生成一段“一个人被五彩烟雾包围”的视频,AI 可能就只会生成一堆乱七八糟的颜色,根本看不出是什么东西。总之,目前所有模型都无法做到完美, 在处理复杂动作、多物体交互、物理模拟、语义理解、精细控制等方面仍存在很大挑战。

完整测评视频点此查看:https://ailab-cvc.github.io/VideoGen-Eval/#text-to-video