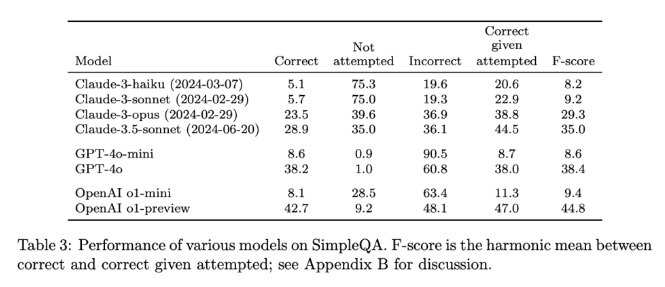

最近,OpenAI 发布了一个名为 SimpleQA 的新基准测试,旨在评估语言模型生成回答的事实准确性。

随着大型语言模型的快速发展,确保生成内容的准确性面临着诸多挑战,尤其是那些所谓的 “幻觉” 现象,即模型生成了听起来很自信但实际上是错误或不可验证的信息。这种情况在越来越多的人依赖 AI 获取信息的背景下,变得尤为重要。

SimpleQA 的设计特色在于它专注于短小、明确的问题,这些问题通常有一个确凿的答案,这样就能更容易地评估模型的回答是否正确。与其他基准不同,SimpleQA 的问题是经过精心设计的,旨在让即便是最先进的模型如 GPT-4也会面临挑战。这个基准包含了4326个问题,覆盖历史、科学、技术、艺术和娱乐等多个领域,特别注重评估模型的精准度和校准能力。

SimpleQA 的设计遵循了一些关键原则。首先,每个问题都有一个由两个独立的 AI 训练师确定的参考答案,确保了答案的正确性。

其次,问题的设置避免了模糊性,每个问题都能用一个简单明确的答案来回答,这样评分就变得相对容易。此外,SimpleQA 还使用了 ChatGPT 分类器来进行评分,明确标记回答为 “正确”、“错误” 或 “未尝试”。

SimpleQA 的另一个优势是它涵盖了多样化的问题,防止模型过度专门化,确保全面评估。这一数据集的使用简单,因为问题和答案都很简短,使得测试运行快速且结果变化小。而且,SimpleQA 还考虑了信息的长期相关性,从而避免了因信息变化而导致的影响,使其成为一个 “常青” 的基准。

SimpleQA 的发布是推动 AI 生成信息可靠性的重要一步。它不仅提供了一个易于使用的基准测试,更为研究人员和开发者设定了一个高标准,鼓励他们创建不仅能生成语言而且能做到真实准确的模型。通过开放源代码,SimpleQA 为 AI 社区提供了一个宝贵的工具,帮助提升语言模型的事实准确性,以确保未来的 AI 系统既能提供信息又值得信赖。

项目入口:https://github.com/openai/simple-evals

详情页:https://openai.com/index/introducing-simpleqa/

划重点:

📊 SimpleQA 是 OpenAI 推出的全新基准,专注于评估语言模型的事实准确性。

🧠 该基准由4326个短小明确的问题组成,覆盖多个领域,确保全面评估。

🔍 SimpleQA 帮助研究者识别和提升语言模型在生成准确内容方面的能力。