Meta FAIR 实验室近日发布了一项名为“Sparsh”的人工多模态指尖触觉感知技术,该技术可赋予机器人近似人类的触觉感知能力,有望在机器人操控领域带来革命性的变化。

Sparsh 模型采用自监督学习的方式,利用超过46万张触觉图像进行预训练,无需人工标注数据,即可学习通用的触觉表征。

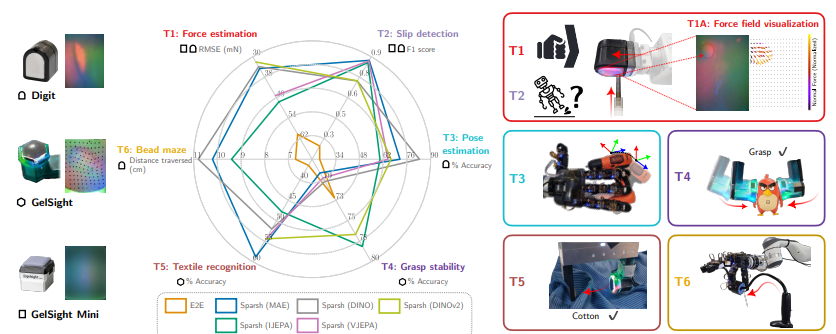

该模型能够支持多种类型的视觉触觉传感器,包括 DIGIT、GelSight2017和 GelSight Mini,并显著提升了机器人在触觉感知任务上的性能,如力估计、滑动检测、姿态估计、抓取稳定性预测和织物识别等。 研究人员还构建了一个名为 TacBench 的标准化基准测试平台,用于评估不同触觉传感器和模型在各种任务上的表现。

测试结果表明,Sparsh 模型在 TacBench 的六项任务中均表现出色,尤其是在数据量有限的情况下,其性能远超传统的特定任务和特定传感器模型。 例如,在力估计和滑动检测任务中,即使只使用1% 的标注数据,Sparsh 模型也能取得令人满意的结果。 这意味着 Sparsh 可以帮助机器人更好地理解物体的物理特性,并进行更精细的操控。

Sparsh 模型的发布标志着 AI 触觉感知领域取得了重大突破。 未来,随着更多数据的积累和模型的进一步优化,Sparsh 有望彻底改变机器人与物理世界交互的方式,推动机器人技术在更广泛的领域得到应用。

论文地址:

https://scontent-sjc3-1.xx.fbcdn.net/v/t39.2365-6/464969941_1107633400780143_7479102347328147009_n.pdf?_nc_cat=103&ccb=1-7&_nc_sid=3c67a6&_nc_ohc=y8Ui1HEw3BQQ7kNvgFe-ePu&_nc_zt=14&_nc_ht=scontent-sjc3-1.xx&_nc_gid=AeaFsuZziasVwPfMQsEoZqu&oh=00_AYAMqxGq0ATCySDxZWB0ZT8BgSkogYmj13c9f3ytVtkmSg&oe=672DEEE4