在开源AI领域,与大型科技公司的差距不仅仅体现在算力上。AI2(前Allen人工智能研究所)正通过一系列开创性举措缩小这一鸿沟,其最新发布的Tülu3后训练方案,让"原始"大语言模型转化为实用AI系统变得触手可及。

与普遍认知不同,基础语言模型在预训练后并不能直接投入使用。事实上,后训练过程才是决定模型最终价值的关键环节。正是在这个阶段,模型从一个"无所不知"却缺乏判断力的网络,转变为具有特定功能导向的实用工具。

长期以来,各大公司对后训练方案讳莫如深。虽然任何人都能用最新技术构建模型,但要让模型在特定领域(如心理咨询或研究分析)发挥作用,则需要独特的后训练技术。即便是Meta的Llama这样标榜"开源"的项目,其原始模型的来源和通用训练方法仍是严格保密的。

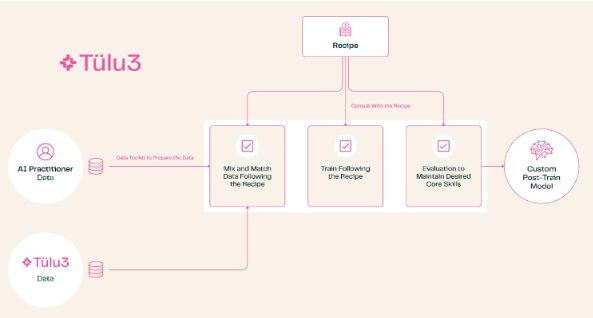

Tülu3的出现改变了这一现状。这套完整的后训练方案涵盖了从主题选择到数据治理,从强化学习到微调等全方位流程。用户可以根据需求调整模型能力,比如强化数学和编程能力,或降低多语言处理优先级。

AI2的测试显示,经Tülu3训练的模型性能已达到顶级开源模型水平。这一突破意义重大:它为企业提供了一个完全自主可控的选择。特别是对医疗研究等处理敏感数据的机构来说,不必再依赖第三方API或定制服务,可以在本地完成全流程训练,既节省成本又保护隐私。

AI2不仅发布了这套方案,还率先将其应用于自家产品。虽然目前的测试结果基于Llama模型,但他们已计划推出基于自家OLMo且经Tülu3训练的全新模型,这将是一个真正从头到尾完全开源的解决方案。

这次技术开源不仅展现了AI2推动AI民主化的决心,更为整个开源AI社区注入了一针强心剂。它让我们离真正的开放、透明的AI生态系统更近了一步。