随着全球化的不断深入,神经机器翻译(NMT)技术在跨语言交流中扮演着越来越重要的角色。尽管目前的翻译工具在处理技术文档和简单文本时表现出色,但在文学文本的翻译上依然面临诸多挑战。文学作品中常常包含隐喻和比喻等富有文化和情感内涵的表达方式,传统的翻译系统往往难以准确传达其深层含义。

为了弥补这一不足,腾讯研究团队推出了名为 DRT-o1的新型翻译系统。该系统包含两个版本:DRT-o1-7B 和 DRT-o1-14B。这两款模型基于 Qwen2.5进行构建,并引入了一种全新的多代理框架,专门针对隐喻和比喻的翻译进行优化。研究团队从古登堡项目中收集了约400本公共领域的英语书籍,提取了577,600个句子,并筛选出63,000个包含比喻和隐喻的句子,以作为训练数据。

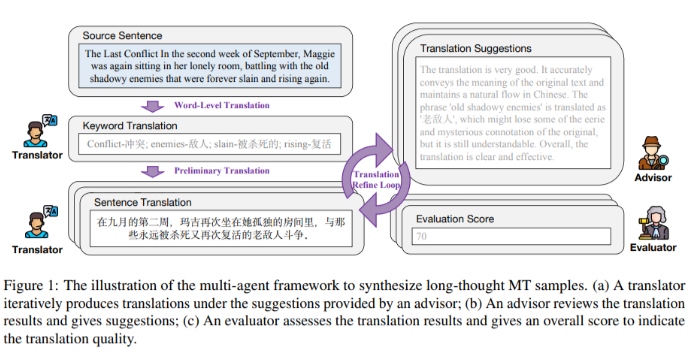

DRT-o1系统采用了一个由三种角色组成的协作方法:翻译者、顾问和评估者。这个多代理框架的工作流程始于对源句中关键术语的识别和逐个翻译,确保语境的准确性。生成初步翻译后,经过多轮的改进与评估,最终形成流畅且易于理解的译文。该系统在翻译文学作品时,能够更好地捕捉其文化内涵和情感细腻之处。

实验结果显示,DRT-o1-7B 的 BLEU 得分提高了8.26分,COMET 得分提高了3.36分,优于其前身 Qwen2.5-7B-Instruct。DRT-o1-14B 同样表现出色,BLEU 得分提升了7.33分,COMET 得分提升了1.66分。这些结果表明,DRT-o1在文学翻译中的表现超越了现有模型,尤其是其7B 版本甚至超越了更大的 QwQ-32B 模型。

DRT-o1系统通过引入多代理框架和长链推理方法,为神经机器翻译领域带来了突破性的进展。它不仅提升了翻译的准确性和流畅度,更为复杂文学文本的翻译提供了新的解决方案。

项目入口:https://github.com/krystalan/DRT-o1

划重点:

🌟 DRT-o1系统包含两种版本(7B 和14B),采用多代理框架优化隐喻和比喻的翻译。

📚 研究团队从400本公共领域书籍中提取并筛选了63,000个文学句子作为训练数据。

🚀 DRT-o1在 BLEU 和 COMET 得分上均显著提升,展现出强大的文学翻译能力。