在人工智能领域,阿里通义实验室团队近日宣布开源其最新研发的多模态模型 ——R1-Omni。这一模型结合了强化学习与可验证奖励(RLVR)方法,展现出了在处理音频和视频信息方面的卓越能力。R1-Omni 的亮点在于其透明性,让我们得以更清晰地理解各模态在决策过程中的作用,尤其是在情绪识别等任务中。

随着 DeepSeek R1的推出,强化学习在大模型的应用潜力被不断挖掘。RLVR 方法为多模态任务带来了新的优化思路,能够有效处理几何推理、视觉计数等复杂任务。尽管目前的研究多集中于图像和文本的结合,但通义实验室的最新探索则拓展了这一领域,将 RLVR 与视频全模态模型结合,充分展示了技术的广泛应用前景。

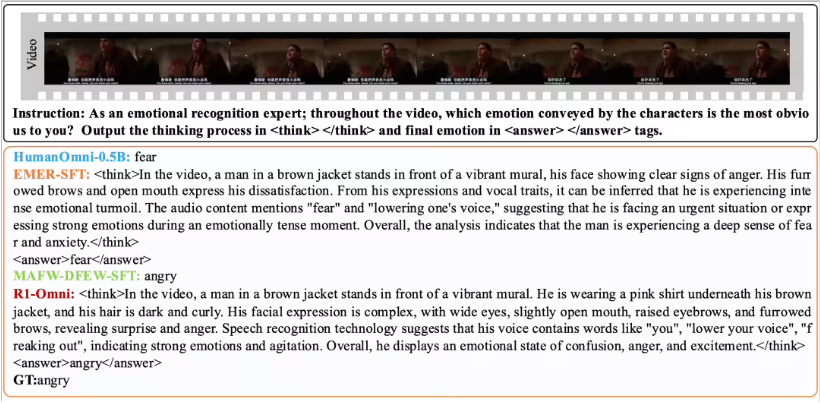

R1-Omni 通过 RLVR 方法,使音频和视频信息的影响变得更加直观。例如,在情绪识别任务中,模型能够清晰展示哪些音视频信号对情绪判断起到了关键作用。这种透明性不仅提高了模型的可靠性,也为研究人员和开发者提供了更好的洞察。

在性能验证方面,通义实验室团队将 R1-Omni 与原始 HumanOmni-0.5B 模型进行了对比实验。结果表明,R1-Omni 在 DFEW 和 MAFW 数据集上的表现均有显著提升,平均提高超过35%。此外,相较于传统的监督微调(SFT)模型,R1-Omni 在无监督学习(UAR)上也提升了超过10%。在不同分布测试集(如 RAVDESS)上,R1-Omni 展现出了卓越的泛化能力,WAR 和 UAR 均提高超过13%。这些成果不仅证明了 RLVR 在提升推理能力上的优势,也为未来的多模态模型研究提供了新的思路和方向。

R1-Omni 的开源将为更多研究人员和开发者提供便利,期待这一模型在未来的应用中能够带来更多创新和突破。