近日,Arc Prize 基金会发布了一项全新的测试 ——ARC-AGI-2,旨在测量人工智能(AI)模型的通用智能水平。该基金会由著名 AI 研究者 François Chollet 共同创立。根据基金会的博客,这项新测试对大多数领先的 AI 模型提出了严峻挑战。

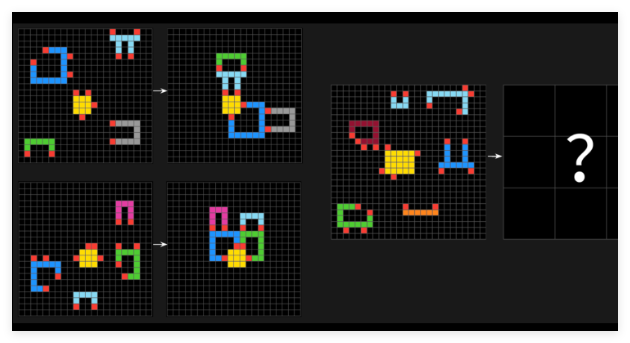

根据 Arc Prize 排行榜,诸如 OpenAI 的 o1-pro 和 DeepSeek 的 R1等 “推理型” AI 模型在 ARC-AGI-2测试中的得分仅在1% 到1.3% 之间,而更为强大的非推理模型,例如 GPT-4.5、Claude3.7Sonnet 和 Gemini2.0Flash 的得分也大约在1%。ARC-AGI 测试包含了一系列拼图问题,要求 AI 从不同颜色的方块中识别出视觉模式,并生成正确的 “答案” 网格。这些问题旨在迫使 AI 适应未曾见过的新问题。

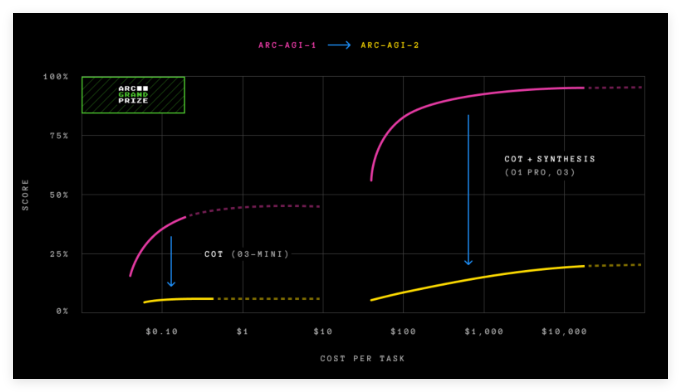

为了建立人类基准,Arc Prize 基金会邀请了超过400人参与 ARC-AGI-2测试。这些人群的平均得分为60%,远远超过任何 AI 模型的得分。Chollet 在社交媒体上表示,ARC-AGI-2比前一个版本 ARC-AGI-1更能有效地测量 AI 模型的实际智能。新的测试旨在评估 AI 系统是否能高效地获取超出其训练数据的新技能。

与 ARC-AGI-1相比,ARC-AGI-2的设计改进了多个方面,尤其是引入了 “效率” 这一新指标,并要求模型在没有依赖记忆的情况下即时解释模式。正如 Arc Prize 基金会的共同创始人 Greg Kamradt 所言,智力不仅仅体现在解决问题的能力上,效率同样是一个关键因素。

值得注意的是,OpenAI 的 o3模型在 ARC-AGI-1中以75.7% 的得分无人能敌,直到2024年才被超越。然而,o3在 ARC-AGI-2中的得分却仅为4%,在每个任务上的计算成本高达200美元。ARC-AGI-2的发布正值技术界对新的 AI 进展衡量标准的呼声日益高涨。Hugging Face 的联合创始人 Thomas Wolf 曾表示,AI 行业缺乏足够的测试来衡量被称为人工通用智能的关键特征,包括创造力。

与此同时,Arc Prize 基金会还宣布了2025年的 Arc Prize 竞赛,挑战开发者在 ARC-AGI-2测试中达到85% 的准确率,而每个任务的花费仅为0.42美元。

划重点:

🌟 ARC-AGI-2是 Arc Prize 基金会新推出的测试,旨在衡量 AI 的通用智能水平。

📉 目前顶尖 AI 模型在该测试中的得分普遍较低,远不及人类的平均水平。

🏆 Arc Prize 基金会还将举办挑战赛,鼓励开发者以低成本提高 AI 在新测试中的表现。