近日,字节跳动(ByteDance)正式公布了其最新AI项目“DreamActor-M1”,一项旨在革新视频生成技术的前沿成果。这款模型通过结合一张静态照片和一段参考动作视频,能够将照片中的人物无缝替换到视频场景中,生成表情细腻、动作自然且画质高清的动态影像。这一技术的亮相,不仅标志着字节跳动在生成式AI领域的又一次突破,也被视为对现有动画生成工具(如Runway的Act-One)的有力挑战。

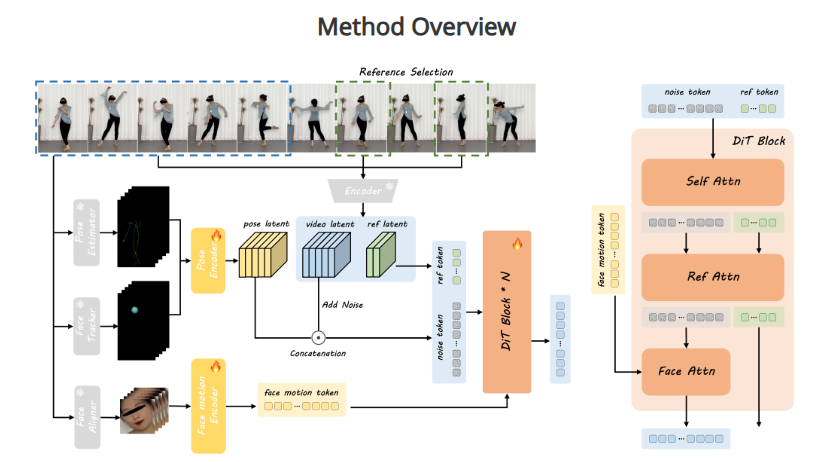

DreamActor-M1的核心创新在于其对细节的精准把控和一致性表现。传统图像到视频的生成方法往往面临诸多难题,例如表情刻画不够生动、动作过渡不自然,以及在长视频中细节失配或“穿帮”的问题。而DreamActor-M1通过先进的算法设计,成功克服了这些技术瓶颈。无论是人物微笑时的嘴角弧度、眨眼时的自然节奏,还是嘴唇轻颤的细微变化,该模型都能以惊艳的真实感呈现。同时,它还能同步控制身体动作,例如转头、抬手甚至跳舞等复杂行为,确保画面整体的协调性和流畅性。

据技术分析,这一成果可能得益于字节跳动在深度学习和视频处理技术上的深厚积累。DreamActor-M1不仅能够捕捉参考视频中的动作模式,还能将这些模式与静态照片中的人物特征无缝融合,生成的结果既保留了原始身份的独特性,又避免了常见的“失真”或“乱动”现象。这种高保真度的输出,使其在画质上达到了高清标准,为用户提供了接近真实拍摄的视觉体验。

业内专家指出,DreamActor-M1的推出填补了AI视频生成领域的一项重要空白。与Runway的Act-One等现有技术相比,该模型在细粒度控制(如微表情的再现)和多维度动作同步(如面部与肢体的协调)上表现尤为突出。这一特性使其在多种应用场景中具备广阔前景。例如,在影视制作中,导演可以利用单张照片快速生成角色的动态表演;在社交媒体领域,用户可以将自己的照片转化为生动有趣的动画视频;在教育或虚拟现实领域,这一技术也能为沉浸式内容创作提供支持。

然而,DreamActor-M1的亮相也引发了关于技术应用的深层思考。其高度逼真的生成能力可能为数字内容创作带来革命性变化,但同时也可能加剧关于深度伪造(deepfake)和隐私保护的讨论。字节跳动尚未透露该模型的具体训练数据来源或商业化计划,但外界普遍期待其能在未来提供更多细节,以平衡技术创新与伦理规范。

作为TikTok的母公司,字节跳动近年来在AI领域的布局日益深化。从图像生成到视频动画,其技术研发正不断向更复杂的多模态方向迈进。DreamActor-M1的发布,不仅是对自身技术实力的又一次证明,也是在全球AI竞赛中迈出的坚实一步。可以预见,随着这一模型的进一步完善与推广,它或将重新定义视频内容的创作方式,为用户和行业带来更多惊喜与可能性。

项目地址:https://grisoon.github.io/DreamActor-M1/