相关AI新闻推荐

Brightpick 推出新型仓库机器人Giraffe:可以到达 20 英尺高的货架

自主移动机器人(AMR)制造商 Brightpick 周二宣布,其产品线将新增一款高端产品——Giraffe 系统。这款机器人以其独特的可伸缩平台引人注目,能够达到20英尺(6米)的高度,轻松触及传统 AMR 和人类无法企及的仓库货架顶部。这一创新设计为仓库管理带来了全新的解决方案。Giraffe 的核心在于其伸缩臂,由三个重叠部分组成,完全收起时长度为8.5英尺。与 Brightpick 现有的 Autopicker 机器人协同工作,Giraffe 能够高效地从高架货架上挑选物品。Autopicker 配备两个供应箱,可伸展至11英尺,与 Giraffe

哈佛大学华人研究员Jeffrey Wang加盟OpenAI 专注模型预训练和推理工作

近日,哈佛大学的华人研究员 Jeffrey Wang 正式加入了 OpenAI,担任基础团队的研究员,专注于模型预训练和推理工作。这一消息引发了广泛关注,OpenAI 的联合创始人兼总裁 Greg Brockman 也在第一时间对 Jeffrey 的加入表示热烈欢迎。Jeffrey Wang 的学术背景相当引人注目。他毕业于加利福尼亚的一所高中,期间便因 “开发统计方法以探测3D 基因组结构变化” 而获得国家级奖项,成功入围被誉为美国 “少年诺贝尔奖” 的再生元科学天才奖。他于2021年进入哈佛大学学习,主攻数学和计算机科学,同时

DiffSensei:自动将书面故事转换为漫画风格的人工智能系统

近日,研究人员开发了一种创新的人工智能系统——DiffSensei,能够自动将书面故事转换成漫画风格。这一系统不仅可以保持角色外观的一致性,还能控制漫画页面的布局,展现了AI在漫画创作领域的巨大潜力。该项目是由北京大学、上海人工智能实验室和南洋理工大学联合研发的,结合了扩散模型与大型语言模型,旨在处理漫画创作中的视觉和叙事元素。为了展示DiffSensei的功能,研究团队创作了一部虚构漫画,讲述了人工智能领域先驱杰弗里·辛顿、扬·勒昆和约书亚·本吉奥的故事。漫画

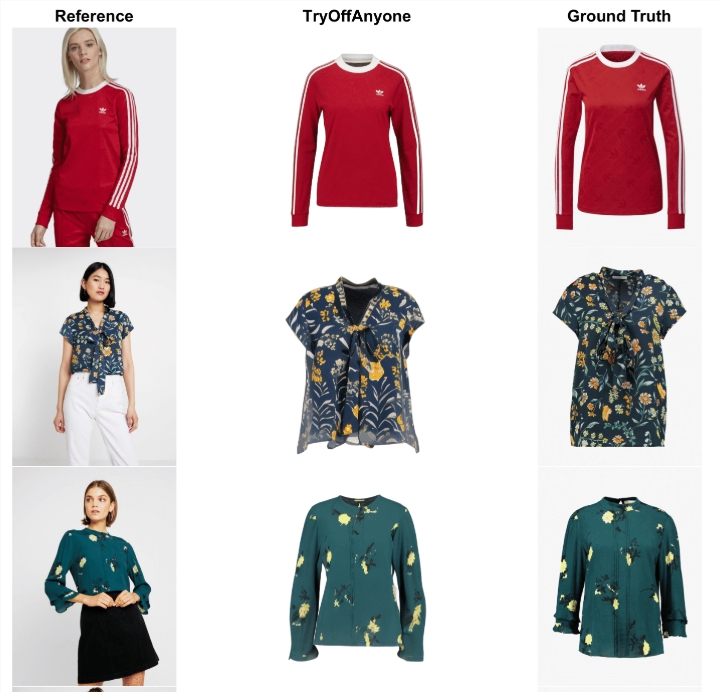

TryOffAnyone:AI试衣反向操作,可提取人物身上穿的衣服

近日,研究者们推出了一项名为 “TryOffAnyone” 的创新技术,旨在从穿着衣物的模特中生成各种服装的图像。简单的说,这与AI试衣的产品相反,该技术可以从人物身上提取出他穿的衣服。该项目的核心功能是利用深度学习算法,通过分析用户上传的图片,生成与原图中穿着者相符的多样化服装图案。使用这一模型的过程相当简单,用户只需提供一张图片的 URL,程序便能自动处理并生成相应的服装图像。生成的结果会保存在项目的指定数据目录中,方便用户进行查看和下载。此外,研究团