相关AI新闻推荐

VLM-R1引领视觉语言模型新纪元 多模态AI迎来新突破

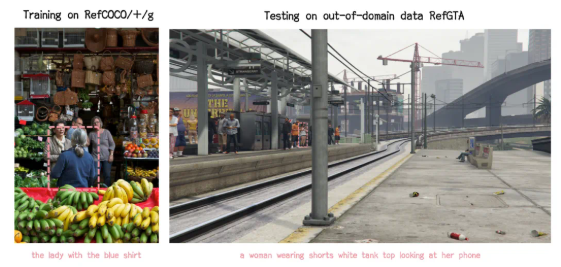

近日,VLM-R1项目的成功推出为这一领域带来了新的曙光。该项目是 DeepSeek 团队的 R1方法在视觉语言模型中的成功迁移,意味着 AI 对视觉内容的理解将进入一个全新的阶段。VLM-R1的灵感源自于去年 DeepSeek 开源的 R1方法,该方法利用了 GRPO(Generative Reward Processing Optimization)强化学习技术,在纯文本处理上取得了优异的表现。如今,VLM-R1团队将这一方法成功地应用于视觉语言模型,为多模态 AI 的研究开辟了新天地。在项目的验证结果中,VLM-R1的表现令人惊艳。首先,R1方法在复杂场景下展现出

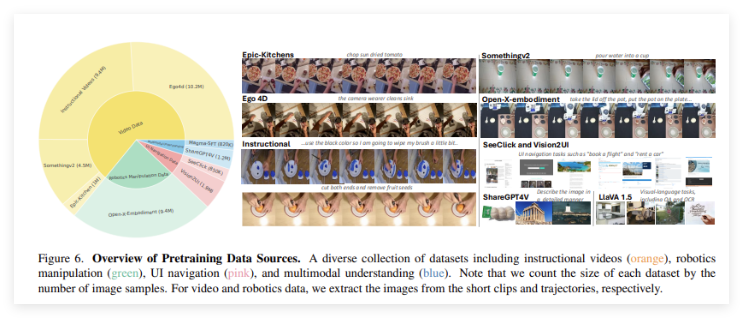

微软团队推多模态AI模型Magma:整合视觉、语言和动作决策技能

近日,微软研究团队联合多所高校的研究人员,发布了一款名为 “Magma” 的多模态 AI 模型。这款模型的设计旨在处理和整合图像、文本和视频等多种数据类型,以便在数字和物理环境中执行复杂任务。随着科技的不断进步,多模态 AI 代理正在被广泛应用于机器人技术、虚拟助手和用户界面自动化等领域。以往的 AI 系统通常专注于视觉 - 语言理解或机器人操作,难以将这两种能力结合成一个统一的模型。许多现有模型虽然在特定领域内表现良好,但在不同应用场景中的泛化能力较差。例如

智谱AI:Agentic GLM全面登陆三星Galaxy S25系列

2025年2月11日,北京智谱华章科技有限公司宣布,其研发的Agentic GLM全面登陆三星最新款手机Galaxy S25系列。这一合作标志着全球首款支持多模态AI交互的智能手机正式推向市场,为用户带来了前所未有的智能体验。智谱华章自2023年4月开启Agent智能体相关研究,并于2024年10月推出首个Agent产品AutoGLM,率先提出Phone Use理念。基于在智能体领域的深厚技术积累,智谱与三星展开合作,将Agentic GLM的强大功能集成到Galaxy S25系列手机中。该手机不仅支持基于AI的实时语音和视频通话,还能够实现视觉理解

消息称阿里引入顶级人工智能科学家 或将加码AI To C业务

近期,阿里巴巴在AI领域迎来了一位重量级人物。据业内人士透露,一位全球顶级人工智能科学家已于近期正式入职阿里巴巴,未来或将专注于AI To C业务的基础大模型研发与应用。这位科学家在工业界和学术界均拥有超过20年的经验,尤其在多模态AI领域成果丰硕,曾主导发表过上百篇大模型顶级论文。