相关AI新闻推荐

调查:52%美国成年人使用过AI聊天机器人

美国埃隆大学的一项调查显示,52%的美国成年人都曾使用过像ChatGPT、Gemini、Claude这样的AI大语言模型。这项由北卡罗来纳州埃隆大学“想象数字未来中心”在1月份开展的调查,选取了500名受访者。结果发现,在使用过AI的人群中,34%的人表示至少每天会使用一次大语言模型。其中,ChatGPT最受欢迎,72%的受访者都用过;谷歌的Gemini位居第二,使用率为50% 。图源备注:图片由AI生成,图片授权服务商Midjourney越来越多的人开始和AI聊天机器人建立起特殊的关系。调查显示,38%的用户认为大语言模

百万成本揭秘LLM训练黄金法则,阶跃星辰推出全领域适用的超参数优化工具

在人工智能的激烈竞争中,一场耗资百万美元的大规模实验正悄然改变着大语言模型的训练方式。阶跃星辰研究团队日前发布重磅研究成果,他们通过耗费近100万NVIDIA H800GPU小时的算力,从零开始训练了3,700个不同规模的模型,累计训练了惊人的100万亿个token,揭示出一条被称为"Step Law"的普适性缩放规律,为大语言模型的高效训练提供了全新指南。这项研究不仅仅是对超参数优化的探索,更是第一个全面考察模型最优超参在不同形状、稀疏度和数据分布下稳定性的工作。研究结果表明,无

CMU 团队推出元强化微调:提升大语言模型推理能力的新范式

在人工智能领域,大语言模型(LLM)正在不断进化,最近,卡内基梅隆大学(CMU)与 HuggingFace 的研究者们共同提出了一种名为 “元强化微调”(Meta Reinforcement Fine-Tuning,简称 MRT)的新方法。这一方法旨在优化大语言模型在测试时的计算效率,尤其是在解决复杂推理问题时,表现尤为突出。研究表明,现有的大语言模型在推理过程中常常消耗过多的计算资源,而 MRT 的目标是让模型在给定的计算预算内,实现更高效的答案发现。该方法将大语言模型的输出分割成多个片段,以便在探索与利用之间

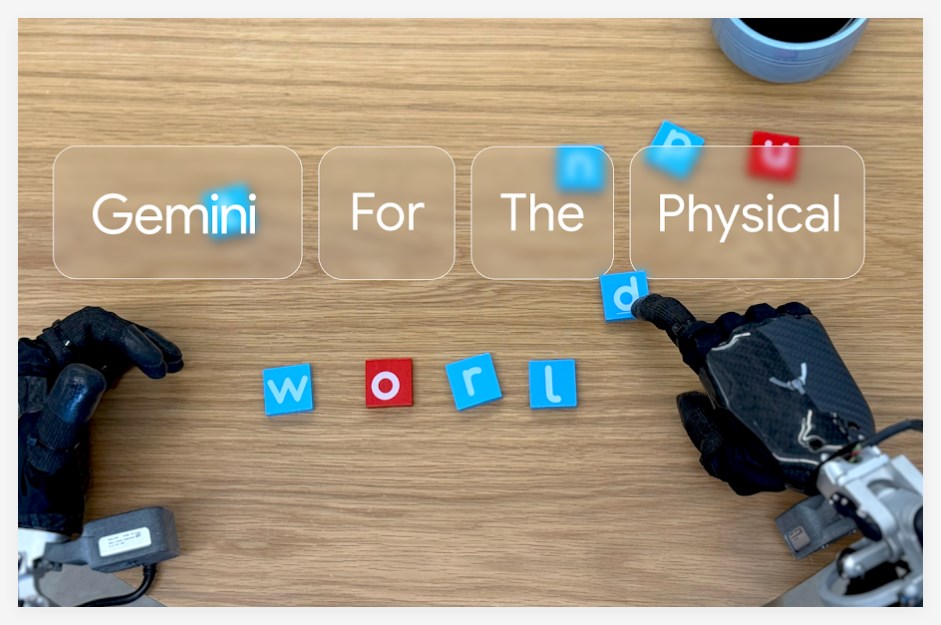

谷歌推机器人控制模型Gemini Robotics,让机器人像人类一样思考行动

谷歌DeepMind推出了他们的秘密武器——Gemini Robotics! 这可不是你家扫地机器人那点小打小闹,而是要将AI的智慧真正注入钢铁之躯,让机器人也能像咱们一样(甚至更聪明地)在物理世界里大显身手。无所不能的“多面手”Gemini Robotics的核心在于其基于先进的Gemini2.0模型。要知道,Gemini本身就具备处理文本、图像、音频和视频的强大能力。而Gemini Robotics更进一步,让机器人拥有了理解物理空间并采取行动的“超能力”。这意味着,无论是应对文字指令、识别眼前画面、听懂你的“灵魂”语音