8月25日,阿里云推出大规模视觉语言模型Qwen-VL,支持中英文多语种,具备文本和图像的联合理解能力。Qwen-VL基于阿里云此前开源的通用语言模型Qwen-7B,相较其他视觉语言模型,Qwen-VL新增了视觉定位、图像中文字理解等能力。Qwen-VL已在GitHub获得3400多星,下载量超过40万。视觉语言模型被视为通用AI的重要演进方向。业界认为,支持多模态输入的模型能提升对世界的理解能力,拓展使用场景。阿里云通过Qwen-VL的开源,进一步推动通用AI技术的进步。

相关AI新闻推荐

阿里云魔搭首发上线阶跃星辰最新开源的两款多模态模型

全球开发者目光再次聚焦中国!在备受瞩目的全球开发者大会(GDC)上,阿里云魔搭社区重磅宣布,首发上线阶跃星辰最新开源的两款多模态模型,包括 全球参数量最大的开源视频生成模型 Step-Video-T2V,以及 业界首款产品级开源语音交互模型 Step-Audio。 这一消息瞬间引爆全球AI开源社区,再次彰显中国在人工智能领域的强劲创新实力。作为中国最大的AI模型社区,阿里云魔搭社区此次发布的这两款重磅模型,无疑是近期全球多模态领域最受瞩目的开源成果。 Step-Video-T2V 以其巨大的参数规模

VLM-R1引领视觉语言模型新纪元 多模态AI迎来新突破

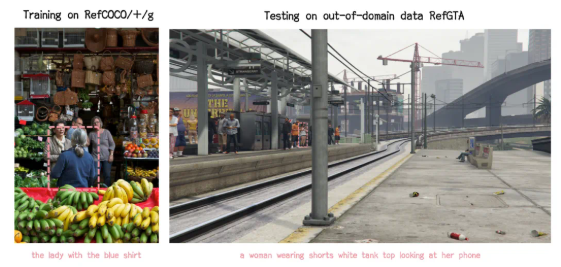

近日,VLM-R1项目的成功推出为这一领域带来了新的曙光。该项目是 DeepSeek 团队的 R1方法在视觉语言模型中的成功迁移,意味着 AI 对视觉内容的理解将进入一个全新的阶段。VLM-R1的灵感源自于去年 DeepSeek 开源的 R1方法,该方法利用了 GRPO(Generative Reward Processing Optimization)强化学习技术,在纯文本处理上取得了优异的表现。如今,VLM-R1团队将这一方法成功地应用于视觉语言模型,为多模态 AI 的研究开辟了新天地。在项目的验证结果中,VLM-R1的表现令人惊艳。首先,R1方法在复杂场景下展现出

谷歌发布全新视觉语言模型 PaliGemma 2 Mix 集成多种功能助力开发者

近日,谷歌宣布推出一款全新的视觉 - 语言模型(Vision-Language Model, VLM),名为 PaliGemma2Mix。这款模型融合了图像处理与自然语言处理的能力,能够同时理解视觉信息和文本输入,并根据需求生成相应的输出,标志着人工智能技术在多任务处理方面的进一步突破。PaliGemma2Mix 的功能非常强大,它集成了图像描述、光学字符识别(OCR)、图像问答、目标检测和图像分割等多种视觉 - 语言任务,适用于多种应用场景。开发者可以通过预训练检查点(checkpoints)直接使用这款模型,或根据自己的需求

谷歌 DeepMind 推出千亿级视觉语言数据集 WebLI-100B

谷歌 DeepMind 团队正式推出了 WebLI-100B 数据集,这是一个包含1000亿个图像 - 文本对的庞大数据集,旨在增强人工智能视觉语言模型的文化多样性和多语言性。通过这一数据集,研究人员希望改善视觉语言模型在不同文化和语言环境下的表现,同时减少各个子组之间的性能差异,从而提升人工智能的包容性。视觉语言模型(VLMs)依赖于大量数据集来学习如何连接图像与文本,从而执行如图像字幕生成和视觉问答等任务。过去,这些模型主要依赖于 Conceptual Captions 和 LAION 等大型数据集,虽然这