在人工智能领域,代码的生成与审查一直是技术进步的重要战场。OpenAI最新推出了一款基于GPT-4的模型——CriticGPT,它专门设计用来审查ChatGPT生成的代码,并找出其中的错误。这一创新工具的加入,标志着人工智能在自我监督和错误检测方面迈出了重要一步。

尽管像ChatGPT这样的大型语言模型(LLM)在生成代码方面取得了显著成就,但它们在输出的质量和正确性上仍存在不确定性。CriticGPT的诞生正是为了弥补这一缺陷。它通过生成自然语言评论来辅助人类专家更准确地评估代码,显著提高了错误检测的能力和效率。

错误检测的卓越性能

CriticGPT在识别代码中的错误方面表现出色,无论是语法错误、逻辑错误还是安全漏洞,它都能一一识别并指出。研究表明,CriticGPT检测到的错误数量甚至超过了人类评估者,这一发现在代码审查领域具有革命性意义。

减少偏见,提升合作效率

CriticGPT在减少幻觉错误方面也有显著贡献。通过与人类专家的合作,CriticGPT能够显著减少错误检测中的偏见,同时保持高效的错误识别能力。这种“人机合作团队”的工作模式,为错误检测提供了新的视角。

CriticGPT的主要功能

错误检测:CriticGPT全面分析代码,识别并报告各种错误,同时避免产生幻觉错误。

批评性评论生成:提供详细的错误分析和改进建议,帮助团队深入理解并解决问题。

增强训练效果:与人类训练师合作,提高评论的质量和覆盖范围。

减少虚假错误:采用强制采样束搜索策略,减少不必要的错误标注。

模型训练与优化:通过RLHF训练,不断优化CriticGPT的性能。

精确搜索与评估:平衡问题查找与误报之间的关系,提供精准的错误报告。

人类与AI协作增强:作为辅助工具,提高评估效率和准确性。

技术方法与实验结果

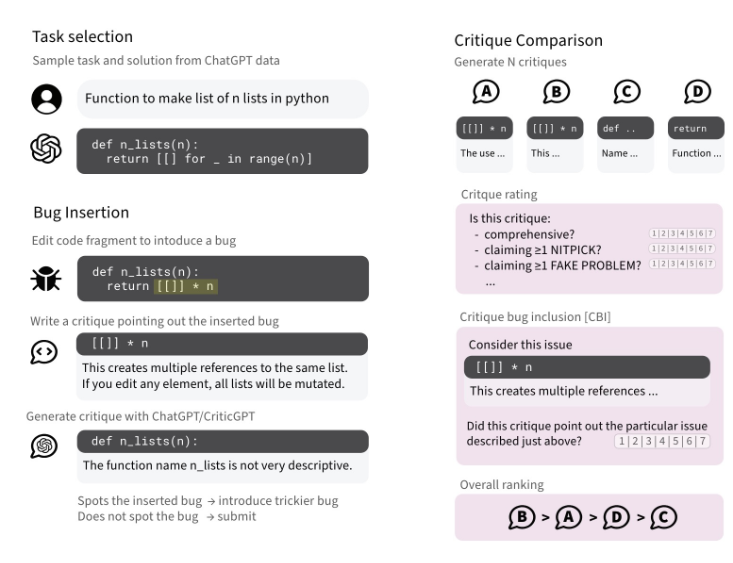

CriticGPT通过强化学习从人类反馈中进行训练,专注于处理包含错误的输入。研究人员通过在代码中人为插入错误并提供反馈来训练CriticGPT。实验结果显示,CriticGPT在提供批评时更受训练师青睐,其批评质量更高,更有助于发现和解决问题。

这项技术的引入不仅提升了代码审查的准确性,也为人工智能的自我监督和持续学习提供了新的可能性。随着CriticGPT的不断优化和应用,我们有理由相信,它将在提升代码质量和推动技术进步方面发挥重要作用。

论文:https://cdn.openai.com/llm-critics-help-catch-llm-bugs-paper.pdf